1. 引言

红外和可见光图像融合是将红外相机和可见光相机获取的图像进行结合,从而生成信息丰富的融合图像,以供进一步处理与识别。红外图像可基于辐射差异将目标与背景区分开来,同时可见光图像可提供符合人类视觉感知的具有高空间分辨率和清晰度的纹理细节 [1]。红外和可见光图像融合旨在将红外图像中的热辐射信息与可见光图像中的细节纹理信息进行结合,因此合理的图像信息提取方法是提升红外和可见光图像融合性能的关键。

近来年,基于多尺度的融合方法在红外与可见光图像融合领域应用越来越来广泛,常用的多尺度变换方法包括金字塔分解的融合方法 [1]、非下采样轮廓波 [2]、小波变换 [3] 等变换。近几年,刘等人 [4] 将不可分小波用于图像融合中。不可分小波在对图像分解时,不仅强调水平和垂直两个方向,而且强调各个方向,即各向同性;可同时具有紧支撑、正交性,能使融合结果图像不发生偏移;在对图像进行分解和重构时,能获得具有较高空间分辨率的图像,克服了张量积离散小波变换不能获得高的空间分辨率图像的缺点。

随着深度学习的兴起,将源图像提取的深度特征作为一种显著特征常用于图像融合中。Yu Liu等人提出了一种基于卷积稀疏表示(CSR)的融合方法 [5],该方法利用CSR提取多层特征,然后利用这些细节特征得到融合图像。Yu Liu等人 [6] 也提出了一种基于卷积神经网络(CNN)的融合方法,该方法利用CNN网络提取图像的多层特征,将图像融合中活动水平测量和权重分配两个关键问题作为一个整体来实现,解决了传统融合方法中复杂融合框架设计的困难。Gatys等人 [7] 提出了一种基于CNN的图像风格转移方法,使用VGG-Net [8] 分别从内容图像、风格图像和生成图像中提取不同层次的深度特征,通过迭代减小生成图像与源图像深度特征的差异。黄迅等人 [9] 利用VGG-Net和自适应实例归一化构造了一种新的样式传递网络框架。这些方法有一个共同点,它们都利用深度学习提取图像不同层次的深度特征,并将这些特征用于图像融合中。

鉴于不可分小波和深度学习的特点,本文提出了一种新的基于二通道不可分小波与深度学习的红外与可见光图像融合方法。首先,利用二通道不可分小波将源图像分解为低频图像和高频图像,使用基于L1范数取大的融合规则对低频图像进行融合;其次,将不可分小波分解得到的高频图像,用在ImageNet上训练固定的VGG-19深度学习网络提取高频图像多层特征,尽可能保留更多高频图像特征信息,对于每一层的特征,我们使用soft-max算子得到权重图,并得到候选的融合高频子图;然后,将相同的操作应用于前三层,我们将得到三个候选的融合高频子图,采用最大值选择策略得到最终的高频图像;最后,做不可分小波逆变换,融合低频图像和高频图像得到最终的融合图像。实验结果表明,与其他方法相比,本文方法在主观视觉和客观指标评价上都取得了更好的结果。

2. 具有紧支撑、正交性的二维二通道不可分小波与滤波器组

2.1. 不可分小波变换

设

,

为二维母小波函数,M为

抽样矩阵。设

为平移向量,令:

。若

,则其二维小波变化定义为:

。在离散小波变换时,M表示小波变换后的抽样方式,

因此M也称为抽样矩阵。

即

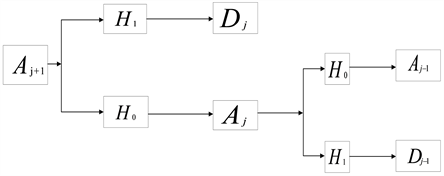

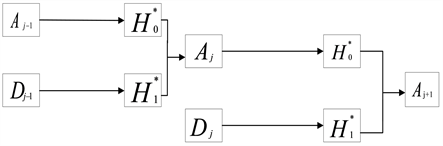

。根据二维小波变换理论及多尺度分析的理论 [4],此时对图像进行一个低通通道和一个高通通道的小波分解。若设分解的一个低通滤波器和一个高通滤波器分别为:

,

,则有图1的图像二通道不抽样小波分解和图2的图像二通道不抽样小波重构过程,其中

、

、

分别为尺度指标为

、j、

时的图像的近似分量,即图像的低频成分,

、

分别为尺度指标为j、

时的图像的高频成分,M为抽样矩阵,

、

分别为二通道小波分解的低通和高通滤波器,

、

分别为

、

相对应的二通道小波重构低通滤波器和高通滤波器。图1、图2中只给出了两层分解,实际上还可以进行多层小波分解与重构。

Figure 1. Image two-channel wavelet decomposition

图1. 图像的二通道小波分解

Figure 2. Image reconstruction based on two-channel wavelet

图2. 图像的二通道小波重构

从以上二通道小波多尺度分解的理论可以看出,小波分解的实质是近似分量图像分别在低通滤波器和高通滤波器的作用下,分解出低频成分和高频成分;小波重构的实质是下一层的低频成分和高频成分分别在重构低通滤波器和重构高通滤波器的作用下,把所得的滤波结果相加得到上一层的近似分量。其对小波分解和重构的过程不涉及到尺度函数和小波的具体形式,因此在诸如图像融合等实际应用的问题中,我们主要关心的是如何构造尺度低通滤波器和小波高通滤波器。

2.2. 紧支撑性、正交性滤波器组的构造

因为Daubechie [10] 证实了小波分解的实现是信号或图像和离散滤波器进行卷积完成的,所以利用小波对图像进行处理的核心问题就是小波低通滤波器和高通滤波器的构造。Chen等是将MRA作为基础,采取矩阵扩充的方法,提出了一种高维不可分小波滤波器组的一般构造方法 [11],其在理论上来说可以构造出无数组滤波器。刘等人在此基础上给出了二维不可分小波滤波器的具体构造形式。

二维不可分小波变换可以由二维不可分滤波器组实现。假设不可分小波变换过程中的抽样矩阵

不可分小波滤波器组为

则具有紧支撑、正交性的二维二通道不可分滤波器的

形式可构造如下:

(1)

式中:

分别为滤波器

、

所对应的频域形式。设

,

,

为正交阵,

,

为正交阵,

为

向量,

。

为构造二通道的小波滤波器组取,K=1,构造

(2)

显然

为正交矩阵,

为正交阵。则可构造无穷多个滤波器组,

取不同的值得到不同的具有紧支撑、正交性的小波滤波器组

,

。当

时的一组滤波器的时域形式如下:

此滤波器组是不可分的,不能分解为两个一维小波滤波器的张量积,具有紧支撑的性质,是一组能能够完全重构的滤波器。

3. 基于二通道不可分小波与卷积神经网络的融合方法

如图3所示用二通道不可分小波分解红外与可见光源图像,将红外与可见光源图像分别分解为低频系数

,

和高频系数

,

。低频系数采用基于L1范数取大的融合规则得到融合低频系数

。高频系数送入预训练好VGG-19网络进行深度特征提取,分离出多个relu层得到不同尺度的特征图,特征图通过求L1范数操作后得到更为稀疏的特征图

,通过soft-max算子计算和上采样法得到与输入高频图像一样大小不同尺度的权重图

,用获得的权重图对源图像高频系数进行融合得到最终的高频系数。为了获得更加丰富的高频特征,本文将三个relu层的融合结果进行最大值策略得到最终的融合高频系数

。最后融合低频系数和融合高频系数做不可分小波逆变换得到最终的融合图像F。

Figure 3. Flow chart of fusion algorithm

图3. 融合算法流程图

4. 详细的融合规则

4.1. 低频系数融合规则

能量能较好地表征亮度,图像作小波分解后的主要能量集中在低频部分,另外,红外图像中的目标是以区域的形式存在的,单个像素不能形成目标,因此,对源图像分解得到的低频图像采用基于L1范数取大的融合规则,这样既能很好地吸收可见光图像的亮度信息,又能体现红外图像的目标特性。L1范数计算公式如下:

(3)

式(3)中,

,

是

的邻域系数。利用区域能量的大小来判断系数的活动水平,能量越大表示保留的信息越多,融合系数计算公式如下:

(4)

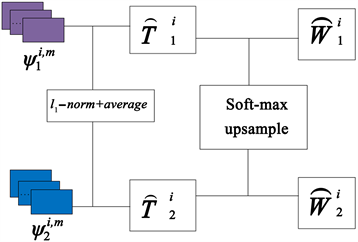

4.2. 高频系数融合规则

1) 利用VGG网络提取红外与可见光图像的深度特征,如图4所示

表示第i层提取的第k个高频细节内容的特征图,m为第i层的通道号,

,

。

(5)

其中每个

表示VGG-network中的一个层,

,

。

Figure 4. High frequency detail multilayer fusion strategy diagram

图4. 高频细节多层融合策略图

2) 由VGG-Net网络结构可知,VGG-19网络有5个block构成,本文使用前三个relu层的结果

,

,通过对每层的L1范数计算得到初级活动图

,其中i表示为第i个relu层,k为待融合图像个数k = 2,

为对应像素点。

(6)

3) 对初级活动图

进行区域均值操作求得最终的活动图,使结果更加具有鲁棒性。

(7)

式中r决定区域的大小,本文中r = 1。

4) 对刚得到的最终活动图进行soft-max操作得到初始权值图

(8)

式中N为活动图的个数,

,

。

为[0,1]范围内的初始权值映射值。

5) 由于每一个relu层的大小不一样,将得到的初始权重图上采样调整为输入高频图像大小的最终权重图

,n为上采样的倍数。

(9)

6) 对于每一对

,初始融合高频系数由式(10)得到,

和

。

(10)

7) 用最大值选择策略从三个初始融合高频系数中获得最终的融合高频系数

。

(11)

用融合的低频系数

和融合的高频图像

做不可分小波逆变换得到最终的融合图像F。

5. 仿真实验与测试

为了验证本文算法的有效性,在TNO开源数据库下进行仿真实验。实验平台是Intel (R)处理器、CPU主频2.10 GHz、内存16 GB的计算机,使用Matlab2020a仿真软件进行算法实现。本文将于近几年4种经典的融合方法进行实验比较,包括:交叉双边滤波融合方法(CBF) [12]、基于稀疏域显著性检测融合方法(SD) [13]、基于加权最小二乘优化方法(WLS) [14] 和基于联合稀疏表示的图像融合方法(JSR) [15]。本文做了大量融合实验选取其中3组红外和可见光图像,如图5所示。这些都是在红外与可见光图像融合领域常用的图像,可在网站https://figshare.com/articles/dataset/TNO_Image_Fusion_Dataset/1008029上下载到。

5.1. 实验结果及分析

5.1.1. 主观评价

实验结果如图6~8所示,CBF, SD, JSR, WLS和本文方法的实验结果依次为每组实验结果中的(a)到(e)。

第一组实验结果如图6所示。图6(a)、图6(d)红色区域内可见光信息丢失严重,融合效果较差。图6(b)、图6(c)整体偏亮,目标边缘模糊,对比度差。而本文方法所得融合图像整体更加自然,云层与建筑物的亮度和对比度适中,且红色区域内可见光信息丰富。

第二组实验结果如图7所示。图7(a)人物信息丢失严重,场景信息模糊。图7(b)、图7(c)图像整体亮度偏亮,对比度较差。图7(d)人物信息明亮,但与本文相比左下角红色框内路面细节信息模糊。图7(a)左上红框内树枝信息模糊,对比度较差。图7(e)与图7(b)、图7(c)、图7(d)相比左上红框内树枝显示更加清晰。图7(e)与图7(d)相比,左下角红框内路面更加清晰。本文方法能较好的反映源图像中所包含的所有信息,视觉效果更好。

第三组实验结果如图8所示。图8(a)、图8(b)、图8(c)图像信息比较模糊,视觉效果很差。图8(d)与图8(e)相比红色框内人物信息偏暗。本文方法目标提取完整,纹理清晰,图像亮度适中,对比度高,整体融合效果较好,更适合人类视觉感知。

5.1.2. 客观评价

鉴于红外与可见光图像融合没有统一的评价指标,因此采用了多指标评价方法,以使评价结果更加客观。为定量比较所提出的方法和现有的融合方法,本文选择信息熵EN、小波特征互信息FIM [16]、噪声评估指标Nabf [17]、结构相似性指数SSIM [18] 和边缘信息保留度QAB/F 5个常用指标来对性能进行评估。其中,信息熵是度量图像包含信息量多少的一个客观评价指标。信息熵的值越大,表示融合图像的质量越好。小波特征互信息是指融合图像中包含的信息量,值越大表明融合图像中的信息越丰富;噪声评估的融合性能值小,说明融合图像含有较少的人工信息和噪声。结构相似性指数越大,说明融合图像保存原图结构信息越多。边缘信息保留度数值越高,表示融合图像的质量越好。表1给出了3组红外与可见光源图像融合结果的客观评价结果。表中数据是每种方法在3组源图像上的平均得分。

Table 1. Objective evaluation of experimental results by different fusion methods

表1. 不同融合方法的客观评价实验结果

6. 结束语

本文提出了基于二通道不可分小波与深度学习的红外与可见光图像融合方法,将不可分小波与深度学习相结合运用到红外与可见光图像融合中。本文方法能较好的提取图像的高频特征,使得到的融合图像具有更清晰的细节信息,因此能够获得较好的融合效果。综合实验结果表明,该方法具有较好的融合性能。

基金项目

国家自然科学基金面上项目(NO. 61471160)。