1. 引言

随着人工智能技术的快速深入发展,智能机器人的研究已经成为一个重要的研究方向。复杂环境下的机器人定位算法是目前智能机器人研究的热点之一。面对层出不穷的算法,迫切需要创新算法准确性和鲁棒性的验证和评价方法,而公共数据集是验证定位算法的通用方法。

目前机器人搭载的视觉传感器的价格越来越低,图像成像的质量越来越高,在移动机器人的定位传感器选择中优势越来越大。因此,通过数据集验证视觉传感器的定位精度具有重要的研究价值。近年来,我国越来越重视新型基础设施建设,以第五代移动网络为核心的基础设施建设得到了政策的广泛支持。完善数据治理体系,开发高质量的数据集是我国新基础设施工作的重点之一,这对数据集相关研究工作具有深刻的指导意义。

在公共数据集上评估算法的准确性和效率是算法获得学术界认可的最直接方式。随着这一思想的普及和算法验证的迫切需要,机器人视觉定位领域涌现出很多数据集。广泛使用的KITTI数据集 [1] 提供室外场景视觉验证数据,EuRoC MAV数据集 [2] 提供室内小场景评价数据。这是两套相对较早、影响较大的算法评测数据。前者基于车辆,后者基于微型飞行器(Micro Air Vehicle, MAV)。

近年来,定位算法不断创新,许多以机器人为载体平台的算法需要在特殊复杂的环境中进行测试,越来越多的数据集被提出和应用。2009年提出的New College数据集 [3] 提供了以轮式机器人为载体在公园和校园环境收集的视觉定位数据。在密歇根大学北校区收集的NCLT数据集 [4] 的数据涵盖室内和室外环境。PennCOSYVIO [5] 和TUM VI [6] 使用手持设备收集室内和室外场景的高质量序列,以评估里程表和同步定位与建图(Simultaneous Localization and Mapping, SLAM)算法。ViViD数据集 [7] 使用事件摄像机在室内环境中收集数据。Segway DRIVE [8] 和The Newer College [9] 数据集考虑了具有挑战性的纹理和照明。然而,Segway DRIVE数据集只关注了商场场景的序列,而The Newer College数据集采集了开放空间和植被区域的数据。数据集的具体性质如表1所示,目前现有的数据集并没有一个标准框架定义,而且缺少重点关注弱光照和频繁变化光照环境的数据,只是在序列中提供几个相似光照条件下记录的少量数据,不能支持定位算法在光照变化频繁地真实环境中的定位效果验证。

Table 1. Comparison of complex illumination visual localization data sets

表1. 复杂光照视觉定位数据集比较表

随着视觉定位算法研究的深入,视觉定位数据集越来越重视所包含的数据能够真实地反应现实世界状况。而传统的定位数据集与定位算法已经难以满足完整、准确的场景理解需求,因此需要构建适用于复杂光照场景高精度定位的数据集,实现现实场景和视觉定位算法提升之间的衔接。

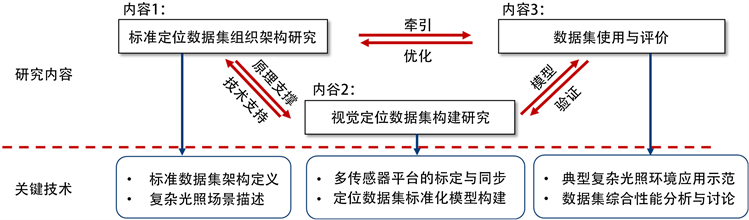

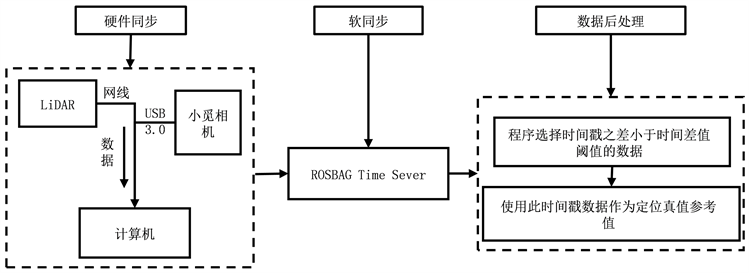

Figure 1. The research content and key technologies of this paper

图1. 本文研究内容和关键技术

围绕复杂光照环境数据集构建这一关键问题,本文对定位数据集组织架构、视觉数据集构建流程、数据集的使用和评价三个方面进行了研究,并构建了具有复杂照明特点的视觉定位数据集,具体的研究内容和关键技术如图1所示。本文对构建机器人视觉定位数据集的过程进行了完整的探索,为研究人员后续构建数据集提供可靠的参考。

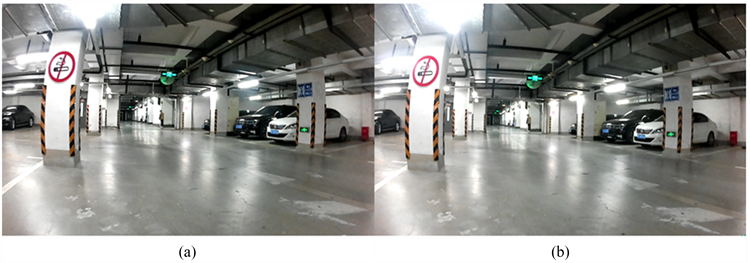

论文选择同济大学作为实验场地,在具有复杂照明特点的室内环境中进行视觉定位数据集构建,如图2所示。数据集中记录了具有多样化的场景的轨迹,例如汽车车灯闪烁和接近完全黑暗的情况,这写情况经常会在在实际应用中遇到,而以前的数据集中很少包含这些情况。

Figure 2. Data set collection scene: a garage of Tongji University

图2. 数据集采集场景:同济大学某车库

2. 视觉定位数据集组织构架

视觉定位数据集是涵盖视觉定位算法所需要的场景序列的数据集合。数据集构建者通过搭载视觉定位传感器的平台采集不同特点的场景数据,并对数据进行加工和同步,最终形成数据集。数据集选择场景主要依据的原则是高度还原复制现实世界,因此数据集中通常会选择多个场景或者是在一个场景多次遍历一个位置。在视觉定位数据集中,这些场景序列的数据主要包含了两种类型:定位算法输入数据和定位算法验证数据。

1) 定位算法输入数据

定位算法输入数据是指视觉定位需要的图片数据、视觉传感器的内参数和外参数以及数据集构建者添加到其中的特征,如物体语义特征等。

数据集中定位算法输入数据的获取涉及到数据集搭建研究人员进行的硬件配置,包括移动平台和感知传感器的选择。移动平台的主要选择有手持载体、移动背包、轮式机器人及小型无人机。不同传感器配置在实践中的表现仍需探索。因此移动平台可以根据不同环境需求配置不同的视觉感知传感器,如单目相机、双目相机、事件相机及深度相机,甚至可以配置辅助视觉定位算法的其他传感器,如IMU等。如图3所示,是双目相机在同一时间的输入数据。

一般情况,定位算法的输入数据会以图片形式(包括.png、.jpeg、.jpg等常见格式)或者ROSBAG形式提供。每一帧图像数据都会附上拍摄的时间戳信息。

由于视觉定位算法在面对不同环境时运行效果不同,由此可以给不同采集条件的场景序列进行环境复杂度定性研究,以此反映不同场景序列能够稳定运行定位算法的困难程度。

传感器间的位置关系通过外参数给出。传感器的镜头模型、内参数、外参数等信息都会由数据集制作人员提前标定并给出。

Figure 3. Image data collected by the binocular camera at the same time, (a) is the data collected by the left camera, (b) is the data collected by the right camera

图3. 双目相机在同一时刻采集的图像数据:(a) 左相机采集数据,(b) 右相机采集数据

2) 定位算法验证数据

定位算法验证数据是用作与定位算法结果进行比较的较为准确的结果,主要包括位置和姿态两个维度。根据获取数据集的场景不同,获取位置和姿态的技术也有所不同。进行姿态测量的技术主要包括动态捕捉系统、多传感器融合算法、具有RTK校正的双天线GNSS等技术。在室内环境中,尽管动态捕捉系统工作效率高、精度高,但是面向大面积的室内环境,这个解决方案布设成本太高,无法被数据集制作者广泛使用。在室内环境中,目前被广泛使用的验证数据获取设备包括追踪仪和激光雷达等。

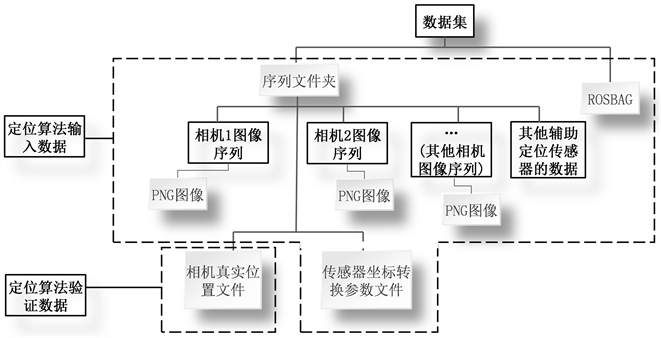

Figure 4. Visual positioning dataset organizational architecture

图4. 视觉定位数据集组织架构

视觉定位算法输入数据和视觉定位算法验证数据通过一定的组织形式共同构成完整的视觉定位数据集,具体的视觉定位数据组织构架示例如图4所示。尽管不同数据集针对不同的算法验证需求,选取的场景序列各异,而且提供的组织形式或者数据格式会有所区别,但是所有的视觉定位数据集都会具备这两种数据。

正如引言中所说,现在的视觉定位面临从明到暗或者光照频繁变化的现实场景挑战,这些场景很容易使现有的视觉定位算法失灵,将这些场景定义为复杂光照场景。面临缺少针对室内复杂光照的环境数据集的数据困境这一问题,本文根据数据采集需求搭建数据采集平台,从而构建了具有复杂光照条件的视觉定位数据集,提供视觉定位算法的实验和验证数据,并且基于此数据集评测了多种视觉定位算法。

3. 数据集构建流程与关键技术

本文提出的数据集构建方法,考虑采集的复杂环境特点,从选择传感器到搭建硬件平台,从构建软件计算传感器转换参数到提供真实位置参考值,最终构建出能供算法进行测评的室内复杂环境数据集。本章主要从硬件选型与集成、参数获取与真值设计、数据标准化处理三个方面介绍数据集构建流程。

3.1. 硬件选型与集成

数据集构建工作首先需要完成硬件系统的搭建与外部多源数据的采集和存储。本文构建的数据集基于自主搭建的机器人平台,根据室内环境多光照变化、通道窄长等特点定制搭载短基线视觉感知传感器,并对硬件进行模块化管理,存储采集的图像,以供定位算法进行输入,进而实现定位。

数据集构建硬件系统的主要包含以下设备:视觉传感器、激光传感器、照明系统、定位系统和控制平台。所有设备都连接到一个由碳板和螺钉制成的轮式机器人上,配备电源和机载计算机用于记录和存储数据,具体数据采集平台如图5所示。

Figure 5. The hardware system of the dataset

图5. 数据集的硬件系统

数据集中包括的传感器有以下几种(具体特性见表2)。

3.1.1. 视觉传感器

考虑到室内有部分环境呈现狭长、空间较为拥挤的特点,选取的传感器要保证光学系统成像清晰,做到透光性强、杂散光少,适用性强同时满足高精度和高速度获取图像的要求。因此,视觉数据考虑使用市面上消费级的多个相机组合获得,本数据集选择了广泛使用的消费级传感器MYNTEYE (小觅)相机S2110。MYNTEYE相机S2110是一个室内外通用,精度高,黑暗环境适用的相机系统,它搭载了2个200万像素(2560 × 800、1280 × 400)的鱼眼相机及1个消费级IMU,分别能够以30 Hz、200 Hz频率捕获视觉、IMU数据。

3.1.2. 激光雷达

真值获取设备是整个数据集采集系统可行性的基础。考虑室内环境的纹理条件相对较为丰富,使用激光雷达可以获取质量较高的数据,因此针对室内环境的光照变化较多的条件,使用对光照不敏感的激光雷达作为获取真值的设备。激光雷达与相机接入同一台计算机内,实现在计算机内通过系统发出指令同时实现图像采集工作和定位工作,实现了采集系统的自动化开启。本数据集选用Hokuyo (北洋) UTM-30LX激光雷达,视距长达30米,视场角打到270˚。为了防止信号遮挡和方便传感器空间信息标定,UTM-30LX激光雷达水平安装在机器人平台的正上方。

3.1.3. 照明设备

由于复杂环境中,有较多光照亮度变化的情况,导致在采集视觉定位算法所需要的视觉数据时通过视觉传感器所采集的光线不充分,所以在数据集采集平台中加上可以提高光线通过量用的设备,以保证获取的视觉定位算法输入视觉数据的质量,构造不同照明条件的序列。综合考虑价格、光源价格、损耗和获取照明稳定性等因素,考虑在机器人平台上组合使用2个白光LED灯,与视觉传感器的镜头方向平行进行调节光源。

Table 2. List of sensors and their parameters

表2. 传感器列表及其参数

3.2. 数据集构建关键技术——参数获取与真值设计

传感器一体化集成平台的构建是数据集构建的基础。由于该平台集成了不同的传感器,传感器的安置位置与姿态不同,获取数据的空间基准也有所不同,因此在数据集构建过程中要完成空间同步与时间同步。

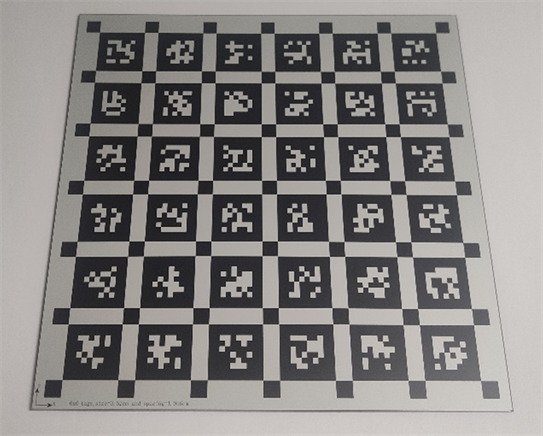

3.2.1. 空间同步——多传感器标定

空间同步是指完成传感器之间的两两标定,确定传感器间的刚性空间关系。该数据集中涉及多种类型传感器的多模态相对姿态校准,包括左相机到右相机,鱼眼相机到IMU,鱼眼相机到激光雷达。为了校准内外参数,在数据集构建时,制作了一个kalibrtag [10] [11] 30 × 30 cm的浮法玻璃基板,如图6所示,用传感器采集的标定板图案记录ROSBAG,使用Kalibr工具箱相关代码 [12] [13]。在制作ROSBAG的过程中,将标定板从不同角度旋转,以达到更好的标定效果 [14] [15]。数据集中提供焦距、畸变参数等相机校准结果,并提供两个相机的相对姿态。由于激光雷达测量的是自身的位姿,而不是相机的位姿,因此使用Cam Laser Calibra Tool [16] 完成视觉传感器和激光雷达的平面匹配,得到了激光雷达到相机的外部标定。

Figure 6. Kalibrtag float glass calibration plat

图6. Kalibrtag浮法玻璃标定板

3.2.2. 时间同步

时间同步是指多个传感器之间的时间戳对齐,具体的时间同步图如图7所示。2个鱼眼相机和IMU通过内置芯片进行硬件同步,误差保持在5ms以内。激光雷达和视觉传感器采集数据的方式不同,激光雷达数据用于提供地面真实位姿数据,因此假设每个序列激光雷达数据有固定的时间偏移量,采用最小化绝对轨迹误差(Absolute Trajectory Error, ATE)的均方根误差(Root Mean Squard Error, RMSE)的方法确定不同传感器之间的最佳时间偏移量,以达到同步轨迹的目的。相机和IMU的轨迹相对激光雷达计算得出的轨迹来进行绝对轨迹误差ATE的同步。

为了降低定位算法计算时产生的累计误差和测量过程中产生的噪声,数据集构建和处理数据时,在每个数据序列采集的起始阶段,都对用于同步处理的部分数据进行设计。数据集采集过程的初始阶段,选取纹理较丰富、光照条件良好的环境,通过对机器人平台进行控制低速运行,获得稳定鲁棒的数据,用起始阶段的数据来进行同步处理。由于最小化绝对轨迹误差ATE的方法本身受到尺度的影响较大,如果两条数据输入轨迹的尺度稍有不同,就会引进系统性误差,因此在本数据集中不使用整条轨迹数据进行同步处理,而是只选择起始阶段的低速运行的数据来进行时间偏移量的确定,避免造成时间偏移量的不准确。通过确定最佳时间偏移量的估计一致性来对同步数据的质量进行评估。

Figure 7. Flow chart of sensors time synchronization

图7. 传感器时间同步流程图

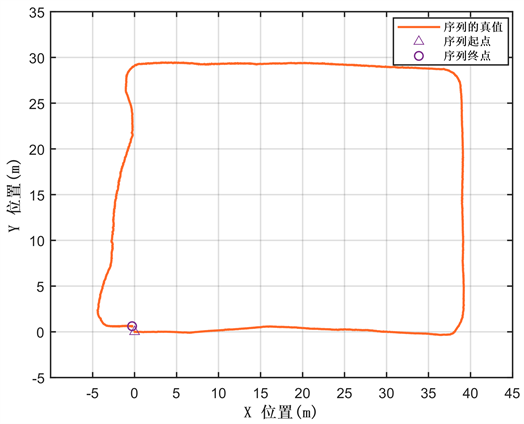

3.2.3. 数据集真实位姿值获取

由于数据集构建的实验场景场景面积超过1000平方米,本文没有像文献 [2] 中使用动作捕捉系统来生成实际真实的位姿数据,而是使用精度较高的LiDAR SLAM方法交叉校正LiDAR SLAM作为参考位姿,具体实例见图8。数据集是在平坦地形中收集的,因此可以高度变化可以忽略不计。通过激光雷达获取单线激光数据,并通过文献 [17] 中提出的交叉校正LiDAR SLAM方法进行高精度位姿计算,以获得每个相机的相对位姿精度。该数据集中的序列以30Hz的频率提供经过2D-SLAM算法处理后的位姿数据,定位精度达到了厘米级。通过单线激光雷达数据获取模块能够提供相对高频率高精度的位姿估计。

Figure 8. The results obtained by cross correction of LIDAR-SLAM method in Indoor_HARD_002 sequence

图8. 在Indoor_HARD_002序列中通过交叉校正LiDAR-SLAM方法计算得出的结果

3.3. 数据标准化处理

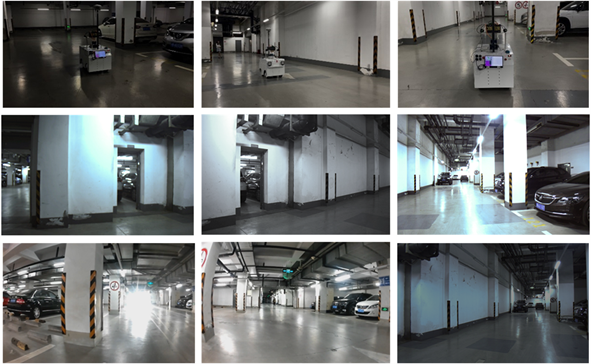

3.3.1. 数据采集环境与环境复杂度特征

本文选择同济大学地下停车场一层作为记录站点,实验环境如图9所示。试验场占地面积约7000平方米,环境空旷,标志物较少,光线条件较为复杂,包括人工和自然日光的混合光照条件。此环境可进行视觉定位算法的压力测试。

Figure 9. Representative image of the underground parking

图9. 地下停车场的代表图像

根据定位算法在实际应用中所面临的挑战,并结合影响定位精度的光照条件对环境进行分级。“复杂光照”只是对环境条件的总结,不同的光照水平对算法的影响是不同的。在该数据集中,将复杂照明分为外部照明效果和内部照明效果。外部光线分为强光、中光、弱光和频繁变化四个层次。内置光源是指机器人设备有自己的光源,包括机器人提供光源和不提供光源两种情况。根据环境的复杂光照条件分级,该数据集包括4个序列,具体序列属性见表3。

Table 3. Properties of data set sequences

表3. 数据集序列的性质

该数据集提供不同光照条件环境的图像数据,数据示例如图10。

3.3.2. 序列描述与文件结构

在数据集构建流程中,数据集构建者通过固定框架形式组织每个序列里数据,以方便视觉定位算法研究人员进行算法验证。数据集中的每个序列包含获得传感器数据的集合,包括定位计算所需的数据和真实位姿数据。参考数据集的标准框架,使用类似于EuRoC数据集格式组织并构建数据集。

Figure 10. First line shows a positioning robot doing tasks in an underground parking lot; Second line shows different structural characteristics; Third row shows the obvious lighting changes made

图10. 第一行显示一个定位机器人在地下停车场的场景;第二行展示了地下停车库不同的结构性特点;第三行显示数据集中的照明变化场景

1) 定位算法输入数据

定位算法输入的数据包括标定参数文件、图像文件、IMU数据。标定参数文件描述传感器相关的所有属性,所有的参数文件中都包含传感器的名称以及一个描述传感器之间位置关系的4 × 4齐次变换矩阵。参数文件以YAML文件格式给出。图片数据以两种数据格式提供给用户,一种是ROSBAG格式,一种是图片格式(.png)。每个相机都有一个单独的文件夹,文件以精确到小数点后六位的时间戳命名。

2) 定位算法验证数据

定位算法验证数据是指数据集能够提供的真实位姿文件,它以TXT文件格式给出,文件中包含处理过的所有时间的机器人运行轨迹,文件由多行组成,每行信息都包括时间戳和相应的空间坐标(欧几里得空间系统)和姿态(四元数)。

具体的数据集格式如图11所示。

4. 数据集使用与评价

为了评价本文发布的数据集,本文使用激光雷达提供的位姿数据作为真实位姿并结合视觉定位算法的运行结果进行评估。参考TUM数据集的方法,用户只需要提供一个TXT文件,表示通过算法计算出给定序列的轨迹,每一行包含时间戳及三自由度的位置或者六自由度的姿势。本数据集提供每个序列的真实位姿TXT文件,根据对应两条轨迹的时间戳,通过适当的特殊欧式群(Special Euclidean Group, SE(3)) [18] 变换来对齐两条轨迹,具体变换矩阵T如公式1所示。参考TUM数据集,根据相对位姿误差(Relative Pose Error, RPE)和绝对轨迹误差(Absolute Trajectory Error, ATE)对算法的性能进行评估。

(1)

其中,变换矩阵 左上角为旋转矩阵,右侧为平移向量,左下角为 向量,右下角为 ,用表示从坐标系2到坐标系1的变换。

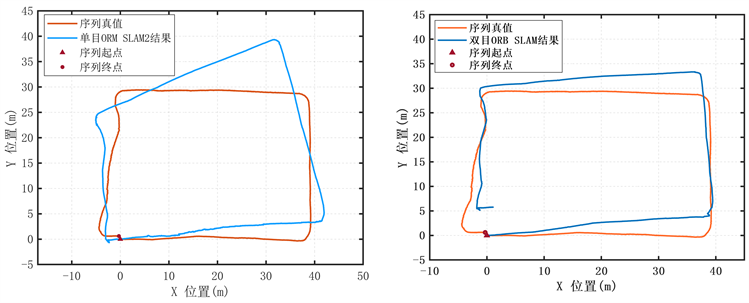

在本数据集的两个较困难的序列Indoor_HARD_001、Indoor_HARD_002上评估最先进的SLAM系统ORB-SLAM2的双目和单目版本、ORB-SLAM3的单目版本视觉定位算法的性能,使用绝对轨迹误差 (ATE) [6] 用于评估指标。算法获得的轨迹都通过EVO工具与地面实况对齐,以获得ATE误差。

在序列Indoor_HARD_001、Indoor_HARD_002中,使用小觅鱼眼相机单目数据来运行的ORB SLAM3算法运行不佳,出现严重的位置估计错误、定位丢失情况。虽然 ORB-SLAM3定位算法通过自适应直方图均衡化方法解决光照不佳问题,但算法未能在黑暗场景中提取足够的特征点,这就导致了严重的估计错误。

在序列Indoor_HARD_002中,使用小觅鱼眼相机单目和双目数据来运行ORB-SLAM2算法测试效果较好,图12中显示ORB-SLAM2的双目和单目算法在Indoor_HARD_002序列中的表现。为了更好的比较,在运行ORB-SLAM2时,禁用了算法中循环闭环部分。

Figure 12. Results of the visual localization algorithm run on the Indoor_HARD_002 sequence

图12. 视觉定位算法在Indoor_HARD_002序列上运行得到的结果

在本数据集中,ORB-SLAM2的双目版本的误差达到了米级,而根据文献 [19],此方法在EuRoC MAV数据集上获得的ATE不大于0.3 m。本数据集重点关注的光照频繁变化条件,给ORB-SLAM2也带来了巨大的挑战。

结果表明,现有最先进的视觉定位系统系统可能在现有的数据集基准中测试评估表现良好,但它们在本数据集中至少在一种情况下表现不佳,需要进一步努力来提高定位性能,仍需要显著改进才能搭载在日常生活中的服务机器人上。

5. 结论

相比于正常光照条件下的视觉定位数据集,供室内复杂光照环境的定位数据集的规模相对较少。为推动通过数据集构建来实现室内环境与视觉定位算法提升之间衔接的研究,本文主要从视觉数据集的组织架构、视觉数据集构建流程和数据集的使用与评价三方面进行了探索,并推出了用于室内复杂光照环境的定位数据集。该研究的贡献主要在于:1) 通过构建以轮式机器人为载体的数据采集平台并结合对传感器选型与同步方法的讨论,归纳出用于室内复杂光照环境数据集采集平台的设计思路。2) 根据采集平台的设计思路,本文发布了一个带有地面真实轨迹的视觉定位数据集,除了包含正常光照下的数据,该数据集还包含强光照、弱光照和频繁变化光照等条件下的数据,数据量超过400 G,时间超过1200 s。这些数据都可用于视觉导航算法的压力测试,可以作为目前此场景公开数据的有效补充,并为探索机器人领域研究中其他方向提供代表性数据,包括多传感器融合、建图和导航。3) 本文也使用自制数据集对当前主流的SLAM 系统进行了测试,并对实验方法和实验结果进行了讨论,这也为视觉定位算法未来潜在的发展方向提供参考。

在未来的研究中,研究者将继续从复杂光照条件间的特征关联方式和室内定位机理进行研究,希望通过对数据集的不断完善,为视觉定位算法提供一个可靠的综合评测基准。

基金项目

国家重点研发计划(No. 2018YFB1305003)。

参考文献

NOTES

*通讯作者。