1. 引言

农业害虫是农业生产中重要的问题,其影响了农作物的产量和质量。害虫识别是指根据植物受害的症状或直接观察到的害虫的外形特征,对害虫进行分类和鉴别的过程。该过程对农业生产至关重要,可以帮助农民快速发现和识别害虫,及时采取有效的防治措施,从而提高作物的产量和质量。

近年来,农业信息化技术的推广,将计算机视觉技术广泛运用于害虫识别领域,并取得一定研究成果。杨红云等 [1] 提出了一种基于迁移学习和卷积神经网络相结合的害虫识别融合机制。类成敏等 [2] 提出了一种基于多尺度注意力残差网络的害虫图像识别模型。姚青等 [3] 建立了运用ResNet50的基于双线性注意力网络的农业害虫识别模型。肖小梅等 [4] 对传统的卷积神经网络Alexnet进行优化改进。Wu等 [5] 引入大规模害虫数据集IP102,包含了属于102个类别的75,000多幅图像,呈现出自然的长尾分布。Liu等 [6] 提出了一种新型深度多分支融合残差网络(DMF-ResNet),创建了深度多分支融合残差网络。Nanni等 [7] 应用显着性方法与卷积神经网络之间的融合,提出了一种自动分类器,并在小型数据集和大型数据集IP102上测试该方法,准确性达61.93%。Thenmozhi等 [8] 提出了一种有效的深度CNN模型,用于在三个公开可用的昆虫数据集上对昆虫种类进行分类,在DO数据集上实现分类准确率达96.0%。在害虫图像识别研究方面,国内外研究人员运用CNN网络架构取得了一定的研究成果。但农业害虫存在种类众多,不同虫态的害虫外观差异大,数据采集难度较大的现象。尤其目前常用的害虫识别架构在图像分析任务上泛化能力的提高是以增加参数和层数、数据集大小、训练和测试计算以及GPU内存为代价的,缺少同等性能的轻量型害虫识别机制。在能达到高准确率的同时,轻量化模型所需参数,是本文的研究方向。

2. 本文算法

2.1. WraNet网络模型

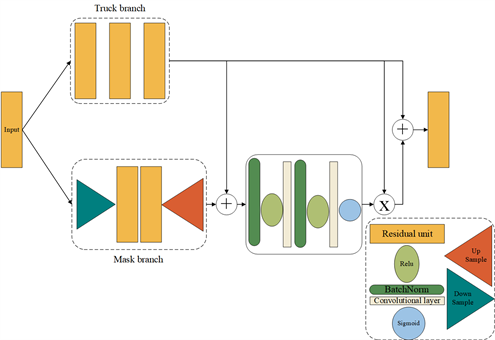

本文提出的新型神经网络WraNet由改进的2D-DWTM模块 [9] 和残差注意力模块等组成。WraNet网络框架如图1所示,输入图像首先通过卷积层创建特征映射,然后使用2D-DWTM进行处理,以达到参数减约的目的。此外,为了进行图像识别,还添加了一个残差注意力模块、一个全局平均池化层和一个线性层。其中,2D-DWTM和残差注意力模块是WraNet的核心模块,下文将对其进行详细介绍。

Figure 1. WraNet network architecture

图1. WraNet网络架构

2.2. 基于2D-DWT的参数减约模块

二维离散小波变换模块(2D Discrete Wavelet Transform Module, 2D-DWTM)是一种新型的神经网络模块,可像transformers和卷积神经网络一样进行推广。与传统卷积神经网络相比,2D-DWTM利用二维离散小波变换来处理图像像素中的空间信息,从而能够更有效地利用图像的尺度不变性和边缘稀疏性,并能够利用2D-DWT来提取特征的空间维度以降低所需的计算量,具体的结构图如图2所示。

Figure 2. Structure of 2D-DWTM module

图2. 2D-DWTM模块结构

具体而言,2D-DWTM采用小波分解对输入的特征图进行多尺度分解,并利用不同尺度的小波系数进行特征交换,以促进特征之间的信息交流。将对应的输入和输出张量表示为

和

;四个小波滤波器以及它们的下采样分别表示为

,

,

,

(

代表近似值,

代表细节);卷积、多层感知机、转置卷积(上卷积)和批归一化操作分别表示为c、m、t和b;它们对应的可训练参数集表示为

、

、

和

;通道维度上的串联操作表示为

,点对点加法表示为+,则2D-DWTM内部对应的操作可以用以下公式表示:

(1)

(2)

(3)

(4)

在公式(1)中,本文首先使用卷积层来提取可学习的、空间不变的特征,并将嵌入维度降低至四分之一。接着,本文通过2D-DWT进行空间多尺度特征融合和下采样(参见公式(2)),从而实现尺度不变的特征提取。在这一过程中,本文通过计算一个近似子带和三个细节子带来降低空间分辨率,将输出通道数增加到输入通道数的四倍。通过这种适用于图像且不会损失信息的2D-DWT下采样,可以有效地降低计算量。最后,本文使用可学习的MLP层进行通道融合,并使用转置卷积层恢复特征映射的空间分辨率(参见公式(3)和(4))。其中2D-DWTM中的MLP与主干网络中的MLP的设计相同,在代码中都是通过ff_chanel、mult两个超参数来设计MLP前馈过程中的输出通道数以及通道的扩展数。

因此,2D-DWTM模块可以利用更多的图像先验信息,降低计算和模型参数的大小。将该模块应用于害虫识别中,有助于进一步减小网络模型的尺寸,这对于在害虫识别的部署阶段提高识别设备的效率具有重要意义。

2.3. 改进的残差注意力模块

Figure 3. Structure of residual attention module

图3. 残差注意力模块结构图

由于害虫识别应用需要在自然环境中进行,为了能够使构建的网络能够在复杂的自然背景中准确识别害虫,在网络架构中添加了一个残差注意力模块。该模块由两个关键组件组成,即主干分支和掩膜分支 [10] 。其中,主干分枝负责图像特征的提取,而掩膜分枝用于学习对输出特征进行软加权的注意力屏蔽。具体而言,该模块的输入经过残差层处理后,被分成两条不同的路径。一条路径直接进入下一层,另一条路径则经过注意力机制进行加权处理后再与第一条路径相乘并相加,最后再进入下一层进行处理。通过这样的设计,剩余注意力模块可以更好地利用图像信息,提高网络的准确性。结合本次实验的具体要求,本文设计了如图3所示的残差注意力模块。

在上图的操作中,本文不妨将残差块变换、下采样(最大池化)、上采样(双线性插值)批归一化、Relu、卷积操作以及Sigmoid分别表示为

、d、u、b、r、c和s;对应的可训练参数分别表示为

、

、

、

、

、

和

;点对点加法表示为

,点对点乘法表示为

。那么本残差注意力模块内部的操作可以用如下公式表示:

(5)

(6)

(7)

(8)

(9)

(10)

在这个模块中,输入图片首先经过公式(5)中的单层残差模块进行处理。然后,它被分为主干分支和掩膜分支进行处理。主干网络的处理如公式(6)所示,进行了三次残差操作。对于掩膜分支,在公式(6)中,首先通过最大池化下采样将图片的尺寸缩小至一半,然后经过两次残差处理,再利用双线性插值进行上采样,恢复到原始尺寸大小。最后,在公式(7)~(8)中的操作中,通过与主干分支相加并进行一系列的归一化、卷积等操作,最终得到一个位于0到1之间的张量。在接下来的公式(9)~(10)中,将该张量与主干分支的张量相加和相乘,即通过加权融合,实现了增强重要特征的效果。

通过上述模块的堆叠,成功实现了WraNet在识别性能与卷积神经网络相当的情况下,其模型参数的需求大幅降低的优势,同时还实现了性能的提高。这意味着能够在减小网络模型尺寸的同时保持高准确率,这对于网络模型在资源有限的环境下的应用具有非常重要的意义。

3. 实验结果与分析

3.1. 数据集设置

为了探究本文提出的新型轻量网络和相应的集成算法在嵌入式设备上的实用性,本实验分别在64 × 64的IP102和D0数据集上测试了它们的性能,同时也与其他卷积神经网络进行了比较。此外,为了尝试获得本次提出的WraNet-m集成算法的最佳准确性,本文还在224 × 224的IP102和D0数据集上训练了ResNet50和FPNs [11] ,并进行了性能对比。其中,IP102是当前最大的害虫数据集之一,共包含75,222张图片,其各种类害虫样本数量呈长尾分布,存在内外方差大和数据不平衡的挑战。此外,训练数据样本中还包含受损农作物的照片以及一些呈集中状分布在复杂环境中的小害虫图片,具体如图4所示,这些都对模型的训练具有挑战性。

Figure 4. Image example from IP102 dataset

图4. IP102数据集图片示例

D0 [14] 数据集包含4508张图片,图片来自40种不同的害虫类别,图片均为处于自然状态下的害虫,图5展示了一些图片的例子。

3.2. 实验设置

实验使用了PyTorch框架进行网络模型的搭建,其中PyTorch的版本为1.8.1,Python的版本为3.8,同时也使用了CUDA版本为11.1的GPU进行加速。在一张显存大小为16 GB的RTX3060上面进行实验。针对IP102数据集,按照7:1:2的比例随机划分成训练数据集45,095张、验证集7508张、测试集22,619张图片。而D0数据集则划分为训练数据集3156张、验证集405张、测试集947张。详细的网络设置如表1所示。

Table 1. Parameter settings of the network

表1. 网络的参数设置

在WraNet结构的设计中,还存在final_dim和depth两个超参数,分别控制的是进入二维离散小波变换层的通道维度以及堆叠的2D-DWTM数量。本次实验中本文采用了ff_chanel = 124、final_dim = 124、depth = 5的参数组合,该组合在IP102和D0数据集中均表现良好。muti参数在D0数据集和IP102数据集上训练时均设置为3。本文使用分类交叉熵作为代价函数,并选择Adam作为优化器,其中beta参数分别为0.9和0.999。为了调整学习率,本文采用了指数衰减的策略。每个batch的大小在训练过程中最小为32,最大为128,并且本文最多进行了150次训练。

3.3. 评价指标

实验中主要采用了6种评估指标,分别为:参数大小(Param)、宏观平均精度(MPre)、宏观平均召回率(MRec)、宏观平均F1值(MF1)、准确率(Acc)和几何平均值(GM)来进行评估。

准确率的计算公式如下:

(11)

其中的

代表的是预测正确的数据个数,而

则为参与预测的数据总数。

预测精度(Pre)和宏观平均精度(MPre)的计算公式如下:

(12)

(13)

公式中的

代表的是分类总数,而

和

代表的就是每个种类当中的正确预测数和误报数。之后将所有类的预测进度做了一个取平均值的操作即得到了宏观平均精度。该指标主要展示了模型在分类是时不会将错误样本标记为正确样本的能力。

类似地,对于每个类的召回率以及宏观平均召回率的计算公式如下:

(14)

(15)

公式中的

即为每个类中的漏报数,其中宏观平均召回率的计算(MRec)和宏观平均精度(MPre)的计算相同。该指标主要显示了模型在分类时,召回所有的正确样本的能力。

其次利用上文得到的宏观平均召回率的计算(MRec)和宏观平均精度(MPre),既可以得到宏观平均F1值(MF1),该指标同时兼顾了MPre和MRec。具体计算公式如下:

(16)

最后,根据每个类的召回率作为其预测的敏感度(

),来进行几何平均值(GM)的计算,其显示了在数据量大的类别和数据量小的类别之间平衡分类的性能。

和

的具体计算公式如下:

(17)

(18)

3.4. 模型性能展示

3.4.1. 与轻量型网络比较

根据表2和表3的比较结果,在IP102和D0数据集上,WraNet相对于当前主流的一些轻量级神经网络表现更出色。此外,图6展示了WraNet在D0数据集上的网络参数与其他轻量级网络的对比情况。

Table 2. Performance of various lightweight networks on IP102 (64 × 64)

表2. IP102 (64 × 64)上各轻量网络的性能展示

Table 3. Performance of various lightweight networks on D0 (64 × 64)

表3. D0 (64 × 64)上各轻量网络的性能展示

Figure 6. Parameter comparison between WraNet and mainstream lightweight neural networks

图6. WraNet与主流轻量神经网络的参数对比

从上述数据可以看出,WraNet的模型参数在几个轻量级网络中处于中间位置,这表明WraNet的参数大小适中,适用于轻量级网络。与当前主流的轻量神经网络相比,WraNet的表现相当出色。因此,本文有信心在未来的实验中通过进一步调整网络结构和超参数设置,提升WraNet在害虫识别方面的性能,同时保持其参数优势。

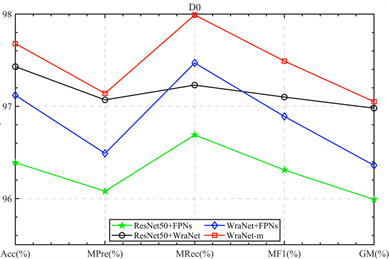

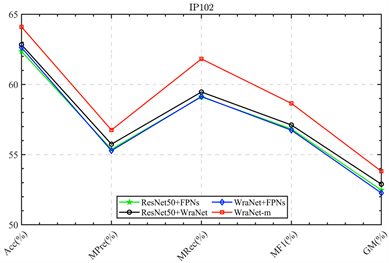

3.4.2. 与非轻量型网络比较

在IP102与D0上,WraNet与ResNet系列网络以及FPNs表现如表4、表5所示。

Table 4. Recognition performance of IP102 dataset (64 × 64)

表4. IP102数据集(64 × 64)的识别性能

Table 5. Recognition performance of D0 dataset (64 × 64)

表5. D0数据集(64 × 64)的识别性能

在本次实验中,通过表4、5的对比不同模型的参数大小以及其他性能指标可以看到,WraNet在模型参数大小方面具有显著的优势,仅需其他网络的1/5到1/20的模型参数大小。这样的优势在实际应用中能够显著降低模型的存储和计算资源消耗,进一步提高模型的运行效率和应用范围。图10进一步直观地展示了WraNet在模型参数大小方面的优越性。图7展示了IP102数据集上各个模型的参数大小比较情况(由于在两个数据集上使用的模型大小大致相同,这里仅展示IP102)。可以看出,WraNet在两个数据集上相对于其他网络具有更小的模型参数大小。这也证明了WraNet所具有的高效性和适用性,使其成为解决资源有限场景下的理想选择,例如移动设备和嵌入式设备等。

Figure 7. Parameter comparison between WraNet and non-lightweight neural networks

图7. WraNet与非轻量神经网络的参数对比

此外,根据表4和表5的结果显示,WraNe-m算法在D0和IP102 (64 × 64)两个数据集上表现最佳,分别达到97.68%和64.1%的准确率。这表明软投票集成有效地融合了每个模型的优点,从而取得了更好的性能。综合以上数据表现来看,WraNet仍然具备成为一款优秀的轻量害虫识别网络的潜力。因此,在未来的实验中,本文将继续探索更多超参数设置以及优化WraNet结构的方法。

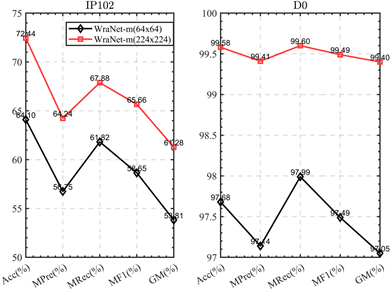

3.4.3. 不同图像尺寸对Wranet-m的影响

为了进一步评估WraNet-m算法的性能,本文在IP102和D0数据集上采用了224 × 224的图像尺寸重新对ResNet50和FPNs进行训练。本文记录了它们以及WraNet-m算法的结果,并将其详细列于表6。通过增大输入图像尺寸,本文观察到ResNet50、FPNs和WraNet-m算法的性能都有显著提升。在IP102数据集上,ResNet50和FPNs的准确率均提高了约10%,而WraNet-m的准确率提高了约8%。对于D0数据集,ResNet50、FPNs和WraNet-m的准确率均提高了约3%。这表明,当对识别速度要求不高或设备内存较大时,通过使用更大的图像尺寸可以提高识别性能,具体对比情况如图8所示。

Table 6. Performance demonstration under 224 × 224 input

表6. 224 × 224输入下性能展示

Figure 8. Performance of WraNet-m under different image sizes

图8. 不同图像尺寸下的WraNet-m表现

3.4.5. 与相关工作的比较

为了展示本研究提出的WraNet-m算法的可行性,本文在表7中将其与以往工作的结果进行了比较。本文的实验结果在具有挑战性的实际应用场景中得到了验证,证明了WraNet模型的实用性和实际效果。本研究为将来的害虫识别研究提供了新的思路和参考,即利用WraNet模型的集成以及模型集成的方法来提高模型的性能和准确性。在未来的研究中,本文将继续改进WraNet模型,并探索如何在其他实际场景中应用该模型。同时,本文还将研究更好的模型集成方法,以获得更好的性能。这些研究对于更好地理解图像识别问题,并为相关领域的应用提供更好的解决方案具有重要意义。

Table 7. Comparison between proposed algorithm and related works

表7. 本文算法与相关工作的比较

3.5. 消融实验

WraNet-m是由ResNet50、FPNs以及WraNet进行软投票集成而来。为了确定模型集成中哪个网络占据主导地位,本研究进行了一系列消融实验。这些实验通过在64 × 64的IP102和D0数据集上对WraNet-m中的每个网络模型进行两两集成的性能测试,来确定每个模型在本次集成中所发挥的作用。为了保证实验变量的统一性,本文对不同的网络模型都进行了相同的测试和比较。实验结果见表8和表9,并且本文还在图9和图10中对其进行了可视化呈现。

Table 8. Ablation experiment results on D0

表8. D0上的消融实验结果

Table 9. Ablation experiment results on IP102

表9. IP102上的消融实验结果

Figure 9. Ablation experiment results demonstration on D0

图9. D0上的消融实验结果展示

Figure 10. Ablation experiment results on IP102

图10. IP102上的消融实验结果

通过消融实验的结果,本文发现ResNet50和WraNet的集成在IP102和D0上都取得了最佳性能,即62.83%和97.43%。其次是WraNet和FPNs的集成,在IP102和D0上的准确率分别为62.63%、97.12%。最后是ResNet50和FPNs的集成,两个数据集上的准确率为62.36%以及96.39%。实验结果表明,WraNet在模型集成中发挥了最大的作用,其次是ResNet50和FPNs。尽管WraNet在性能指标上并没有优于ResNet50和FPNs,但是在消融结果中却占据了主导地位。这说明WraNet相比卷积神经网络能够更好地获取图像的额外先验知识,在处理一些对于卷积神经网络来说比较困难的图像时表现更好。因此,在软投票集成时,WraNet与ResNet50以及WraNet与FPNs的集成能够相互补充,从而超过了ResNet50和FPNs的集成性能。这为卷积神经网络在应用困难的方面提供了新的解决思路。

总体而言,实验结果表明,采用不同的卷积神经网络结构进行模型集成可以在图像分类任务中获得更好的性能。WraNet作为一种轻量级网络架构,在保证性能的同时,大大减小了模型参数的大小,具有一定的实际应用价值。

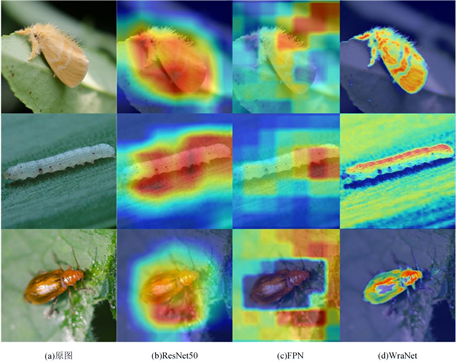

3.6. 网络特征激活图展示

此外,实验还运用了GRAD_CAM [16] 来对实验中的ResNet50、FPNs以及WraNet进行可视化展示,即将模型的最后一层卷积层通过梯度激活来生成激活图。图片为D0中的害虫样本,具体如图11所示。

Figure 11. Network feature activation heat map

图11. 网络特征激活热力图

从图11以看出,ResNet50和FPNs在图像识别中的关注点大多数是正确的,但是它们的关注范围比较广泛,不仅关注害虫本身,还关注害虫周围的环境。然而,与其它两种模型相比,WraNet的注意点更加精确,不会浪费太多的计算量在害虫周围的环境上。通过网络特征激活热力图,也说明了为什么WraNet所需的参数更少以及它相对于当前主流的CNNs和transformers的优势。此外,从图11(c)列中最底部的图片可以观察到,在某些情况下,卷积神经网络只关注害虫周围的环境,相比之下,图11(d)列中的WraNet能够更精确地关注害虫,这凸显了其与卷积神经网络在获取图像信息方面的差异。通过以上分析和结果展示可知,WraNet能够与当前主流的卷积神经网络媲美,在拥有更少参数的同时,在某些卷积神经网络处理效果差的情况下表现更好,这表明了WraNet在害虫识别领域具有巨大的潜力。

4. 总结与展望

本文提出了一种新型网络WraNet,采用二维离散小波变换对图像进行特征混合,以减少计算量和模型参数的大小。同时,还提出了WraNet-m算法以提升识别效果。这大幅降低了对网络部署模型的性能要求,为降低深度学习技术在农业方面的应用成本提供了思路。其次,WraNet-m算法通过集成WraNet、ResNet以及FPN网络模型的软投票,使得对于复杂环境中的害虫识别效果得到提升。这为农业害虫识别性能的提高提供了一种简单高效的办法。在未来的研究中,本文计划进一步探索WraNet在害虫识别领域的潜力。本文将投入更多资源,包括数据集的收集和标注、模型结构的优化以及超参数的调整等方面,以提高WraNet的性能并使其在更广泛的场景下适用。

基金项目

贵州大学大学生创新创业训练计划项目资助(2023年国家级大学生创新创业训练计划(项目编号202310657022))。

NOTES

*通讯作者。