1. 引言

在火车站、体育馆、地铁、机场等公共场所中,使用X射线安检机,可以有效避免枪支、管制刀具等违禁品对人员和公共财产的威胁与干扰 [1] 。但目前大多X射线安检机主要依靠人工视觉从拍摄的图像中识别违禁品,存在人为疏忽而导致漏检和错检的问题。

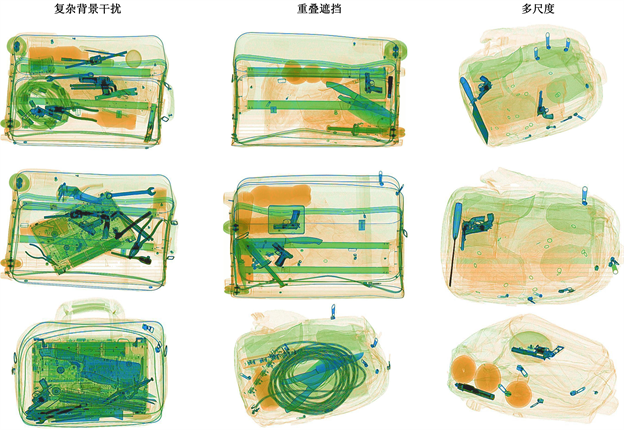

X射线安检图像是通过目标检测算法来判断是否存在违禁品,并在安检图像中标记出它的位置和类别 [2] 。然而,X射线安检图像有以下特点:1) 复杂背景:由于X射线成像与物体的密度和厚度有关,安检设备根据物质的性质呈现不同的颜色,当背景与违禁品厚度和密度相近时,会干扰违禁品的特征学习;2) 物体间重叠遮挡:物品在X射线投影下的形状会严重畸变,被检物品的随机放置会导致物体间的互相遮挡,增加违禁品识别的困难 [3] ;3) 违禁品具有多尺度变化:同类物品在图片中会呈现不同的尺度,不同位置的镜头监测到的目标也会呈现出尺度差异。违禁品检测安检图像如图1所示。

近年来,随着深度学习在计算机视觉领域发展迅速,目标检测算法在X射线安检图像违禁品识别中发挥了重要作用,有效提高了违禁品识别的准确率。Akcay [4] 等人首次将卷积神经网络应用于X射线安检图像,通过迁移学习对X光行李图像进行分类,再对特定物品——手枪进行检测,但识别类别单一;Gaus等 [5] 提出了一种双卷积神经网络架构,用于复杂X射线安检图像中的自动异常检测。GE等 [6] 人提出解耦检测头和无瞄框的YOLOX框架,虽定位多尺度小目标准确,但泛化性不足;Zhang Y [7] 等人在FSSD检测模型上添加扩张卷积并引入残差连接以避免过拟合现象,但检测精度仍有提升空间;Zhu X [8] 等人提出基于注意力机制的多尺度检测网络(AMOD-Net),通过融入通道注意力、构建深度特征融合结构,来解决X光违禁品图像中的重叠遮挡问题,但多尺度检测网络导致特征模糊,从而影响检测精度;

上述研究成果极大推动了深度学习在X光违禁品检测中的应用,提高了违禁品检测的准确性。但X射线安检图像仍存在违禁品的形状多尺度、重叠遮挡严重、复杂背景干扰等急需解决的关键问题,目前的检测精度和速度仍然无法满足实际应用的要求。

Figure 1. Sample of X-ray image contraband screening

图1. X射线图像违禁品安检样例

针对上述问题,本文基于YOLOv7 [9] 模型来进行改进,提出了MBRC-YOLOv7算法,进一步优化了检测的精度和速度。主要贡献如下:

1) 针对违禁品的多尺度性变换,通过在主干网络中将ELAN (Efficient Layer Aggregation Networks)结构替换成MBConv (Mobile Inverted Residual Bottleneck Block)结构,对输入的特征进行全局建模,提高模型对违禁品关键特征的提取能力;使用CARAFE (Content-Aware ReAssembly of FEatures)实现上采样,充分利用多级特征的语义与空间信息;

2) 针对违禁品检测中的复杂背景干扰,在Neck中将ELAN-H (Enhanced Local Attention Network with Hierarchical Structure)中融合双层路由注意力机制模块,抑制复杂背景干扰,使网络提取不同尺度的物品特征;并加入RFE (Recursive Feature Elimination)模块,以扩大图的感受野,并少上采样中有效信息的丢失,丰富图像的语义信息;

3) 针对物体间的重叠遮挡,在Head中加入一个由低层、高分辨率的特征图生成的小目标检测层,提高对小目标物体感知能力;引入Mish激活函数来提高网络识别重叠和遮挡对象的能力。

2. X光违禁品图像检测模型

2.1. 网络模型

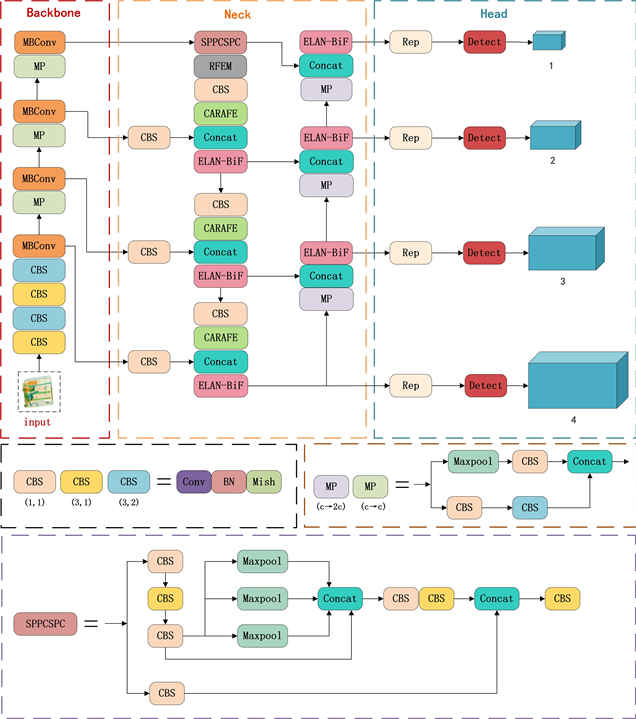

针对违禁品检测实时性需求,主要考虑检测速度更快的一阶段检测器,因此,本文以YOLOv7为基础进行改进,YOLOv7主要由Backbone、Neck和Head三部分构成。其中Backbone由多个卷积层、ELAN、MPConv (MaxPooling and Conv)等模块组成,用于图像特征的提取 [10] 。ELAN模块是一个高效的层聚合网络,可在不破坏原有梯度的情况下增强网络的学习能力。MPConv将MaxPool层添加到CBS层,形成上下分支来增强网络的特征提取能力。Neck通过PANet (Path Aggregation Network)和SPPSCPC (Spatial Pyramid Pooling Cross Stage Partial Concat)结构,通过对主干部分获得的三个有效特征层进行上采样和下采样来实现特征融合。在Head中,利用REPConv结构调整PAFPN输出特征的图像通道数,最后通过卷积完成预测和输出。改进后的模型为MBRC-YOLOv7,其网络结构如图2所示。

Figure 2. MBRC-YOLOv7 network structure diagram

图2. MBRC-YOLOv7网络结构图

2.2. 特征提取网络

为了提高对违禁品多尺度信息的提取能力,在主干网络中引入移动反向残差瓶颈卷积模块MBConv [11] 来代替ELAN模块。MBConv是一种轻量级的卷积,在保持较高精度的同时,还可以减少计算量和内存消耗。它采用多个跨层连接和SE注意力机制来增加模型的鲁棒性和泛化能力,能够有效提取多尺度空间特征信息,其结构如图3所示。

MBConv首先使用1 × 1卷积核对输入特征图进行通道数的扩张,通过扩大特征的通道数量,有助于提取物品的多尺度特征。然后使用深度可分离卷积进行特征提取和通道转换。在深度卷积阶段,使用3 × 3卷积核对输入的每个通道单独进行卷积,并为每个通道生成一个特征图。在逐点卷积阶段,使用1 × 1的卷积核对深度卷积的输出进行压缩,将通道数调整为所需的数量,并通过SE (Squeeze-and-Excitation Networks)注意力机制来增强网络对不同通道特征的感知能力。最后将重新加权的特征图与输入特征图进行结合,得到具有通道注意力的特征图。此外,MBConv还引入了残差连接,将输入特征图与深度可分离卷积的输出相加,促进了底层特征的直接传递,解决深层网络训练中的梯度消失问题,使得改进后的网络用更少的参数获取到更好的效果。

2.3. 双层路由注意力机制

Figure 4. Original ELAN-H structure (1, 1) CBS

图4. 原ELAN-H结构

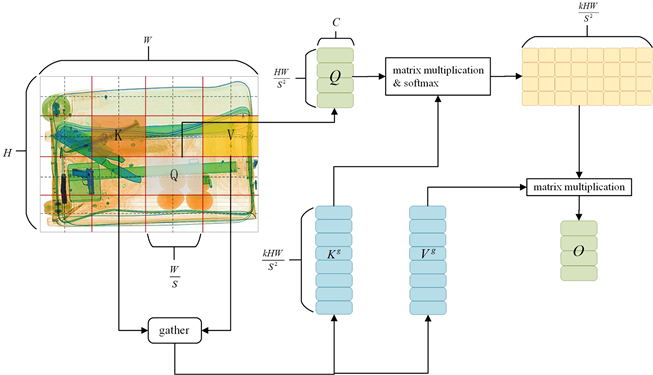

由于X光安检机检测的图像背景复杂且物品间高度重叠,许多检测模型抑制背景信息的能力较差。为了使模型更多地关注输入特征中的关键信息,本文设计出一种双层路由注意力机制 [12] (Bi-Level Routing Attention, BRA)与ELAN-H融合的模块——ELAN-BiF。BRA通过将局部和全局级别的注意力机制进行叠加和融合,从而实现多层级的特征交互,有助于提高网络对多尺度特征的感知和表征能力,并减少了计算和存储消耗。ELAN-H原始结构和改进后的ELAN-BiF结构如图4、图5所示。

Figure 6. Structure of the Bi-Level Routing Attention

图6. 双层路由注意力机制结构

如图6所示,输入特征图为

,首先被分割成

个子区域,每个区域包含

个特征向量。通过改变X的形状,得到维度为

的特征图。再对特征向量进行线性变换,得到三个矩阵

、K和V。其计算公式如(1)所示。

(1)

然后,通过构造有向图来定位给定部分的相关区域,从而获得区域与区域之间的注意力关系。首先,分别计算每个划分区域中的

和K的平均值,得到

和

,根据公式(2)来计算区域之间语义相关性的邻接矩阵

,再将

中不相关的标记过滤掉,保留k个具有高相关性的查询区域来获得路由索引矩阵

,如公式(3)所示。

(2)

(3)

最后,收集k个区域内所有K和V的张量,通过公式(4)进行张量计算得到

和

;再对

和

进行注意力处理,并添加局部上下文增强项

,得到输出张量O。其公式如式(5)所示:

(4)

(5)

上层路由和下层路由的结合,通过建模特征依赖关系和融合上下文信息来提高特征表示,从而能够提高违禁品分类准确率,更好地区分不同违禁品类别之间的特征差异。

2.4. CARAFE上采样

原始 YOLOv7网络中的多尺度特征融合采用最近邻插值来完成上采样,仅是在原始图像的像素之间插入新元素以增加像素数量,因此,得到的特征图具有较小的感知范围,被检测物体的特征信息容易丢失。为了解决上采样中语义相关性不足的问题,采用一种轻量级且高效的上采样算子CARAFE [13] 。该方法根据输入特征内容预测上采样内核的大小,同时引入少量的参数。利用预测结果指导上采样过程,可以在上采样操作时增大感受野,并充分利用特征的语义信息提取目标特征。

CARAFE上采样由两部分组成,如图7所示。一部分为内核预测模块,生成用于重组计算的核的权重;而内容感知重组模块是根据计算出的权重对特征进行重组。

首先通过1 × 1卷积层将H × W × C特征图的通道数压缩为Cm,以减少上采样操作的计算量。再利用内核预测模块中的卷积层,输入通道数为Cm的特征,并将输出通道数改为

(其中

表示预测上采样卷积核的尺寸)。然后沿通道维度进行扩展,使其形状变为

,再通过Softmax函数进行归一化,得到上采样卷积核的加权和为1。最后,在内容感知重组模块中,将H × W × C形状的特征图与预测的上采样卷积核进行点乘运算,获得

形状的上采样输出结果。

2.5. Scale-Aware RFE Model

针对随着网络模型的深入,原网络感受野变窄,导致小目标漏检率较高的问题,在特征融合区域引入Scale-Aware RFE [14] 模块,以提高网络模型对图像中小物体的感受野。RFE通过使用四个不同扩张卷积率的分支,每个分支都共享权重,既降低了过拟合的风险又可以充分利用每个样本特征。

如图8所示,RFE由多分支结构和聚集加权层两个部分构成,多分支结构使用三个不同的分支来扩张卷积率,每个分支都使用固定核大小的3 × 3卷积。然后使用残差网络连接,来解决训练过程中的梯度爆炸和消失问题。聚集加权层用于收集来自不同分支的信息并对每个分支的特征进行加权。这种加权操作可以平衡分支之间的表示,以增强整体特征的表达能力。

2.6. 激活函数Mish

Mish [15] 是一种非线性激活函数,它具有无上界特点,从而避免了由于封顶而导致训练结果的饱和。而有下界的属性,不仅可以加快训练过程,还有助于实现强正则化效果。Mish函数公式如(6)所示。

(6)

由图9 Mish函数图可以看出,输入值在接近零的区域几乎保持线性,有助于减少梯度消失和爆炸的问题;而在远离零的区域产生非线性响应,这种非线性增强的特性可以帮助卷积神经网络捕捉更多复杂的特征。Mish函数在接近零的区域表现更线性,并且在非零区域的曲线更平滑,这种平滑的激活函数允许更准确的数据进入神经网络,从而提高了检测的准确度。因此,Mish在处理违禁品检测中的重叠遮挡和正负样本不平衡方面具有优越的能力。

2.7. 小目标检测层

为增加复杂背景下小目标特征的捕获量,本文在Neck增加了一个由低层、高分辨率的特征图生成的小目标检测层P2,以及相对应尺度的检测头,如图2所示。P2包含着大量小目标以及微小目标的细节信息,在依次传递并融合特征的过程中,能给深层特征图提供更充足的小目标信息,进而提高复杂背景下小目标检测能力。

通过将四种不同尺度的特征层融合,可以获取丰富的小目标纹理和细节特征,再结合新增的小目标检测头,能够高效提升复杂背景下小目标的检测率和准确率。

3. 实验

3.1. 实验参数设置

本文的算法是在Windows10系统下进行,使用PyTorch 1.8.1搭建网络框架,在NVIDIA GeForce RTX 3090 GPU进行训练和验证。在训练阶段使用部分预训练的YOLOv7模型。模型在数据集上进行300次epoch的训练,使用SGD优化器进行训练,初始学习率为0.01。输入图像大小为512 × 512像素,批处理大小为16,权重衰减系数为5e−4,采用余弦退火算法(Cosine An-nealing)调整学习率,每个基线网络架构都使用相同的优化方案进行训练。

3.2. 数据集及预处理

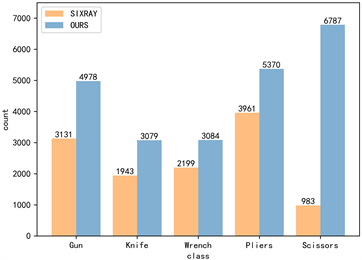

Figure 10. Comparison of SIXray_OOD and SIXray datasets

图10. SIXray_OOD与SIXray数据集对比图

实验中,考虑实际安检场景违禁品图像数据的不平衡问题,本文对SIXray数据集 [16] 进行预处理,构建了一个为SIXray_OOD的新数据集,如图10所示。其中包含了共计9893张图像,六种不同类别的违禁品,分别是枪、刀、扳手、钳子、剪刀、锤子。由于锤子样本数量明显低于其他五个类别,故本文保留其余5类重新进行人工标注,并对筛选后的数据集通过旋转和缩放、锐化、添加噪声等措施制作成实验所需的数据集SIXray_OOD,有助于降低模型过拟合的风险,并提高模型的泛化能力。其中枪的图片有4978张、刀3079张、扳手3084张、钳子5370张、剪刀6787张。本文设置训练集、验证集、测试集的比例为8:1:1。

3.3. 评价指标

实验采用准确率(Precision)、召回率(Recall)、平均准确率AP (Average Precision)、平均准确率均值mAP、类别识别平均准确率均值mAP@0.5(mean Average Precision,IoU阈值取大于0.5)、FPS (Frames per second)作为评价指标,计算方式为:

(7)

(8)

(9)

(10)

(11)

其中,TP为被正确识别为阳性的正样本数量,FP为被错误识别为阳性的负样本数量,FN为被错误识别为阴性的正样本数量,n为类别总数,i为当前类别的编号。P-R曲线由准确率和召回率组成,其曲线下方的面积为AP。mAP@0.5 (IoU阈值取0.5)是所有类别的识别平均准确率AP的平均值。FPS表示平均每秒检测到的图像数量。

3.4. 结果分析

3.4.1. 消融实验

为了验证的每个改进部分对网络性能都有较好效果,通过逐步添加改进的模块,在SIXray_OOD数据集上设计12组消融实验,分别验证各改进点的有效性,“√”表示某一组实验应用的改进点,各项评价指标见表1。

实验结果表明,第一组为原算法的实验结果,mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5值为90.3%,FPS为86,作为评价指标基线。第二组为在骨干网络加入MBConv后,模型的评价指标mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5增加了0.9%,证明了MBConv模块可以提升模型的违禁品检测能力。第三组只在Neck部分引入双层路由注意力BRA,mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5达到92.3,推理速度也有所提升,说明BRA利用瓶颈结构和通道注意力机制,可以更好的捕获目标特征;第四组将MBConv与BRA结合在一起进行训练,虽然推理速度有所降低,但相比较第二组实验平均准确率提高了1.2%;CARAFE上采样通过自适应权重和空间变换,可以更好的利用低分辨率特征图信息。第五组只引入CARAFE上采样,检测精度有小幅上升,推理速度提升到89;第六组将MBConv、BRA与CARAFE相融合,检测精度提升2.5%。RFE通过多分支结构和聚集加权层来扩张卷积,以增大感受野,来提升违禁品中小目标检测的准确率。第七组通过加入RFE增大特征图感受野,检测精度提升1.1%;Mish具有梯度平滑性与非线性的特性,有助于减轻训练过程中梯度消失问题。第九组把激活函数替换为Mish,在保证没有增加参数量和计算量的条件下,加快网络模型收敛,同时mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5值提升0.3%。第十二组是在头部加入大尺度特征层集合所有改进点后,mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5" target="_self">mAP@0.5值提升了4.9%。

Table 1. Ablation experiments with different modules on the SIXray_OOD dataset

表1. 不同模块在SIXray_OOD数据集上的消融实验

3.4.2. 对比实验

为了验证本文模型MBRC-YOLOv7的有效性,本文选取One-Stage检测算法中SSD [17] 、YOLOv5s [18] 、DETR [19] 、YOLOv7、GF-YOLOv7 [20] 以及Two-Stage中的Faster RCNN [21] 、Mask R-CNNR [22] 模型,总共7种目标检测模型在SIXray_OOD数据集上进行对比试验。如表2所示,所提出的算法的平均检测精度达到了95.2%的准确率,明显高于其他算法,枪支、刀、扳手、钳子、剪刀的检测精度也高于其他主流检测算法。与YOLOv7相比,枪支AP@50提高了4%,刀AP@50提高了10%,扳手AP@50提高了10%,钳子AP@50提高了10%,剪刀AP@50提高了10%。

综上可知,本文改进的MBRC-YOLOv7模型,能在保证平均检测精度最高的同时,推理速度也相对较快,证明了MBRC-YOLOv7算法相比其他算法具有高精度和快速检测的优势。

Table 2. Comparison of detection accuracy of different models on SIXray_OOD dataset

表2. 不同模型在SIXray_OOD数据集的检测准确率对比

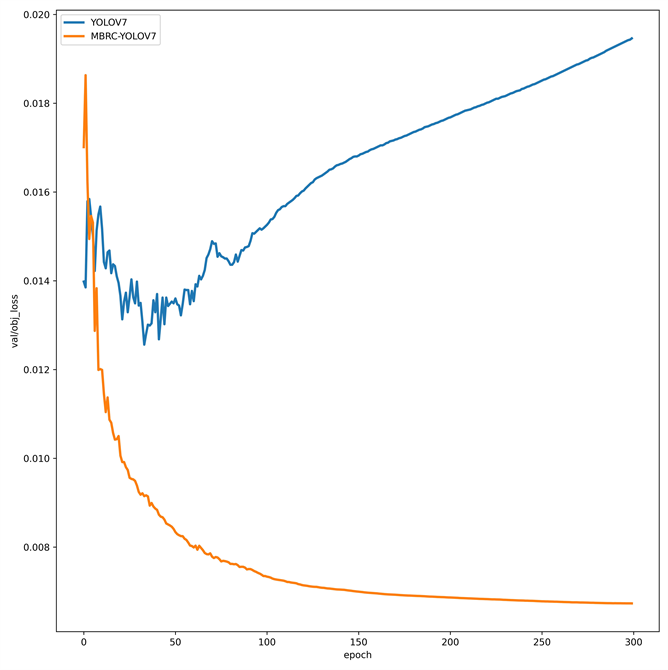

(a) mAP@0.5

(a) mAP@0.5 (b) precision

(b) precision

Figure 11. Comparison of MBRC-YOLOv7 training process

图11. MBRC-YOLOv7训练过程对比

图11显示了本研究中提出的网络模型与原模型对数据集SIXray_OOD的训练过程对比。图13(a)显示,在完成300轮的训练后,所提出模型平均识别准确率mAP_0.5达到了95.2%,相比原模型提高了4.9%;图13(b)显示,经过300轮的训练后,所提出模型识别精度达到了95.5%。

图12显示了本研究中提出的网络模型与原模型对数据集SIXray_OOD的训练过程损失函数对比。图12(a)显示,经过300轮的训练后,所提模型训练集分类损失函数均值稳定在0.0026,这表明模型在数据集SIXray_OOD中已经达到了稳定的最佳训练状态图;图12(b)显示,经过300轮的训练后,所提模型验证集损失函数逐渐减小,均值稳定在0.006,而原模型验证集损失函数由于正负样本分布不均衡随着训练次数的递增而增大。与原算法相比,本研究提出的模型具有明显的优势,可以更准确地识别检测违禁品。

(a) 训练集损失函数

(a) 训练集损失函数 (b) 验证集损失函数

(b) 验证集损失函数

Figure 12. MBRC-YOLOv7 training process loss function comparison

图12. MBRC-YOLOv7训练过程损失函数对比

3.4.3. 可视化分析

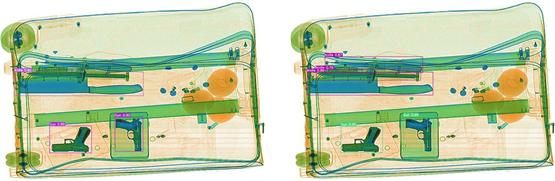

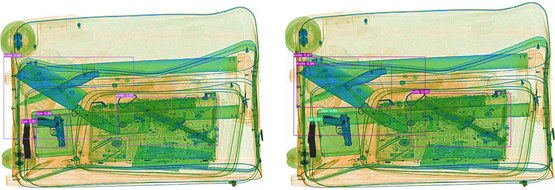

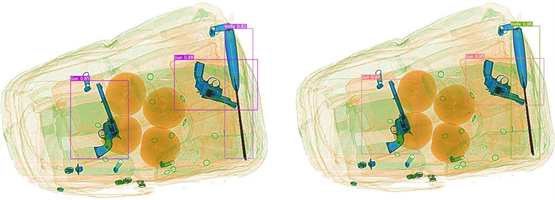

为了验证改进模型对违禁品的检测性能,选取在重叠遮挡、背景杂乱、多尺度和普通样本四种不同的场景测试了改进后的模型。图13为重叠遮挡样本检测结果,原网络中只检测出一把小刀,而改进后网络3把重叠的刀子均被检测出来,精度分别为75%和87%,说明优化后的模型可以有效减少重叠遮挡场景中漏检的情况。图14为背景杂乱场景下的识别结果,改进后网络检测到原网络中漏检的刀子,精度为96%,说明优化后的模型可以减少在背景杂乱场景下的漏检情况。如图15所示,对于多尺度样本,改进后的模型对不同方向放置的刀子检测精度提高了14%,说明改进后网络可以减少违禁品多尺度变化引起的漏检情况。如图16所示,对于普通样本,网络改进前后都检测出所有的违禁品,但改进后网络检测精度更高。综上所述,改进后的模型可以有效减少由重叠遮挡、背景杂乱、物体多尺度变换引起的违禁品漏检情况,同时也提升了类别检测精度。

(a) 原模型 (b) 改进后的网络模型

(a) 原模型 (b) 改进后的网络模型

Figure 13. Overlapping Masked Sample Detection Visualization Results

图13. 重叠遮挡样本检测可视化结果

(a) 原模型 (b) 改进后的网络模型

(a) 原模型 (b) 改进后的网络模型

Figure 14. Visualization results of background cluttered sample detection

图14. 背景杂乱样本检测可视化结果

(a) 原模型 (b) 改进后的网络模型

(a) 原模型 (b) 改进后的网络模型

Figure 15. Visualization results of multiscale change sample detection

图15. 多尺度变化样本检测可视化结果

(a) 原模型 (b) 改进后的网络模型

(a) 原模型 (b) 改进后的网络模型

Figure 16. Visualization of the results of testing common samples

图16. 普通样本检测可视化结果

4. 总结

针对X射线图像违禁品检测中存在的难点,本文基于YOLOv7提出MBRC-YOLOv7多尺度小目标检测算法。将主干网络中ELAN结构替换为MBConv来加强违禁品关键特征提取能力,在Neck中融合BRA注意力机制提取不同尺度的违禁品特征,减少复杂背景干扰;添加小目标检测层提高小目标检出率和准确率;引入了RFE模块,增加特征图的感受野,提高了违禁品多尺度检测和识别的准确性,最后采用了CARAFE上采样和Mish激活函数来提高网络对重叠和遮挡对象的识别能力,进一步提升算法在正负样本与难易样本失衡情况下的检测性能。实验结果表明,本文算法在SIXray_OOD数据集中对X射线违禁品的检测效果优于其他算法,有效提升了违禁品检测精度与速度。为实际应用提供了一定的参考价值,但在轻量化方面仍有进步空间,需继续研究探索。

基金项目

国家自然科学基金(U2141239)。