1. 引言

遥感作为对地观测的重要工具,已广泛应用于生态环境监测、天气预报等军事和民用领域。近年来,随着遥感技术的不断发展,遥感图像数量急剧增加,传统的人工解译已经成为一项艰巨的任务。目标检测是指识别感兴趣目标的对应类别并标记其位置,对于遥感图像的图像理解有着重要的作用。

近年来,许多基于卷积神经网络的目标检测模型取得了显著的效果 [1]。基于深度学习的目标检测算法大致可分为两阶段检测法 [2] 和一阶段检测法 [3] [4]。两阶段目标检测算法包括两个阶段:方案的生成阶段和方案的回归分类阶段。在第一阶段,基于骨干网络提取的特征地图,通过区域提案网络(RPN)为每幅图像生成一系列提案框。在第二阶段,根据方案对特征图进行裁剪,然后调整到相同的大小,并进一步利用裁剪后的特征图对对象类别进行预测,并对方案的位置进行微调,使预测更加准确。在一阶段的目标检测算法中,目标检测被看作是一个回归问题。利用多个比例和长宽比在图像的不同位置设置密集采样锚盒,然后利用卷积神经网络进行特征提取,直接对目标进行分类和预测。整个过程只需要一步,检测速度比两步法快。然而,一阶段目标检测算法有一个明显的缺陷。密集采样锚盒会使目标探测器的正负样本极不平衡,且负样本的数量将远远大于阳性样本的数量,导致后续的预测效果不佳。

但目标检测在航空图像中的进展却比较缓慢 [5]。这主要是因为遥感图像与自然图像之间存在着巨大的差异。遥感图像通常由卫星或者飞行器在高空俯视拍摄,包含较大的场景,但目标物体体积占比小且尺寸变化大、背景复杂。自然图像与遥感图像之间的差异导致了目标检测算法在遥感图像中表现不佳。

针对于遥感图像的特点,本文提出了一种适用于遥感图像的目标检测模型。本文的主要贡献分为两个部分:

1) 将注意力机制运用在特征提取的过程中,解决遥感图像目标体积小、背景复杂的问题。

2) 利用自注意力机制对特征提取网络各层级特征图进行融合,提高模型对于目标多尺度问题的表现。

本文结构如下:第二章介绍特征提取与目标多尺度问题的相关工作,第三章介绍提出的方法,第四章展示实验,第五章总结本文。

2. 相关工作

VGG [6] 网络是一种常用的目标特征提取网络。该网络使用了更小的卷积核(都使用了3 × 3的核),并加深了模型结构,从而获得了更好的特征提取效果。在一定程度上深化模型结构有助于提高网络性能,但是随着网络层数的增加,网络将变得难以训练,并且可能发生梯度退化,从而错过最佳收敛并导致更大的学习误差。针对梯度退化问题,后期开发的特征提取网络ResNet [7] 引入了跨层连接,可以解决增加层数带来的退化问题。与之前建立的许多其他网络相比,ResNet网络的特征提取效率大大提高;尽管如此,ResNet在复杂背景的遥感照片中目标检测的性能有限。目前,许多网络设计者已经开始引入注意力机制 [8] [9] 来解决这个问题。在特征提取结构中部署了注意力机制来调整特征的权重。这使得特征提取网络能够专注于目标物体区域而不是背景噪声,选择性地增强目标物体的特征信息,实现目标特征信息的高效提取并抑制背景噪声的干扰。

多尺度问题是目标检测任务中的一个重要问题。在经典的物体检测算法Fast R-CNN和Faster R-CNN 中,只有最后一层特征图用于预测。然而,这种方法对于小物体来说是一个巨大的挑战,会导致大量的小物体被遗漏。对于这个问题,一个比较原始的解决方案是图像金字塔。输入图像依次缩放,然后训练检测器。这种方法对多尺度问题有很好的效果,但代价是带来了巨大的计算开销。在SSD中,同时选取不同层级的特征图进行预测,汇总不同层级的预测结果。但是这种做法存在一定问题,深层特征图语义信息丰富,感受野较大,但空间信息相对缺乏,对小目标物体的预测会造成大量漏检。浅层特征图空间信息丰富,分辨率高,但语义信息不足会导致大量误检测。Lin提出了特征金字塔(FPN) [10],构建了一条自顶向下的道路,将多个层次特征图的语义信息和空间信息融合,得到多个融合的特征图。特征金字塔对于目标检测具有重要意义,大大提高了在多尺度问题上的表现。这表明浅层次的信息和深层次的信息是互补的,对于后续的目标检测效果来说非常重要。但FPN的特征融合方式存在些问题 [11],他更多的是关注相邻层级的特征信息,非相邻层级的特征信息在每次融合中都会被稀释一次。

3. 本文方法

本文在Faster RCNN的基础上进行改进。将注意力机制应用在特征提取的过程中,使得特征提取网络能够专注于目标物体区域而不是背景噪声,选择性地增强目标物体的特征信息。以此来解决遥感图像中,目标物体体积小、背景复杂和噪音干扰严重的问题。使用非局部信息统计的注意力机制 [12] 对特征提取网络的各层级信息进行融合,使得最终的集成特征是来自于每个层级的特征信息而不是只关注与相邻层级的特征信息,整体网络结构如图1所示。

3.1. 基于注意力机制改进的特征提取

本文在特征提取过程中应用注意力机制来解决复杂背景带来的问题,缓解特征提取过程中小物体携带的语义信息减少甚至消失的问题。卷积注意力模块(CBAM),是一种用于前馈卷积神经网络的简单而有效的注意力模块。CBAM模块整体结果如图2所示,首先会将特征图通过平均值池化操作和最大值池化操作在空间维度进行压缩成,得到一个一维矢量,进行训练,得到各通道的权重,然后与输入特征图做乘法操作来得到加权结果。接下来,会将通道注意力的结果作为输入,通过平均值池化操作和最大值池化操作在通道维度进行压缩,得到一个二维的空间注意力图,进行训练,得到空间上各位置的权重,然后与输入特征图做乘法操作来得到最终特征。

将

定义为输入的特征图,

定义为一维的通道注意力图,

定义为二维的空间注意力图,CBAM模块的处理逻辑如等式(1)、(2)所示。

(1)

(2)

其中,

表示乘法操作,

为通道注意力机制处理的结果,

为经过空间注意力机制处理得到的最终结果。通道注意力机制与空间注意力机制处理逻辑如等式(3)、(4)所示。

(3)

(4)

其中,

、

为多层感知器的参数,

为RELU激活函数,

为7 × 7大小的卷积核。

在这里,我们选择残差网络Resnet-101作为我们的主干,并将CBAM插入主干的Stages 3到5。首先,给定任意大小的遥感图像作为输入,在残差网络中,快捷连接可以解决由于层数较深而引起的退化问题。在残差网络的第3到第5阶段,将CBAM模块插入到每个残差模块中。通过以上操作,在提取图像特征的过程中调整特征权重。这使得特征提取网络能够专注于目标物体区域而不是背景噪声,从而选择性地增强目标物体的特征信息。

3.2. 基于特征融合改进的特征金字塔

特征金字塔将特征提取网络所提取的浅层级信息和深层级信息进行融合,并基于融合后的集成特征进行目标检测,大大提高了目标多尺度的问题。但是特征金字塔对于特征提取网络各层级的信息所采用的融合方式更多关注的是相邻层级的特征信息,非相邻层级的特征信息在每次融合中都会被稀释一次。致使最终的集成特征是不平衡的。因此本文将改进特征金字塔的融合方式,来得到一个质量更高的集成特征,以此来提高目标检测的准确性。

将

定义为第l层的特征图。为了整合多级特征并同时保留它们的语义层次,我们首先将多级特征

的大小调整为中间大小,即与

相同的大小,并使用插值和最大值分别池化。大小调整完以后,通过简单的平均获得平衡的语义特征,如等式所示。

(5)

在获得平衡的语义特征之后,使用非局部信息统计的注意力机制对其进行细化,使其更具有辨别力。非局部信息统计的注意力机制可以建立远程依赖,建立图像上两个有一定距离的像素之间的联系。通过计算任意两个位置之间的交互直接捕捉远程依赖,而不用局限于相邻点,其相当于构造了一个和特征图谱尺寸一样大的卷积核,如等式所示。

(6)

其中,i是要计算其响应的输出位置的索引,j是枚举所有可能位置的索引。x是输入特征,y是与x大小相同的输出信号。成对函数f计算i和所有j之间的关联。一元函数g计算位置j处的输入特征的表示。响应由系数

进行归一化。

在这里,我们采用的是高斯非局部信息统计,最终的运算逻辑如等式(7)、(8)、(9)、(10)所示。

(7)

(8)

(9)

(10)

其中,输入是x,输出是y,i和j分别代表输入的某个空间位置,

是一个需要学习的权重矩阵。

4. 实验与分析

4.1. 数据集

本次实验采用DIOR遥感数据集 [13]。DIOR是一个大型的遥感数据集,包含23,463张遥感图片,其中共有20种不同的类别。该数据集分为三部分:训练集、验证集和测试集。训练集包含5862张图片,验证集包含5863张图片,测试集包含11,738张图片。

4.2. 评估标准

为了评估目标检测模型的性能,本文采用全类平均精度(mAP)来作为评估指标,如果预测的目标与真实框(GT)的交并比(IoU)大于0.5,则认为预测结果为真正例。全类平均精度定义见公式。

(11)

(12)

(13)

其中,B为类别总数,N为判断正负例的阈值,取值范围为[0,1],P(k)为每一阈值下的精度值,而则表示阈值从k − 1变化到k时召回率的变化情况,A为预测的预测框,B为真实框。

4.3. 实验结果

本文研究是基于Faster RCNN with FPN所改进的适用于遥感图像的目标检测模型。为了测试该模型的有效性,我们将SSD、YOLOV3、Faster RCNN with FPN和RetinaNet等主流的目标检测模型与本文模型进行实验对比,具体实验结果如表1所示。观察表1可得,本文模型在DIOR数据集上的全类平均精度为67.1%,相比于原来的Faster RCNN with FPN的检测模型,其检测精度提高了2.0%,相比于RetinaNet也有1.0%的精度提升。我们的模型在网球场、体育场、地面田径场、烟囱、篮球场、棒球场、储存罐和飞机等8个类别上取得了最好的表现,并且其他类别也维持着较高的水平。这些类别具有遥感图像中目标的特点。网球场、体育场、地面田径场、烟囱、篮球场和棒球场等从高空拍摄,特征不明显并且背景复杂。储存罐和飞机等目标,体积小,并且聚集密集也是遥感图像中的一大特点。这充分表明本文提出的模型适用于遥感图像。

Table 1. Comparison of the detection accuracy of each target detection model in each category of the DIOR data set

表1. 各目标检测模型在DIOR数据集各类别的检测精度对比

为了进一步的验证模型的检测效果,我们将模型目标检测的结果进行一个可视化,展示了在DIOR数据集上的一些目标检测示例,具体结果如图3所示。

Figure 3. Example of target detection of this model in the DIOR dataset

图3. 本文模型在DIOR数据集的目标检测示例

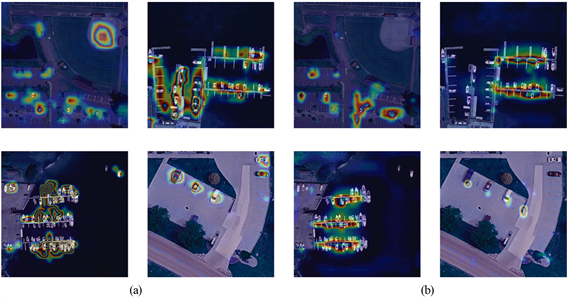

同时,我们使用加权梯度类激活映射(Grad-CAM)可视化了模型提取到的特征。图4中,对比观察到使用了CBAM模块的方法提取的特征与原始ResNet-101提取的特征,可以得出使用CBAM模块所提取到的特征更为显著、更为全面。这表明特征提取的过程中使用CBAM模块可以增强特征提取的能力。因此,实验结果表明了我们引入的CBAM模块的有效性。

Figure 4. Use Grad-CAM to visualize the features extracted from the model. (a) is the feature extracted by the model in this paper, (b) is the feature extracted by ResNet-101

图4. 使用Grad-CAM可视化模型所提取的特征。(a)为本文模型所提取的特征,(b)为ResNet-101所提取的特征

综上所述,在DIOR大型遥感数据集上的实验表明我们的模型提高了遥感图像的目标检测精度,并且在8个类别上取得了最好的表现。但是众多目标检测模型在在桥梁、火车站和港口取得效果不佳,我们的模型也不例外。原因可能是这些类别的目标形状都较为细长,长宽比比较极端,导致锚框拟合的效果不佳。后续可以对数据集中目标形状做抽样统计,基于统计结果来设计锚框比等超参数,或者可以尝试基于关键点的目标检测方法去自适应拟合目标的形状。

5. 结语

遥感图像与自然图像之间的差异,导致目标检测算法在遥感图像中效果不佳。本文提出一个适用于遥感图像的目标检测模型,将注意力机制运用在特征提取中,使得特征提取网络能够专注于目标物体区域而不是背景噪声,从而选择性地增强目标物体的特征信息。运用自注意力机制对特征金字塔各层级的特征图进行融合,更好地解决遥感图像中的目标多尺度问题。该模型相较于其他常见的目标检测模型,在DIOR数据集上精度有较大的提升。

基金项目

广东省基础与应用基础研究基金项目(2020A1515011409);广东省信息物理融合系统重点实验室(2020B1212060069);大南海区域广东高分大数据平台与应用示范(83-Y40G33-9001-18/20);“农业区块链”共性关键技术研发创新团队(2019KJ147)。