1. 引言

情感在日常生活中具有重要的意义,与人类的行为和认知有密切的联系,情感和人与人之间的交流有至关重要的影响。使用电子设备进行情感识别被称为情感计算,它是一种利用各种传感器和计算机环境进行情感识别的技术,这个概念起源于1995年Rosalind Picard关于情感计算的论文 [1]。情感识别作为情感计算最重要的研究课题之一,近年来因其在疾病检测中的应用而受到越来越多的关注 [2]。

在与情感识别相关的研究中,情感模型一般有两种形式。第一种模型是离散模型,如Ekman和Friesen [3] 提出的六种基本情绪。第二种方法将情绪定义为由效价(valence)、唤醒(arousal)、支配(dominance)组成的连续的3-D空间,见图1。在大多数研究中,这一空间被简化为二维,见图2,即valence和arousal维度 [4]。相关研究中将离散和连续的方法相互联系起来 [5],使离散的情绪状态被映射到valence-arousal环路模型上,可以将情绪从连续空间转换到离散空间。

根据调研,情感识别技术的方法主要分为两类,一种基于外部情绪反应,包括面部表情以及手势,另一种是基于内部的情绪反应,包括脑电图,心电图等。在这些方法中,基于视听的解读面部表情和声音的探测器实现了情绪的非接触识别,但由于人们很容易掩饰自己的情绪,从而无法准确地反映其内心的真实情感,因此不能总是返回可靠的结果。而相对的,生理信号的识别精度相对校高,与情绪相关的生理变化有两种:一种与外周神经系统(Peripheral Nervous System, PNS)有关,另一种与中枢神经系统(Central Nervous System, CNS)有关。通常,从心电图(ECG)、皮肤电导(SC)和脉搏等外周生理信号中提取特征,可以为识别情绪状态 [5] 提供详细而复杂的信息。与其他生理信号相比,从中枢神经系统捕获的脑电(EEG)信号,可以直接反映大脑的活动,与人的情绪状态有内在联系,神经科学研究表明,大脑皮层的一些主要区域与情绪密切相关,因此使用EEG信号进行情感识别是一项可行的研究 [6] [7]。

脑电图(EEG)是对大脑活动产生的电信号的测量,测量实际电极与参考电极之间的电压差。脑电图最近被用作一种强大的情绪预测模态,与其他大脑监测工具和技术相比,它可靠、便携、相对便宜。脑电具有广泛的应用领域。在临床应用中,EEG的研究通常与睡眠 [8] 和癫痫 [9] 相关。脑电图分析的其他应用包括意识和多动障碍 [10]、情感成分如注意力水平的测量 [11]、心理工作量 [12]、情绪 [13] 以及涉及将脑信号转化为直接指令的脑机接口 [14]。

在脑电模型中,通过建立包括传感器、机器和编码在内的脑机接口(BCI)来实现情感计算。在BCI中,通过向用户呈现诱发特定情感的刺激开始进行情感计算的初步操作。这些刺激可以是视频、图像或音乐等。在此过程中,可以通过脑电图设备记录脑电图数据。下一步通常是从记录的脑电图中提取特征,并训练分类器来预测情绪标签。最后,利用训练过程中没有用到的新脑电数据对训练模型进行测试,因此数据收集和标签是影响最终识别精度的重要步骤。

传统的脑电情绪识别方法通常先从脑电信号中提取手工特征,然后采用浅层模型对情绪特征进行分类。EEG情绪特征可以从时域、频域和时频域提取。通过自记录数据集上使用机器学习方法对脑电图特征提取方法进行全面调查 [15],许多研究者采用了机器学习的方法 [16]。Duan等人从多通道脑电图数据中提取优于表征情绪状态的微分熵(DE)特征 [17],并结合K近邻(KNN)和支持向量机(SVM)对DE特征进行分类 [18]。然而,浅层模型需要大量的专业知识来设计和选择情绪特征,限制了其在脑电情绪分类中的性能。

在大多数情况下,主体的情绪状态往往被视为独立的点,但是情感是一个随时间依赖属性而变化的过程 [19],卷积神经网络(CNN)或自编码器(AE)等深度学习方法无法掌握EEG的时间信息。一种深度学习算法叫做循环神经网络(RNN),在这种算法中,单元之间的连接形成一个循环,使其能够处理序列数据。然而,标准RNN存在梯度爆炸和梯度消失的问题,而长短时记忆(LSTM)网络 [20] 等特殊类型的RNN具有解决这一问题的能力,因此其更具有应用于生理信号的处理和分析的优势。

Salma,Alhagry [21] 等人使用双层LSTM网络对原始脑电信号进行特征学习,再利用密集层进行分类。Tang等人 [22] 提出了一种用于多模态信号情绪识别的双模态LSTM网络模型,在DEAP数据集上以EEG和外周生理信号为输入。Li等 [23] 首先利用小波和尺度图变换将DEAP数据集中的多通道信号封装成7~15帧网格状结构,然后,他们设计了一个结合CNN和LSTM的混合深度学习模型,旨在提取任务相关的特征,探索通道间的相关性,并从帧中整合上下文信息。

Chen [24] 等人采用DT-CWT技术分解原始脑电信号,从中提取时间、频率和非线性特征,并利用SRU网络对不同频段的4种不同特征建立模型,使用集成策略对模型进行集成,并取得了较好的识别性能。

对于脑电信号,不同部位的脑电通道对情感反应的敏感程度是不同的,情绪变化主要影响额叶和颞叶的脑电图信号,Salzman,Zhao [25] [26] 等人在工作中尝试了不同数量的通道,发现增加通道的数量对准确性的提高很小。Cimtay [27] 等人选取了特定的几个通道的脑电信号进行实验,结合IonResnetV2网络进行特征提取并分类。

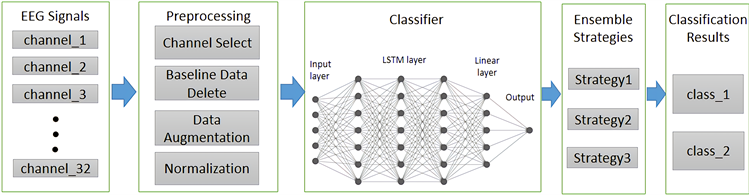

本文借鉴了上述研究方法,综合其优势,设计了一种基于LSTM网络和集成学习的多通道脑电情感识别的方法。针对存在与情绪不相关的脑电通道影响识别效率和结果的问题,选取了对情感变换较为敏感的脑电通道,即额叶和颞叶脑电通道,在对每个通道的数据进行预处理后,使用处理序列数据较为优异的LSTM网络来为不同通道的脑电数据建立模型进行学习预测。最后采用三种集成策略对识别模型进行集成,以获得更理想的分类准确率。

本文的结构如下:第2节介绍了本研究实验所使用研究方法,包括使用的数据集,脑电数据的预处理方法,LSTM模型结构以及集成学习策略。第3节介绍实验的流程,实验数据结果。第4节总结了论文,包括所使用方法的优劣势以及后续工作的讨论。

2. 方法

2.1. 数据集

DEAP [11] 是一个多模态数据集,包括32名参与者的脑电图和外周生理信号。32名参与者中有22人的正面视频也被记录了下来。研究人员在参与者观看一分钟长的音乐视频时记录数据。研究人员向每位参与者播放了40段视频。这些视频由参与者根据兴奋程度、效价、喜欢/不喜欢、支配性和熟悉度(在1到9之间变化)来打分,该实验采用32个电极采集脑电图数据,并且将数据降采样至128 Hz,同时去除眼动伪影,使用4.0~45.0 Hz的带通频率滤波器。后续介绍的余处理方法都将会基于此数据集的格式。DEAP数据集中被试者的文件包含两个数组,格式如表1所示。

Table 1. DEAP arrays of each participant

表1. 每个被试者DEAP数组表中的数据

2.2. 数据预处理

2.2.1. 脑电通道选择

研究表明,情绪变化主要影响额叶和颞叶的脑电图信号 [25] [26],增加通道的数量对准确性的提高很小。将与情绪变化不相关的通道包括在模型中并没有帮助,反而会对准确性产生不利影响,因此我们集中选择了额叶和颞叶的脑电通道,在DEAP数据集中,我们选择了F3,F7,T7,F4,F9,T8这6个脑电通道。

2.2.2. 基线数据消除

DEAP数据集已经进行了滤波和去除伪影的操作,我们不再对数据进行去噪处理。每个实验数据包含了63秒,前3秒为静息态数据,将静息态的脑电数据进行消除处理,避免非刺激状态的脑电数据对情感识别造成影响。

2.2.3. 数据增强

为了使网络适应噪声数据,提高网络的预测能力,我们用数据扩充代替数据复制。这也可以防止网络由于数据重复而过拟合。在图像处理中有两种基本的数据增强方法:几何变换和噪声相加。几何变换,包括平移、缩放、旋转/反射等,不适合直接放大我们的脑电图数据。与图像相比,脑电图信号是一个随时间变化的连续信号。即使进行特征提取,其特征仍然是一个时间序列。因此,如果对脑电数据进行旋转或平移,会破坏脑电的时域特征。为了避免这一问题,考虑采用噪声叠加的方法对脑电信号样本进行增强。但脑电信号具有很强的随机性和非平稳性。如果随机加入一些局部噪声,如泊松噪声、盐噪声或胡椒噪声,会局部地改变脑电图数据的特征。

基于这些考虑,重点对原始训练数据的每个特征样本加入高斯噪声,以获得新的训练样本。高斯随机变量z的概率密度函数P定义为

(1)

其中

为均值,

为标准差。为了保证样本的幅值不会随着噪声的加入而改变,每个通道的噪声副本是通过加入平均值

和方差

的高斯分布的随机样本来创建的,其中

和

分别取为0和0.01。数据增强的具体过程如下式所示,其中

为添加完噪声后的数据,

为原始数据,

为噪声副本,这种数据增强的方法在 [29] 中也有类似的应用。

(2)

2.2.4. 标准化

通过减去每个样本中每个窗口的均值对每个通道数据进行归一化处理。这对所有通道和噪声副本重复。这可以使网络免受可能的特殊情况的影响。使用的标准化方法为Max-min标准化方法,公式如下。

(3)

对于一组长度为n的脑电信号

来说,

为第i个原始信号数据,

为该组脑电数据的最大值,

为最小值,

为标准化后数据。

2.3. 长短时记忆网络(LSTM)

长短时记忆网络(LSTM)是一种特殊的递归神经网络(RNN),主要是为了克服RNN的长期依赖问题。因为RNN是通过时间反向传播(BPTT)训练的,因此无法支持长时间序列的学习,因而导致了梯度消失、爆炸的问题。为了解决这个问题,RNN细胞被门控细胞取代,比如LSTMs细胞。下图显示了LSTM单元的基本架构。

这些门是控制信息是否需要存在于内存中的关键。添加到LSTMs单元的内存使它能够记住前面的步骤。LSTM的关键是细胞状态(图3顶部的水平线(Ct))。LSTM可以使用三个门来删除或添加信息到细胞状态。

第一个门是遗忘门,这个阶段主要是对上一个节点传进来的输入进行选择性忘记,使用sigmoid层进行判定。

(4)

第二个门是输入门,它由sigmoid层和tanh层组成,前者决定哪些值将被更新,后者创建一个新更新值的向量。

(5)

(6)

然后通过等式(7)从等式(4),(5)和(6)更新LSTM单元状态。

(7)

最后,当前状态的输出将基于更新的细胞状态和sigmoid层计算,该层决定细胞状态的哪些部分将作为最终输出,如方程(8)和(9)所述

(8)

(9)

其中

是sigmoid激活函数,将数字映射到范围(0, 1),tanh是双曲正切激活函数,将数字映射到范围(−1, 1),

是权重矩阵,

是输入向量,

表示过去的隐藏状态,

是偏差向量。

2.4. 集成学习

集成学习可以防止单个基分类器的过拟合问题,目前已经开发了许多集成学习算法,如Boosting,Bagging和Stacking。

设

,

,表示第i个基模型的输出,

为集合结果。

2.4.1. 投票策略

投票策略的输出类标签是通过基本模型之间的多数投票决定的,即为:

(10)

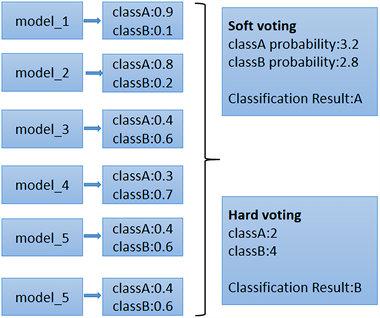

其中软投票方法为将每个集成对象各自分类概率相加,选取概率最高输出分类;硬投票思想是选择算法中输出最多的类。两种投票策略的区别如图4所示。

Figure 4. The difference between the two voting strategies

图4. 两种投票策略的区别

2.4.2. 权平均法

加权平均策略通过对不同的基本模型赋予不同的权重计算集成结果。即为:

(11)

其中

是

的权重,

,

。一般来说,识别精度越高的个体模型权重越高。

3. 实验

3.1. 实验流程

本文提出的基于多通道脑电集成方法在使用python语言在Pycharm进行仿真实验,使用的框架为pytorch1.10.2。所使用的数据集为上述方法中介绍的DEAP数据集。在DEAP数据集中,每个被试者的脑电数据均有4个情感维度的标签数值,因此我们分别对四个情感维度进行分类实验。对于4个情感维度,他们的取值在1~9,因此我们将值低于5的标签设置为low,高于或等于5的标签设置为high。

根据上述方法中脑电通道选择的标准,我们在DEAP数据集中选择了6个有关额叶和颞叶的脑电通道,分别为F3,F7,T7,F4,F9,T8。之后对各组数据进行基线数据消除,删除了各组信号前3秒的基线数据。然后进行数据增强策略,添加均值为0,标准差为0.01的高斯噪声。最后再对信号数据进行标准化,可以有效地提高学习分类的效率。之后再将各通道的脑电信号数据分别输入到LSTM网络中进行分类学习,最后再通过集成策略,输出最终的分类结果。LSTM网络的参数如表2所示:

上述的实验流程如图5所示:

Figure 5. General block diagram of experiment

图5. 实验总体框图

3.2. 实验结果

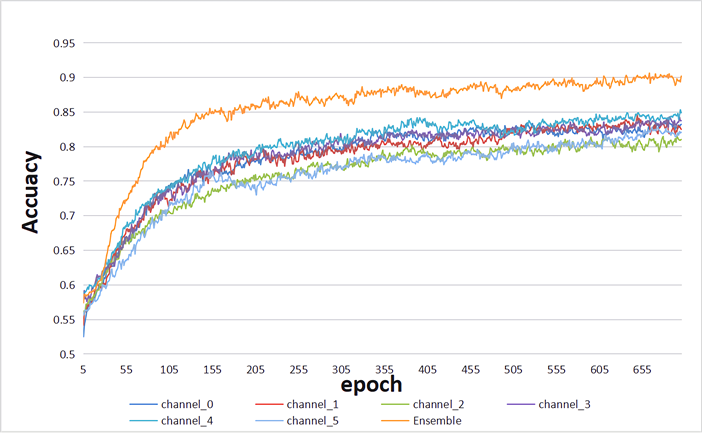

图6为6个通道的脑电数据在LSTM网络随着训练过程在测试集上准确率的变化,所属的情感维度是valence,其中包含了软投票集成策略的准确率。可以发现使用多通道集成策略可以有效地提升识别的准确率。

Figure 6. Performance comparisons between single-channel classification and ensemble of multi-channel EEG signals

图6. 单通道性能和多通道集成性能比较图

最终的实验结果如表3所示。同时为了体现我们使用的脑电通道集成方法的优异性,我们做了两组对比实验,第一组实验没有进行脑电通道的选择,我们在保持预处理一致的前提下,使用全部32个脑电通道的数据,在同个LSTM模型上进行分类学习,该方法对应下表的方法1。第二组实验中,我们对选取的6个脑电通道的信号数据在单个LSTM模型上进行分类识别,该方法对应下表的方法2。在方法2的基础上,将6个通道的脑电数据分别使用LSTM模型进行学习,再将6个模型进行不同策略的集成方法,最终输出识别结果。方法3,4,5分别为加权集成策略,软投票策略和硬投票策略。

从方法1和方法2可以看出,当我们针对性地选择额叶和颞叶的脑电通道进行实验时,在预处理方法和情感识别模型一致的前提下,最终识别结果的准确率没有太大的影响,甚至在Valence,Arousal,Liking三个维度上有了微小的提升,同时因为减少了大量通道的信号数据,模型训练的效率有了较大的提升。同时由表中方法3,4,5的结果,验证了集成策略对识别结果有十分明显的提升,可以看出其中软投票和加权平均的策略要优于硬投票的集成策略。

3.3. 与同类工作的比较

Table 4. Comparison of the existing emotion recognition studies

表4. 与现有情感识别研究的对比

4. 总结

在本研究中,我们提出了一种新的基于脑电信号情感识别的方法,用于情感维度中效价(valence)、唤醒度(arousal)、支配度(dominance)以及喜欢程度(liking)的情感识别。实验使用公开的DEAP情绪脑电图数据集的进行基准测试,并将以住的研究结果与本研究提出的方法进行比较。此方法中的重点在于针对多个脑电通道,选取对情感变化更加敏感的部分通道数据,并对选取的各个通道的脑电数据分别进行建模,最后使用集成策略提高模型的识别准确率。

表4中的情感识别研究均基于脑电信号,通过对比发现,使用深度学习的方法普遍优于使用特征提取结合机器学习分类的方法。在深度学习中,多使用LSTM和SRU等优化的循环神经网络,这种网络对序列数据有着较好识别效率的同时也可以避免传统循环神经网络的梯度爆炸和梯度消失的问题。同时在深度学习方法中结合集成学习的策略也可以有效地提升最终结果的准确率。通过表中准确率的数据对比,本文的研究方法在arousal和valence两个情感维度上相较于其它方法均有一定的优势,识别的准确率达到87.6%和90.52%。

当前工作的局限性及相应的未来研究方向总结如下:

· 对于LSTM网络参数,大多采用经验或试错法选择,需要一种更为系统的方法来选择适当的参数,从而进一步提升模型识别的准确率。

· 本研究在dominance和liking两个情感维度识别的准确率较差,仅有68.17%和80.73%。因此需要结合有关脑电信号的特征选择和计算的方法,来完善此深度学习的模型。

· 本文构建的多通道集成学习的模型仅在DEAP数据集上进行训练,并且在预处理环节使用添加高斯噪声的数据增强方式,这种模型在其它情感数据集上的泛化性能可能达不到预期的准确率。深度学习相较于传统的机器学习方法,更加依赖大量的训练数据,我们可以考虑使用多个情感分析的数据集来扩充训练数据而不是使用数据增强的方式,这样更有助于提升模型的泛化能力。