1. 引言

随着全球工业机器人智能化技术的不断发展,在视觉引导下,机器人为执行主体的多机协同装备受到国内外专家学者的广泛关注,已成为衡量一个国家科技发展和制造水平的重要标志 [1] [2]。国外大型机器人公司如日本FANUC公司研发了基于FANUC iR Vision视觉系统的智能化机床上下料,实现了一台机器人为多台机床进行自动化的上料和下料 [3];ABB公司研发了Flex Picke视觉系统,嵌入到四轴Delta机器人系统中完成工作台上零件的自动装卸 [4];国内己有较多基于视觉引导机器人上下料的研究,周书华等人 [5] 提出了一种基于视觉引导的工业机器人动态分拣系统;陈彦峰等人 [6] 对机器视觉引导下的车轮毂上下料工作站进行了研究;程子华等人提出了基于机器视觉的残缺饼干分拣系统 [7]。

目前基于视觉引导的自动上下料系统的抓取目标一般都为结构化、单一化物体,因而应用范畴有限。针对电力工程施工中,复杂多目标抓取场景下,电缆保护管的自动化仓储作业,本文研制了基于视觉引导定位的桁架机器人自动上,下料系统。该系统使用普通工业相机,构建视觉系统,实现机器人的现场采样。同时,基于深度可分离卷积神经网络算法设计了一套针对二维图像的高精度特征匹配算法实现物料的识别、抓取和指定位置放置。最后,通过实验证明,与传统人工搬运物料相比,该系统能够提高上料自动化程度和工作效率。

2. 自动上下料系统的总体方案设计

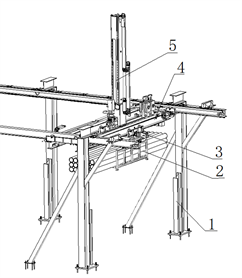

该系统主要由桁架机器人本体、视觉导引系统、机器人运动控制系统三部分组成。工业相机配合光源组成视觉系统,用于采集电缆保护管及巧固框的图像。经过视觉传感器将信息传递给上位机,由上位机上编写的图像处理系统进行图像处理、分类识别、获得物体位置信息,经由机器人运动控制系统处理后传递给工业机器人,由工业机器人实现物流的抓取,放置。自动上下料系统如图1所示。

2.1. 桁架机器人本体结构

自动上,下料系统的机械本体主要由五部分组成:立柱及横梁、大车、小车、提升机构和手抓机构,实现电缆保护管的自动上,下料,总体结构如图2所示。

Figure 1. Automatic loading and unloading system of truss robot

图1. 桁架机器人自动上,下料系统

(a)

(a)  (b)

(b)

Figure 2. Schematic diagram of the truss robot body. (a) Robot body, 1-Column and beam; 2-Grip mechanism; 3-Trolley; 4-Big car; 5-Lifting mechanism. (b) Grasp mechanism, 1-Drive structure; 2-C rotation of axes; 3-Hand grasp ontology; 4-Finger; 5-Qiao fixed frame; 6-Protection pipe

图2. 桁架机器人本体结构示意图。(a) 机器人本体,1-立柱及横梁;2-手抓机构;3-小车;4-大车;5-提升机构。(b) 手抓机构,1-驱动结构;2-C轴旋转;3-手抓本体;4-手指;5-巧固框;6-保护管

手抓机构采用电磁吸盘主抓、气缸机械手指辅助的形式,保证抓取的准确性、稳定性。其中电磁吸盘采用导向柱与直线轴承相配合,可有效避免抓取及放置保护管时的硬冲击,同时方便保护管旋转落入导向槽。每台桁架安装两套抓手,一套用于取放满载,一套用于取放空轮。

2.2. 自动上,下料系统的基本控制架构

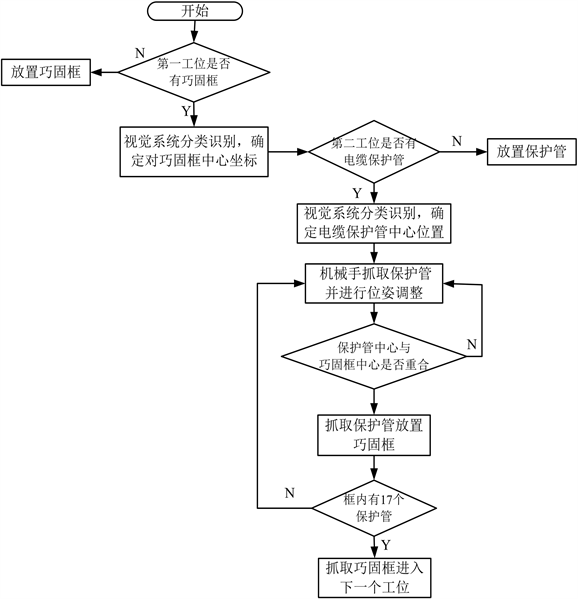

自动上,下料系统全部采用自研的驱控一体的控制系统以及同源上位调度管理,实现控制执行自动化、设备数据信息化、流程管理智能化。桁架机器人本体的电机均为伺服电机。控制系统采用千兆网为控制总线,采用嵌入式控制器,性能和运算能力更优,控制器和驱动单元采用闭环控制,可以实现实时控制,实时采集,实时位置规划和调整,电力系统采用共母线,效率更高,布线更方便快捷。本系统中动力系统采用永磁同步电机和绝对值多圈编码器23bit,使用伺服驱动器,采用矢量闭环,稳定性和可靠性,定位精度,响应更优。自动上下料系统的控制策略如图3所示。

Figure 3. Flow chart of the control strategy

图3. 控制策略流程图

3. 机器人的手眼定位标定

本系统选择康耐视VPRO型号工业相机,对电缆保护管及巧固框进行图像采集。机器人需要在世界坐标系里执行定位和抓取动作。由于桁架机器人的工作范围大,机器人的执行机构具有较高的重复定位精度,视觉系统采用eye-in-hand定位方式 [8]。

以末端机械手的初始点作为原点,三个正交的运动方向为坐标轴方向建立机器人基坐标系

。以末端机械手当前位置的工具中心点的三维坐标

为原点,与基坐标系相同的坐标轴方向建立工具坐标系

。工业相机采集物体在世界坐标系

中的三维坐标信息并转换到相机坐标系

下。这四个坐标系及其相互转换关系构成桁架机器人手眼视觉系统的数学模型,如图4所示。

在标定系统里,定义世界坐标系与保护管、巧固框标定板位置重合,桁架机器人基坐标系与标定板坐标系之间的相对位置固定不变,相机坐标系与机械手末端坐标系及机器人转换不变。则机器人基坐标系与相机坐标系之间的转换关系:

(1)

其中:

表示机器人基坐标系与相机坐标系之间转换关系矩阵;

表示机器人基坐标系与末端机械手坐标系之间转换关系矩阵;

表示机末端机械手坐标系与相机坐标系之间转换关系矩阵;

表示相机坐标系与世界坐标系之间转换关系矩阵;

待测物体在末端机械手坐标系和机器人基坐标系的位置坐标转换关系为:

(2)

其中:

为待测物体在相机坐标系下的齐次坐标;

为待测物体在末端机械手坐标系下的齐次坐标;

为待测物体在机器人基坐标系下的齐次坐标;

由于

是一个固定值,通过式(2)计算出待测物体在基坐标系下的位置坐标

,实现机器人的定位引导。

Figure 4. Schematic diagram of the eye-in-hand positioning of the truss robot

图4. 桁架机器人手眼定位示意图

4. 基于深度卷积神经网络的图像识别与分类

卷积神经网络是在人工神经网络的基础上发展而来的一种前馈神经网络。网络采用权重共享模型减少模型中自由参数的数量,网络可以并行学习,避免了传统算法对原始数据复杂的前期预处理过程。网络由卷积层和池化层交替叠加构成,卷积层进行特征提取,池化层对采样数据进行降维,在面对复杂二维图像数据如倾斜、平移和缩放时具有很好的稳定性 [9]。

本文根据电缆保护管、巧固框的特点,构建一种深度可分离卷积和卷积相结合的算法对图像进行识别与分类。首先原始图像通过预处理提取模型所需的区域作为采集样本,将提取的区域划分为训练样本和测试样本。通过训练样本训练模型;同时将测试样本输入到训练好的识别模型中,提取测试物体的特性向量,进行分类识别,模型的输出是一个固定维度的归一化向量,算法流程如图5所示。

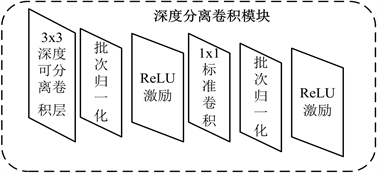

4.1. 识别网络模型设计

深度可分离卷积与标准卷积相比较,通过逐层卷积和逐点卷积将卷积核的巧妙分解减少网络参数。深度卷积为一组二维卷积核,每次仅处理一个通道,在使用逐个通道卷积处理之后,1 × 1的点卷积来处理前一个输出的特征图,将最终输出通道数变为一个指定的数量。标准卷积运算计算量为 [10]

(3)

深度可分离卷积运算计算量为

(4)

式中:

为卷积核的大小;M为输入的通道个数;N为卷积核个数;

为输入的大小。

深度可分离卷积计算量与标准卷积计算量的比值为:

(5)

式中,M通常大于1;

输入尺寸包括3 × 3、5 × 5、7 × 7,因此式(5)的值小于1。

该模型包括1层3 × 3的普通卷积,5个深度可分离卷积模块,1层全局平均池化层一层全连接层和softmax分类器,进行分类识别。每一个深度可分离卷积模块如图6所示。识别模型的参数如表1所示。

Figure 6. Depth-separable convolutional module

图6. 深度可分离卷积模块

4.2. 评价指标

考虑电缆保护管和巧固框识别所面临的问题,设计这样一种损失函数,它可以在扩大类间的距离的同时缩小类内距离损失函数的公式为

式中:

表示锚目标样本;

表示负样本,与锚样本不同类;

表示正样本,与目标样本一类。

损失函数的目标是使得相同标签的特征在空间位置上尽量靠近,同时不同标签的特征在空间位置上尽量远离,同时为了不让样本的特征聚合到一个非常小的空间中要求对于同一类的两个正例和一个负例,负例应该比正例的距离至少远一个预期的界限值。通过损失函数的学习,使得同类的正样本和目标样本的距离越来越近而不同类的负样本和目标样本的距离越来越远。

为了使训练的网络更好的适应轴向旋转的图像,缓解极端样本对于模型训练的影响。本文通过加权的方式,放松损失函数的类内约束力。改进的损失函数为 [11]:

和l为两个超参数用来控制不同样本对间的相对距离。l是预定的同类样本之间的欧式距离,

为不同类样本间的欧式距离。表2列出了不同

和l组合实验所得的结果。从表中可见,不同的

和l组对结果产生一定的影响。当

是0.6和l为0.3时,网络取得较好的效果。本文采用平均精度均值(mAP)来评估本文方法的准确性。

Table 2. Performance comparison of the different combinations of λ and l

表2. 不同

,l组合的性能比较

4.3. 模型训练与测试

一般而言,想要训练出一个性能良好的神经网络,需要大量的样本,在电缆保护管(两种规格)和不同巧固框种类识别分类中,由于样本数据较少,本文采取平移、旋转和镜像方式进行数据增强。同时将图像输入神经网络时,还需要对图像尺寸进行调整。每一类电缆保护管和巧固框在数据增强前的图像数据个数为10,采用5折交叉验证法,将1280幅图像作为训练样本,320幅图像作为测试样本。采集后的图像滤波、形态学处理、图像灰度化等预处理,得到保护管和巧固框的样本图像。初始学习率0.01、每一轮学习率下降0.98、权值衰减0.0005、动量0.9,最大迭代次数为10,000。为减小电缆保护管和巧固框的识别分类模型的内存需求,进一步提高模型的计算速度,本文设计了三种输入图片大小不同的模型(模型1:112;模型2:224;模型3:512)对每一种模型分别进行了训练和测试。3个模型训练过程中的损失函数数值结果如图7所示。从图中分析可知,模型2的初始损失值较小,收敛速度最快,经过100次训练最先趋于平稳状态,并且其稳定后的损失值相对最小,说明该模型性能最优。

Figure 7. A comparison of the loss curves for the different models

图7. 不同模型的损失曲线对比

为了检验本文方法的性能,选择了SVM模型与AlexNet模型两个经典模型算法与本文方法进行对比,实验结果如表3所示。

Table 3. Comparison of the algorithm accuracy rate

表3. 算法正确率对比

4.4. 实验结果及分析

为验证本文采用的分类识别算法的有效性,在桁架机器人自动上下料系统平台上做了相关实验,如图8所示。该系统已在国网江苏省电力有限公司泰州供电分公司下属的某电缆保护管仓储获得成功应用,并产生较好的社会效益和经济效益。

首先建立相机手眼标定系统,用阈值分割算法对保护管或巧固框图像进行分割,将分割后的图像送进训练好的深度可分离卷积神经网络型进行识别,识别待抓取物体的类别、位姿信息和中心点,获得待抓取物体的三维坐标信息,利用TCP/IP通信,将这些数据发送给桁架机器人,机器人根据图像识别的不同姿态,采取相应的抓取策略,做抓取实验。实验样本为不同种类的电缆保护管,巧固框共计80个,获得的实验数据如表4所示:

Table 4. Repeat mapping data acquisition results

表4. 重复定位数据采集结果

5. 结论

本文基于机器视觉技术,研制了由桁架机器人本体,视觉系统和控制系统设计三部分构成的桁架机器人自动上下料系统。解决了复杂施工中现场,多目标电缆保护管的自动仓储作业问题;该系统通过相机的手眼定位系统的标定,完成了相机相关参数的求取;建立深度可分离卷积神经网络识别模型,对图像用阈值分割算法从图像中分割出区域;对图像数据集做数据增强,搭建深度可分离卷积神经网络,确立网络的参数。实验验证结果充分证实了上下料系统的有效性和准确性。下一步,将在本文已有的研究成果基础上,继续改进识别模型相应算法,使整个系统能够有更为广泛的适用性。

基金项目

本工作得到国网江苏省电力有限公司双创中心孵化项目(名称:线缆保护管垂直存储系统研发项目,JF2021005)资助。