1. 引言

飞行模拟器是一种可以在地面模仿飞机的飞行状态、条件和环境的特殊装置,其可以通过相应的技术手段逼真的再现飞机的飞行特征。飞行模拟器的关键主要是依赖于视景系统对外部环境的模拟,飞行员有70%以上的信息来自于视觉,而外部环境的模拟主要是以视景图像的方式进行呈现,这就造成了飞行模拟器对图像的质量提出了更高的要求,更真实的、分辨率高的、质量更好的图像对飞行训练有着更有效的作用 [1] 。通过对模拟器的改进,如:增加光学设备和投影设备等组件,虽然能增强图像的分辨率,改善图像的质量,但这并不是一个最优的解决方案,因为合理的成本和模拟器的大小也是需要考虑的 [2] 。为解决这个问题,本文使用一种叫做超分辨率重建的方法,用于从低分辨率图像中恢复出高分辨率图像,恢复后的图像拥有更高的图像质量和更好的视觉效果。使用超分辨率技术克服原始分辨率的限制,是一个极具挑战性的过程 [3] 。

图像超分辨率重建方法除传统方法 [4] 外,在深度学习领域主要分为:PSNR导向和感知驱动导向 [5] 。PSNR导向主要是指通过对CNN网络进行优化,如:SRCNN [6] 、EDSR [7] 、RDN [8] 、MSFRN [9] 和RFN [10] 等。这些方法虽然在PSNR上取得了卓越的性能,但图像的视觉效果较差,易出现伪影,时间开销也较大。感知驱动是指以生成质量较好的图像为目标,如:SRGAN [11] 、LPIPS [12] 、ESRGAN [13] 、SPSR [5] 、和F_ESRGAN [14] 等,然而这些网络最终生成的图像虽有着很好的视觉效果,但在PSNR上的值并不高。为此,本文结合PSNR导向所体现出的特点以及视景图像在视觉效果上的高要求,提出一个基于GAN的视景图像超分辨率重建网络,其主要贡献点包括:

1) 提出了一种基于GAN的视景图像超分辨率重建模型,通过全局和局部的特征融合,并结合对抗思想中的相对鉴别理论,该模型不仅能充分利用图像的特征信息,提高图像的最终重建能力,更能结合人类的感光视觉的特性,生成效果较好的图像。

2) 设计了一种深层特征提取模块,在残差块内引入注意力机制,并通过使用低维度的方式,引入较少的计算量,从而提升整体性能。

3) 设计了一种层次特征融合模块,在1 × 1卷积后,对特征进行分割,接着使用一个高维度的注意力机制进行特征的提取,使得网络能恢复出更清晰的高频细节。

2. 基于GAN的网络模型

2.1. 网络结构

本文结合了对抗网络的思想,提出了一种基于GAN的视景图像超分辨率重建方法GAN-RDCN,其网络整体结构如图1所示,整个网络由两个部分构成:生成器Generator和鉴别器Discriminator,其中,生成器由3个部分构成:浅层特征提取部分、深层特征提取部分和图像重建部分。浅层特征提取部分由一个3 × 3的卷积组成,实现对输入图像的浅层特征提取。深层特征提取部分是由多个深层特征提取模块RDCA和层次特征融合模块HSCA组成,实现对输入图像特征的充分提取和复用。图像重建部分主要由亚像素卷积层实现图像的放大。

为了使最终得到的图像能更接近真实图像,拥有更好的视觉效果,本文采用了GAN网络中鉴别器的真伪鉴别方法,将生成器生成的图片与原始地面图像送入鉴别器进行真伪方面的鉴别,通过一种判断其是真是假的方式来得到本文最终所需要的超分辨率图像 [13] 。

2.2. 特征提取模块

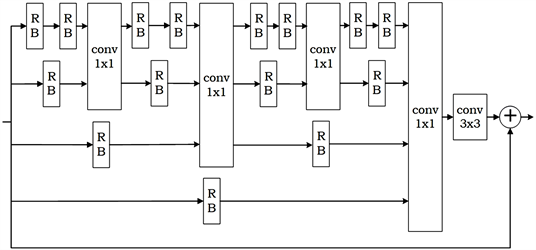

网络结构中的深层特征提取模块是整个网络中最重要的特征提取部分,如何有效的提取原始输入图像的特征,直接关系到最终的图像重建效果。为此,为了能更有效的提取输入图像的特征并对图像信息进行有效的复用,本文借鉴了Gu等人所提出的RFCB模块 [10] ,RFCB是一个残差分形卷积模块,是一个非常优秀的特征提取模块,但其内部并没有对特征信息进行充分的复用。为此,本文对其子模块RU进行改进,提出了一个增强型的RDCA模块,相比于原有的RFCB模块,RDCA模块考虑了通道间不同特征信息的比重,做到了对信息的复用,并在不增加大量参数量的情况下,对网络的整体性能进行了相应的提升。

特征提取模块结构如图2所示,模块中的RB表示的是本文在原有的RFCB模块中的RU基础上进行改进后提出的一个新的子模块RB。单个RB模块的结构如图3所示。

RB模块是一个由残差学习和通道注意力机制相结合所构成的特征提取模块,RB模块一开始是用两个3x3的卷积和一个Relu激活函数,接着用一个1 × 1的卷积对所传入的特征进行降维,降维后的信息将以较少的参数量传入通道注意力机制,并实现相应性能的提升。

最后,将RB模块中第一个1 × 1卷积的输出和经Sigmoid函数进行相乘得到相应的特征信息,再使用一个1 × 1卷积将特征信息的维度升为一开始输入的特征信息的维度,将升维后的信息与一开始输入的信息进行相加得到RB模块最终输出的信息。

Figure 2. Feature extraction module RDCA

图2. 特征提取模块RDCA

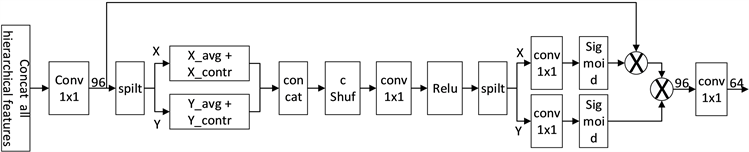

2.3. 层次特征融合模块

图像超分辨率重建中,分层特征信息的充分利用可以进一步提升网络整体结构的性能,如何使用层次间的特征信息对最终的重建有着很重要的影响。目前,已有的图像超分辨率重建中对层次特征进行处理的,使用最多的是仅使用一个1 × 1的卷积对分层特征进行压缩,这种方法并不能提取有效的特征,也不利于最终的图像重建。为此,本文设计了一个层次特征融合模块用于对层次间的特征信息进行处理,模块结构如下图4所示。

Figure 4. Hierarchical feature fusion module

图4. 层次特征融合模块

层次特征融合模块主要是对级联后的信息进行处理,首先使用一个1 × 1的卷积对信息进行维度变换。

接着,采用类似于坐标轴上的X轴和Y轴的方向对升维后的特征信息进行分割,得到类似于矩阵中的行矩阵和列矩阵所表示的特征信息,对分割后的信息分别进行平均池化和标准差的计算,得到相应的特征信息。接着将这两个级联后的特征信息通过混洗机制进行混洗,以使通道间的信息联系更加紧密,对混洗后的信息使用两个1 × 1的卷积和分割操作来对不同通道间的特征进行处理。其中,第一个1 × 1的卷积将特征维度变为原来的1/r (r表示维度压缩比例,r = 16),经Relu激活函数进行激活操作后,将信息以X轴和Y轴的形式进行分割,对分割后的信息分别使用一个1 × 1卷积将特征信息的维度进行复原。然后,使用Sigmoid函数对特征信息进行重新表示。

最后,将重新表示后的特征信息与第一次分割之前的特征信息进行依次相乘后得到包含重要特征的层间信息。接着,通过一个1 × 1的卷积对其进行降维,得到最终所需输出的信息。

2.4. 损失函数

神经网络的训练离不开损失函数,合适的损失函数可以使网络得到更好的训练和更好的网络性能。本文所提出的重建方法是基于GAN的思想进行设计的,整个网络涉及的损失函数有对抗性损失和生成器损失。

对抗性损失采用ESRGAN中所提出的方法 [13] ,分为鉴别器和生成器两个部分,生成器的对抗性损失与鉴别器的对抗性损失呈对称形式。

生成器损失由感知损失、生成器的对抗性损失和

损失函数构成,感知损失是采用

损失函数 [12] 用于定义图像的感知相似度。则,整个生成器的损失函数由式(1)表述:

(1)

其中,

和

是平衡不同损失项的系数。

损失函数是一个在视觉相似判断上更接近人类感知,是一个真正意义上的以符合人类判断的方式对图像的相似度进行衡量的“感知距离”损失函数。

3. 实验结果和分析

3.1. 实验设置

3.1.1. 数据集

虽然视景系统中的视景图像所包含的范围一般是180˚的半全景图像,但通过扁平化以及切割等技术处理,半全景图像则近似等于一个或多个平常的二维平面图。

因此,在实验中,本文采用了DIV2K [15] 和Flickr2K [16] 作为整个网络的训练集,总共有3650张图像,其中3000张图像为训练集,325张图像为验证集,另外325张为测试集。在评估验证方面,采用标准的测试集:Set5 [17] ,Set14 [18] ,BSD100 [19] 和Urban100 [20] 。为了便于与其它方法进行比较,本文采用的评价指标为:峰值信噪比PSNR和结构相似度SSIM [21] ,评价指标均在YCbCr颜色空间中的Y通道上进行计算。

3.1.2. 实验细节

为了扩充训练集,本文对整合后的训练图像进行90˚、180˚、270˚的旋转和水平翻转,并采用双三次下采样的方法来获得低分辨率和高分辨率图像对。网络初始学习率设置为5 × 10−5,优化器采用Adam,并设置

,

,

。训练时先对网络中的生成器进行训练,每轮训练迭代1000次,每次迭代中采用16个48 × 48的图像块作为输入,每经过200轮学习率减半,总共训练1000轮。在生成器训练完成后,对鉴别器进行训练,每轮训练迭代500次,每次迭代中采用16个48 × 48的图像对作为输入,总共训练500轮。整个实验采用pytorch框架进行搭建。

3.2. 超参数实验

本节主要是对网络中的特征提取模块RDCA的模块数进行实验,整个实验所反映出的性能是在Set5测试集上×4因子情况下进行完成。当模块数为2时,PSNR的值为32.19 dB,依次增加模块数,网络性能得到了相应的提升,当模块数为8时,PSNR最高,性能最好,当模块数持续增加时,网络性能开始下降,性能变差。原因是特征模块RDCA中的特征提取和复用的能力达到了饱和,继续增加模块数不仅不能提高网络性能,还会使训练变得困难。

3.3. 消融实验

本节主要是对网络中特征提取模块和层次特征融合模块中所采用的注意力机制进行实验,以验证模型中采用的注意力机制的作用,整个实验是在Set5测试集,×4放大因子的情况下进行。

在网络中,于RB模块和层次特征融合模块内同时引入注意力机制,PSNR值增加了0.09 dB。而在RB模块和层次特征融合模块内分别单独引入注意力机制时,PSNR值分别增加0.03 dB和0.06 dB。因此,在RB模块和层次特征融合模块内引入注意力机制对网络模型的性能有着很好的提升,尤其是在层次特征融合模块内引入注意力机制对网络性能的提升更加明显,这表明,层次间的特征信息的利用程度对最终的重建效果有着很重要的影响。

3.4. 客观结果比较

表1和表2分别显示了本文所提超分辨率方法与现有的先进超分辨率方法EDSR [7] ,MSRN [22] ,MDCN [23] ,RDN [9] ,DRFN [10] 在×2和×4这2种不同放大倍数时进行定量比较的结果(表中数据所表示的是PSNR/SSIM),两张表中每一行的数据分别表示的是:算法,EDSR,MSRN,MDCN,RDN,DRFN,GAN-RDCN,GAN-RDCN(+)。

Table 1. Performance of each module on different test sets with ×2 factor

表1. 在×2因子情况下各模型在不同测试集上的性能

Table 2. Performance of each module on different test sets with ×4 factor

表2. 在×4因子情况下各模型在不同测试集上的性能

从表1和表2可知,本文所提出的GAN-RDCN网络在测试集上的定性效果很多要高于其他方法,特别是在Set5和Urban100测试集上,不管是在哪一个放大因子下,本文所提出的方法均要优于其他方法。尤其是Urban100是由包含很多细节和纹理的建筑图像,这表明本文所提出的图像重建方法在图像细节和纹理的恢复上有着很好的性能。

3.5. 主观视觉比较

为了验证本文所提的方法在视觉效果上的优越性,本文从飞行模拟器的视景系统中选取了2张不同视角的图像用于视觉效果的比较,整个实验基于×4放大因子的情况下进行完成。由图5和图6可知本文所提出的方法在纹理细节的恢复上有着很好的效果,细节特征更加丰富,适用于视景图像的超分辨率重建,如:将图5进行放大后可以发现,在114下面的字体,相比于其他方法,本文所提出的方法来得更加清晰,将图6进行放大后可以发现,本文所提出的方法所对应的图像中白色部分包含实际跑道中出现的黑色痕迹。

3.6. 参数比较

表3显示了不同模型和参数性能的比较,所有参与比较的模型是在Set5测试集,×4放大因子的情况下进行计算所得出的参数量和性能的关系。

Table 3. The relationship between the performance of each model and the number of parameters in the case of ×4 factor

表3. 在×4因子情况下各模型的性能和参数量的关系

由表3可知,本文所提出的GAN-RDCN模型在测试集上的效果是最好的,但参数只有EDSR模型的1/3,这充分说明了本文所提模型的优越性。

4. 结束语

本文提出了一种基于GAN的飞行模拟器中的视景图像超分辨率重建方法,整个网络由生成器和鉴别器两个部分进行组成,生成器中采用不同维度的通道注意力机制,进行深层特征的提取以及层次间的特征融合,提升了网络对特征信息的复用以及细节纹理的恢复能力。在不同测试集上的实验结果表明,本文提出的方法与其它方法相比,本文在视觉效果上优于其他方法,在定性指标上也有着不弱于其他方法的性能,能有效地提高重建图像的质量,尤其是在视景图像上。未来将对网络的整体结构进行进一步优化,以提升其整体性能。

基金项目

飞行模拟训练设备视景投影系统升级研发项目(KC22201)。