1. 引言

随着我国城市化的脚步不断加快,人民对居住环境提出了更高要求,而园林景观设计是城市规划设计中的重要组成部分,对构建舒适的人居环境、推动了人和自然的共同发展、陶冶情操、等方面具有十分重要的作用 [1] 。园林景观设计效果图则是三维空间的艺术再现,是表达理念、艺术构思、设计意图的重要手段 [2] 。目前,园林景观设计效果图的色彩搭配和着色是由人工完成,存在工作量大、效率不高等问题。另一方面,随着人工智能技术的发展,深度学习已成为机器学习领域中一个新的研究方向,被应用于计算机视觉、图像识别、自然语言处理、图像分析等领域,且取得了良好的效果。因此,将深度学习技术应用到园林景观设计图着色中,可以缩短设计时间并且丰富设计方案,减轻设计工作量,提高工作效率。

图像风格迁移 [3] 是指将原始风格图像的艺术风格迁移到另一张没有该风格的图片上,然后生成一张新的艺术风格图像,图像在进行风格迁移后没有太大的内容损失,而且具有新的艺术风格。目前关于风格迁移领域的研究主要集中在艺术风格图像的迁移 [4] ,也有针对字体生成、服装设计、室内装饰和漫画插画风格等设计行业领域的研究。李进等人将风格迁移应用在蒙古文字体的生成上,实现从蒙古文标题字体生成蒙古文手写体等字体,得到的生成字体样式基本接近真实字体样式,达到字体风格迁移的效果 [4] 。马钰玺等人将风格迁移与传统服饰图像相结合,实现中华元素艺术化生成 [5] 。董学良等人基于图像风格迁移将服装图像风格转换到服装内容图像中,实现局部服装图像风格迁移 [6] 。冯威等人首次将图像风格迁移技术引入室内装饰设计领域,取得较好的迁移效果图,能够得到清晰且满足现代家居风格设计需求的迁移图像 [7] 。董虎胜等人基于图像风格迁移实现自然图像变换生成动漫插画风格图像,并且拥有很好的视觉质量 [8] 。Liu S等人将图像风格迁移应用在室内装饰设计中,可在室内装饰中实现艺术设计场景和各种类型的图像风格转换 [9] 。Cheng Z等人将神经风格迁移应用到验证码的设计中,以此来提高验证码的安全性,降低了自动攻击的成功率 [10] 。

本文将卷积神经网络、迁移学习技术引入到园林景观设计图的渲染领域,建立了基于卷积神经网络的园林景观设计图着色模型。该模型采用VGG网络模型提取园林景观设计图、色彩风格图和生成图的特征,通过损失函数计算生成图与内容图像和色彩风格图之间的损失,在训练过程中,最小化总损失函数,实现园林景观设计图的着色和景观季节色彩的变换,并通过仿真实验,验证了模型的有效性和实用性。

2. VGG网络

卷积神经网络(Convolutional Neural Network,即CNN)是一种具有局部链接和权值共享等特性的深层前馈神经网络。由一个或多个卷积层、池化层以及顶部的全连接层组成,能从大数据中自动学习特征,且深层的结构使它具有很强的表达能力和学习能力,主要用于图像、语音、文本等类数据处理。

VGG(Visual Geometry Group Network)网络模型是2014年牛津大学计算机科学工程系Visual Geometry Group组提出的一种深度卷积神经网络,VGG网络结构由卷积层、全连接层、softmax输出层构成,层与层之间使用max-pooling分开,所有隐层的激活单元都采用ReLU函数 [11] 。

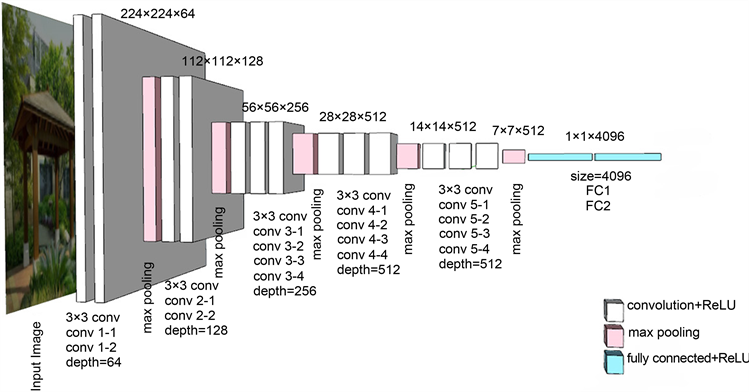

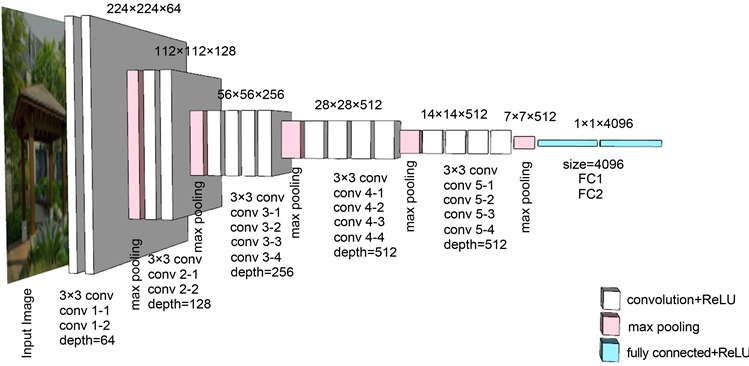

目前为止,VGG网络已经推出VGG-16、VGG-19等网络模型,VGG-16网络和VGG-19网络模型结构如图1、图2所示。VGG-19网络相比于VGG-16网络,在第3、4和5段卷积中,均多了一层卷积层,使得特征的提取更加充分。

3. 基于卷积神经网络的园林景观设计图着色模型

3.1. 着色模型

图像风格迁移是基于深度学习技术的一种特殊算法表达 [12] 。本文利用图像风格迁移技术,建立园林景观设计效果图的着色模型,实现园林景观设计效果图着色及季节景观变换。园林景观设计效果图的着色模型主要由卷积神经网络、损失函数和总损失函数构成。其作用是利用计算机处理技术通过特征提取、学习,在园林景观设计效果图的内容图像中融入给定风格图像的风格特征,从而得到风格迁移的目标图像,使结果图像既具保持原有内容图像的内容特征,又具有风格图像的纹理、色彩等风格特征,着色模型如图3所示。

Figure 1. VGG-16 network model structure diagram

图1. VGG-16网络模型结构图

Figure 2. VGG-19 network model structure diagram

图2. VGG-19网络模型结构图

图3中,VGG网络作为特征提取器,提取园林景观设计效果图(内容图像)、色彩风格图(风格图像)和生成图像的特征;损失函数用于计算生成图与内容图像的内容损失、生成图与色彩风格图之间的风格损失;总损失函数用于调整生成图像中包含的内容图像和风格图像的比例。在训练过程中,依据VGG网络抽取的特征计算损失,并以总误差下降为优化目标,调整模型参数,逐步降低内容损失和风格损失,从而得到最后的损失函数,最终实现图像风格迁移。

3.2. 损失函数

3.2.1. 内容损失函数

着色模型中采用的内容损失函数 [13] [14] 的计算式为:

(1)

式中,

为原始的内容图像,

为随机生成图像,

为第

网络层。

表示原始的内容图像

在第

层的卷积特征值。

表示生成图像

在第

层的卷积特征值,i表示卷积的第i个通道,j表示卷积的第j个位置。

将原始内容图像与风格图像作为VGG网络模型的输入,利用卷积层提取出两者对应的特征图,并计算内容损失。内容损失值越小,说明它们的内容越接近,内容损失值越大,说明它们的内容差距也越大。因此,通过将内容损失函数进行最小化操作,能够缩小生成图像与内容图像的内容差距。内容损失对

的偏导的计算式为:

(2)

3.2.2. 风格损失函数

图像风格的本质是在各种空间尺度中图像的纹理、颜色及视觉图案等特征,而不同卷积核所提取到的图像特征也不同。随着网络层数的深入,卷积核提取到的特征也会变得更加复杂和抽象。而深层网络特征的提取也需要综合底层网络提取到的边缘、形状与颜色等图像特征信息。这些不同卷积层提取到特征结合起来才能表示图像的风格。研究表明,Gram矩阵 [15] 能够从任意图像中提取出风格特征信息。Gram矩阵是一种对称的矩阵,可以在一个层的输出中,计算不同滤波器的空间相关性,通过使用多网络层的特征之间的相关性,可以得到了输入数据稳定、多尺度的表征信息,通过该方法可以学习提取到风格图像的纹理特征,并且不会注意到全局的内容信息。利用Gram矩阵计算风格图像的纹理等特征信息的计算式 [15] 为:

(3)

式中,

表示特征图i和j在第

层的内积。一系列的Gram矩阵是卷积神经网络对于给定风格而提供的固定描述。在第l层中,卷积特征的通道数为

,卷积的高与宽的乘积为

,

、

代表对应第

层的Gram矩阵,则第

层的总损失的计算式 [9] [10] 为:

(4)

式中,为防止风格损失在数量级上相比内容损失差别过大,设置

是归一化项。

用

表示原始的风格图像,

表示生成图像,将VGG网络模型的每一层卷积层,均作为风格特征提取层,经过单层风格损失加权累加后,可得到图像的总的风格损失,其计算式子为:

(5)

3.2.3. 总损失函数

着色模型中的总损失函数是由内容损失函数和风格损失函数进行加权求和而成,其中

和

分别是内容和样式重构的加权因子,其作用是实现调整目标图像的风格转换程度更接近于内容图像还是更接近于风格图像,总损失函数的计算式 [13] [14] 为:

(6)

式中,

为原始的内容图像,

为原始的风格图像,

表示生成图像。

4. 实验与结果

4.1. 实验环境和数据预处理

实验运行环境为:CUDA11.1、Cudnn8.0.4、Python3.8.0,采用Pytorch1.8.0深度学习框架,以及Ubuntu18.04操作系统,实验硬件配置为:华擎B450主板、Inter(R) Core i7-8700K CPU、16G DDR4 2666MHz内存、NVIDIA Geforce GTX1080 Ti显卡。

采用ImageNet [16] 上的风景图片作为数据来源,手动选取风景风格图片,对这些图片进行裁剪变换,对比变换,随机调整亮度等对图片进行增强。在网络进行训练之前,将内容图像、风格图像及随机初始化生成图像的大小修改为450 × 300,图像默认通道数为3。因为本实验使用迁移学习技术 [17] ,所以选择在ImageNet中预训练好的VGG-16网络模型与VGG-19网络模型提取图像特征,并舍弃其中的全连接层。其中,对于图像生成使用平均池化替代最大池化,由此来改善梯度流。

4.2. 实验结果与分析

4.2.1. 着色实验

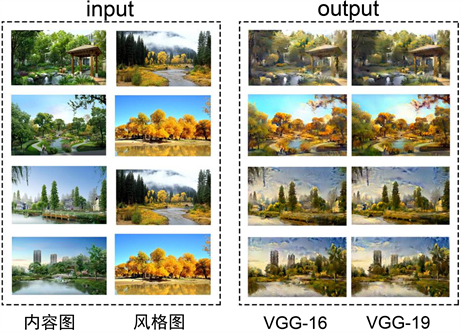

采用6幅不同的园林景观设计手绘效果图(未上色)和6幅不同的园林景观手绘着色风格图,分别在基于VGG-16和VGG-19网络的园林景观设计图着色模型上进行训练并着色,实验结果如图4所示,其中,第1列为手绘效果图(未上色),第2列为色彩风格图,第3列为VGG-16网络着色后的效果图,第4列为为VGG-19网络着色后的效果图。

Figure 4. Image comparison is generated by coloring experiment

图4. 着色实验生成图像对比图

从图4看出,经过模型训练最终可以实现园林景观着色,VGG-16网络着色模型的着色比VGG-19网络着色模型更加完整,色彩更加饱和及清晰,着色效果更接近人工手绘的设计效果图,更具有丰富的特征。

4.2.2. 景观季节变换实验

采用4幅不同的园林景观计算机辅助绘制图作为原始内容图像,2张秋季自然景观图像作为原始风格图像,分别在基于VGG-16和VGG-19网络的园林景观设计图着色模型上进行训练并变换,实验结果如图5所示,其中,第1列为手绘效果图(未上色),第2列为色彩风格图,第3列为VGG-16网络着色变换后的效果图,第4列为为VGG-19网络着变换色后的效果图。

Figure 5. Landscape seasonal change experiment to generate image comparison map

图5. 景观季节变换实验生成图像对比图

由图5可以看出,经过模型训练最终可以实现园林景观季节变换,并且VGG-19网络在图像质量则更加优良,更具有丰富的风格图像细节特征,在不同景观要素的分割上更清楚,对不需要风格化的要素影响较小。

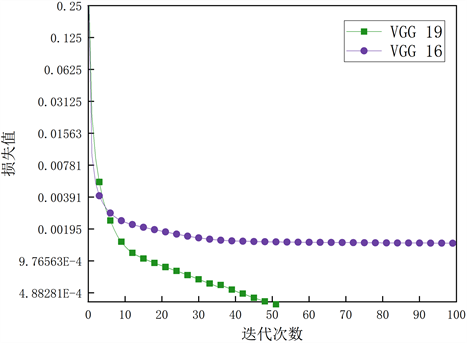

4.2.3. 总损失对比实验

本实验采用交叉验证的方式训练,共设置100个迭代次数(epoch),每5个epoch即开启验证一次。在计算过程中,由于收敛速度趋势的重复性较高,故选取四组着色实验的平均损失和四组景观季节变换实验的平均损失作为模型的总损失,绘制实验图,实验结果如图6和图7所示,2种模型的平均损失对比见分析表1。

Table 1. Comparison of average losses between the two models

表1. 2种模型的平均损失对比

由图6可知,在着色实验方面VGG-16网络更优于VGG-19网络,在第7次迭代训练时处于2个模型损失的相交点,因此本轮对园林景观设计着色的损失相同,两个模型收敛速度也比较接近,随着迭代次数的增加,收敛速度趋于稳定。但是VGG-16的损失一直都比VGG-19的损失要小,最后趋近于零。

Figure 6. Comparison of total loss in VGG-16 and VGG-19 network coloring experiments

图6. VGG-16和VGG-19网络着色实验总损失对比

由图7可知,在景观季节变换实验方面,VGG-19网络则优于VGG-16网络,在第7次迭代VGG-19网络的损失已经为0.000376后面趋近于平稳,而VGG-16在第7次迭代损失为0.000452,相对于VGG-19损失要高,虽然后续迭代也趋近于平稳,但是总体比VGG-19损失要大。

Figure 7. Comparison of total loss between VGG-16 and VGG-19 network landscape seasonal change experiments

图7. VGG-16和VGG-19网络景观季节变换实验总损失对比

5. 结论

针对园林景观设计图着色方面存在的问题,利用图像处理、深度学习、图像风格迁移技术建立了一种园林景观设计图着色模型,实验结果表明:

1) 基于VGG-16网络的着色模型获得的着色效果与手绘效果图差着色差异较小。

2) 基于VGG-19网络的着色模型获得的景观季节变换效果更加优良。

3) 基于卷积神经网络的园林景观设计图着色模型能够实现园林景观设计图着色和景观季节变换,具有良好的应用前景。

基金项目

甘肃省重点研发计划项目(21YF5GA088)。

NOTES

*通讯作者。