1. 引言

烧结工艺在不断改进,但在烧结过程中箅条的糊堵和掉落仍是一个需关注的问题。文献 [1] 讨论了糊堵的产生原因,如水分与粉尘结合、固态废料等。糊堵严重会造成烧结机台车通风面积下降,影响烧结产量和质量,制约烧结机的生产。且由于高温和热胀冷缩、磨损等原因,箅条卡槽会锈蚀松动,产生掉落问题,形成一定面积的缝隙,严重情况会造成矿石掉落影响烧结。因此,重点阶段需人为24小时监控,及时发现异常并处理。

随着图像技术的发展,国内外提出了利用视频监控来实现箅条智能监控诊断的思路,为解决人工监控的痛点,文献 [2] 中提出基于轮廓提取的方法提取箅条区域,并基于轮廓间距判断篦条故障。文献 [3] 中提到采用YOLOv3算法对箅条进行缺失检测。但对图像的获取质量偏理想化,由于工业环境的复杂性,粉尘大,温度高,设备安装空间限制等原因,实际的工况获取的图像将大大增加箅条故障检测的难度。

生产中无法保证待测台车垂直出现在相机视野中间,获取图像存在一定形变,本文聚焦图像预处理的矫正问题,针对图像无明显特征点,传统方法无法实现该工况中的角点定位的问题,提出了基于深度学习YOLOv3模型与传统图像处理相结合的方法,实现台车角点定位,基于角点定位完成图像展平和找出实际台车区域,为后续箅条的糊堵、间距和倾角求取打下基础。

2. 图像预处理和坐标关系换算

2.1. 图像预处理

烧结机台车底面篦条区域为

m2,由于采集空间限制,系统采用双相机同步获取图像,保证视野覆盖单个台车底面,相机安装位置如图1红色箭头所示。

由图1可知,台车沿着曲轨顺序经过采集区域,在预处理中基于篦条纹理分布,得到台车行驶过程中的最佳位置图像,如图2所示。得到最佳位置图像后,再采用SIFT图像拼接算法 [4] ,得到单台台车底面完整的篦条图像,如图3所示。

Figure 1. Diagram of the camera installation location

图1. 相机安装位置示意图

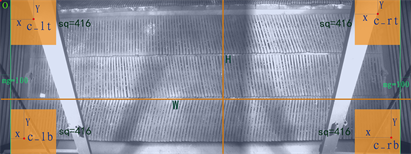

Figure 2. The left and right camera monitoring images of sintering machine grate bar

图2. 烧结机箅条的左、右相机监控图像

Figure 3. Corner positioning effect based on the original image

图3. 基于原图的角点定位效果

实际采集图像难免存在一定的梯形畸变,且包含小部分台车侧栏板区域。为减少栏板条纹纹理以及梯形畸变带来的误检,本文提出基于台车四个角点对图像进行矫正和区域提取。观察篦条图像,其角点区域存在一定遮挡,且全图纹理结构单一,角点区域无明显特征,将拼接后的原始图像直接送入YOLOv3进行角点检测,会存在一些误检区域,如图3所示,且整体检测速度很慢。

因此,本文根据台车运行轨迹的先验知识,先提取出四个角点的感兴趣区域,能有效减少冗余数据,提高训练速度,综合图像分辨率、系统运行速度、角点图像大小、数据集制作等多个因素,本文将大尺寸图像批量转换为416 × 416分辨率的小尺寸图像,最终得到一些列角点区域图像,如图4所示。

2.2. 坐标关系换算

在预处理中,提取出图像中四个角点的感兴趣区域,如图5中黄色方框所示。图中,mg表示感兴趣区域在原图中与左右边界的距离值,sq表示感兴趣区域的大小值,C_lt、C_lb、C_rt和C_rb表示四个角点。

Figure 4. Corner image after cutting

图4. 裁切后的角点附近图像

Figure 5. Coordinate transformation diagram on the pieced diagram

图5. 在拼好的图上坐标变换示意图

根据目标区域的大小和在原图中的位置,角点坐标(X, Y)换算到原图中的坐标公式如下:

左上角C_lt:

左下角C_lb:

右上角C_rt:

右下角C_rb:

其中,W,H表示原图的宽和高,mg的取值根据经验所得。

2.3. 四点透视变换

获得角点坐标后,可基于透视变换将篦条图像进行校正。透视变换 [5] [6] (Perspective Transformation)是将图片投影到一个新的视平面(Viewing Plane),也称作投影映射(Projective Mapping),其变换公式如下所示:

(1)

根据几何原理,已知四个点的坐标和目标四个点的坐标,即可求出式(1)右侧的变换矩阵,将图像与矩阵相乘即可得出新的图像。为便于观察,并保持图像的真实长宽比(台车的真实长宽比约为3:1),本文设置四个目标点的位置分别距边界一定距离,之后根据透视变换即可展平图像。

3. YOLOv3角点检测模型

3.1. 选择YOLOv3模型的考虑

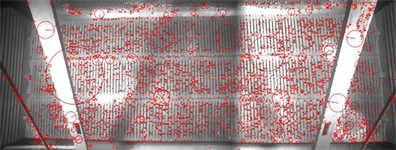

采用传统的SIFT特征点查找等方法,具有很大的不确定性,结果并不能完全确定角点的位置,也不能适应拍摄光照场景和角度的变化。实验发现通过二值图像处理的轮廓提取、霍夫直线变换等方法也不能确定角点位置 [7] 。图6展示了采用SIFT特征提取后的效果,其特征点分布杂乱且数量众多。

Figure 6. Results of the SIFT feature detection

图6. SIFT检测特征点结果

检测位置台车位于圆形曲轨区域,由于生产环境具有大量粉尘,基于视觉在线分析台车箅条图像最佳位置,因此每张图像的台车运行角度具有一定差异,直接确定角点坐标不可行。

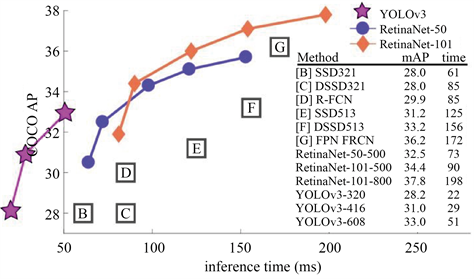

需要采用一种具有鲁棒性的,自适应性的角点查找方法,而且系统运行过程中需要能够快速定位角点,就目前来讲,这种方法只能依靠深度学习,而YOLOv3是目标检测领域速度和精度能兼顾得最好的深度学习模型之一,对比效果如图7所示。

Figure 7. YOLOv3 is compared with other AP models.

图7. YOLOv3与其他模型AP对比

3.2. YOLOv3模型介绍

YOLO是目标检测的经典模型,以速度快精度高著称,YOLOv3是YOLO网络的第三代,在前代的基础上对小目标检测、检测速度等方面有所提升 [8] 。其原理是:首先通过特征提取网络对输入图像提取特征,得到一定大小的特征图,比如13 × 13 (相当于416 × 416图片大小),然后将输入图像分成13 × 13个grid cells,接着如果GT中某个目标的中心坐标落在哪个grid cell中,那么就由该grid cell来预测该目标,如图8所示。每个grid cell都会预测3固定数量的边界框(YOLOv1中是2个,YOLOv2中是5个,YOLOv3中是3个,这几个边界框的初始大小是不同的)。

预测得到的输出特征图有两个维度是提取到的特征的维度,比如13 × 13,还有一个维度(深度)是B*(5+C),注:YOLOv1中是(B*5+C),其中B表示每个grid cell预测的边界框的数量(比如YOLOv1中是2个,YOLOv2中是5个,YOLOv3中是3个);C表示边界框的类别数(没有背景类,所以对于VOC数据集是20),5表示4个坐标信息和一个目标性得分。

3.3. 标注和迁移学习

本文选用Pascal VOC数据集上应用广泛的labelImg标注工具,标注500张图,其中90%划分为训练集,10%为测试集。标注时将角点置于标注框中央,在后续预测时即可通过求取中心点坐标判断为角点的坐标,再通过文中1.2提到的坐标换算得到整张图中角点的真实坐标。

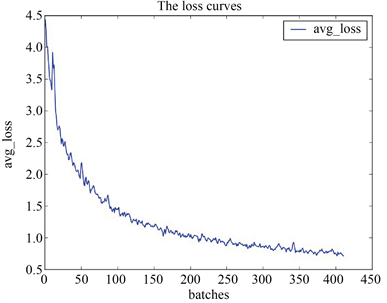

标注完成后,修改YOLOv3的cfg配置文件,如类别数、图片大小等,调试训练轮数、学习率等超参数,在Ubuntu下的darknet框架中进行训练 [9] ,采用Pascal VOC数据集yolo预训练的权重文件(不含全连接层)进行迁移学习。如图9所示,损失值随训练批次呈下降趋势。

Figure 9. Change of training loss value

图9. 训练损失值变化情况

实际训练过程中,虽然采用了迁移学习,YOLOv3仍需要设置数据增强参数,通过旋转角度、调整饱和度、曝光量、色调来生成更多样本,减小过拟合。

4. 结果分析

4.1. 实际测试结果

由于运行平台是基于windows的,在ubuntu系统darknet框架中训练得到的权重文件需转换成Keras框架下的.h5文件,实际运行平台为Win10+Xeon E5-1650+Quadro K2000,后端引擎为Tensorflow-gpu。

在系统上实际运行一天的结果显示,正常发现角点的图片占到了95%以上,检测单张大图时间少于1秒钟,准确率和速度均满足了要求,图10为角点定位结果。

4.2. 透视变化效果及后续结果影响

如图11所示,图像展平后对倾角和糊堵面积均有影响,得到了更加接近真实情况的结果,且减少了栏板区域的边缘纹理带来的干扰,有利于后续智能诊断的预警设置。

Figure 11. Influence of flattening image on results

图11. 展平图像对结果的影响

5. 结束语

本文深入研究了实际工况中烧结机台车角点定位问题,在完全基于现有图像的基础上,通过YOLOv3模型训练网络权重,对台车角点进行定位。实验证明,基于角点定位对原图像透视变换后,能提高检测的准确性,并能保证检测速度。对实际运行情况进行了统计,通过分析结果,验证了算法的可行性,且算法的鲁棒性较好,若后续光照或拍摄角度等信息发生变化,只要加入一些新的样本进行训练即可,算法扩展性强,为下一步箅条智能分析打下了基础。由于工控机使用了GPU,有些工控机并没有GPU,下步还需考虑CPU环境下系统的运行效率问题。