1. 引言

在半导体加工制造过程中,通过喷砂法在晶圆背面进行机械性损伤制造缺陷,形成软损伤层,使硅片具有吸杂能力。在热循环工艺中,当温度达到特定值时,如Fe、Ni、Cr、Zn等会降低载流子寿命的金属原子就会被引诱并本能地从内部移动到软损伤层,从而达到吸杂的目的,工业上通常依据缺陷数量判断晶圆的吸杂能力是否符合工艺标准。

目前在半导体检测方面,快速自动检测设备几乎被国外企业高价垄断,在国内半导体企业生产过程中,传统的人工识别方法仍占据主导地位,但对于小目标高密度的计数任务,其不仅劳动强度大,而且计数实时性差 [1] [2] 。随着图像处理技术的发展,对粘连目标分割成为对小目标计数的关键。先前学者针对不同的研究目标给出了不同的解决方案,传统方法包括:基于阈值的分割方法 [3] 、基于边缘的分割方法 [4] 和基于分水岭的分割方法 [5] 。传统算法的优点是简单高效,但受缺陷目标表面的粗糙程度、尺寸以及粘连程度等特征影响会出现过度或者欠缺分割现象,有时甚至出现无法分割计数的情况。随着机器视觉技术的发展,深度学习方法得到越来越广泛的应用。基于深度学习的目标检测算法虽然在自动驾驶等大目标领域广泛应用,但是该方法在实际应用中,由于小目标特征表达能力较弱,多次下采样后会损失较多的关键数据信息,因此对于晶圆背损伤缺陷目标的识别精度不高 [6] 。

本研究在现有方法的基础上,采用基于阈值的分割方法提取出前景部分中的缺陷目标区域,结合缺陷目标轮廓的包围盒信息将原始图片切片为局部图片,将局部图片按照连通域面积特征分类并制作数据集,采用迁移学习策略,结合带有预训练权重的YOLOv8目标检测网络训练生成权重模型,根据包围盒信息对权重模型识别到的目标点位补偿,最终实现对原始图片中的缺陷目标的自动标记和计数。本算法既可以避免传统算法导致标记计数结果不准确甚至无法识别的问题,同时又克服了深度学习方法存在的由于下采样损失较多的关键信息导致对小目标识别困难的问题。

2. 算法流程

晶圆背损伤缺陷自动识别方法的流程如图1所示,具体包括输入图片、图像预处理,图像切片算法、YOLO目标检测算法、后处理算法与输出结果等步骤。

2.1. 图像预处理

在工业生产现场采集晶圆背损伤缺陷时,由于光照不均匀和颗粒物本身因素的限制,所得到的目标图片往往会出现噪声。为了能够完整准确提取出局部目标缺陷,采用的图像预处理的流程如图2所示。

Figure 2. Image preprocessing flowchart

图2. 图像预处理流程图

在高倍率电子显微镜下拍摄的是三通道的彩色图片,为了降低运算复杂度,采用加权平均法转换为单通道的灰度图片 [7] ,如公式(1)所示,假设(x, y)表示当前图片中的任一像素点,Gray (x, y)表示像素点的灰度值,R (x, y)、G (x, y)、B (x, y)分别表示当前像素点分别在R、G、B三通道的像素值:

(1)

对灰度图片中的每个像素点进行线性灰度变换运算,从而最大化缺陷目标区域和背景区域的对比度,达到过滤背景区域中的噪声目的;由于灰度变换后的缺陷目标中心区域出现亮度不一致的情况,采用直方图均衡化方法可以在不影响整体对比度的情况下增强缺陷目标中心局部对比度;Otsu算法能够自动计算图像中目标区域和其他区域灰度临界值,从而在图像中分割出灰度值满足临界值条件的所有像素点形成的目标连通域 [8] 。

2.2. 基于目标轮廓包围盒的图像切片算法

轴对齐包围盒在三维空间中是一个正立方面体,它的每条边都平行于三维空间中的一个坐标轴,其在二维空间中称为最大外接矩形,主要用于对目标轮廓关键特征的提取与分析 [9] 。本算法首先查找预处理后的图像的目标轮廓,借助轮廓层级信息删除干扰轮廓,其次拟合出每个外轮廓的包围盒,最后使用包围盒对原始图片切片,从而增加目标缺陷在图片中所占像素的比例,实现增强输入数据的目的。

该算法首先进行轮廓查找,采用树型轮廓检索模式对预处理图片检测并返回所有轮廓,并且建立一个完整的轮廓层级结构,包括父子关系和兄弟关系,如图3所示。蓝色部分中的父轮廓区域通常包含缺陷信息,而红色部分中的子轮廓区域通常为背景区域,因此需要结合轮廓层级结构信息删除所有的子轮廓。通过返回的轮廓层级参数信息遍历每个轮廓的层级关系,如果该轮廓外不存在父轮廓,则表示它属于缺陷目标区域的轮廓,否则表示它属于由封闭的背景区域形成的轮廓。

Figure 3. Defect objective profile hierarchy diagram

图3. 缺陷目标轮廓层次图

其次逐一遍历筛选后的轮廓并拟合包围盒,假设当前轮廓由包含n个像素点的集合P构成,如公式(2)所示,MaxRect表示对当前轮廓拟合出的包围盒,Left Top Point表示对当前轮廓拟合的包围盒左上的顶点相对于原始图片中的坐标,Width表示矩形的宽度值,Height表示矩形的高度值;

(2)

如果直接采用包围盒对原始图片局部切片后,可能会引入过多的碎片化缺陷从而导致结果不精确。为了避免引入碎片化的问题,首先生成一幅与原始图片尺寸一致并且背景为纯黑色的底版图片,然后逐一遍历轮廓,并且采用纯白色填充方法将每次选中的轮廓包围的目标区域绘制在底版图片制作掩膜图片,其次将掩膜图片与原始图片对应像素点的灰度值做逻辑与运算即可提取出该轮廓包围的缺陷目标区域图片,最后根据该轮廓的包围盒对提取的目标区域图片切片即可获得局部缺陷目标图片。

2.3. 基于迁移学习的YOLO目标检测算法

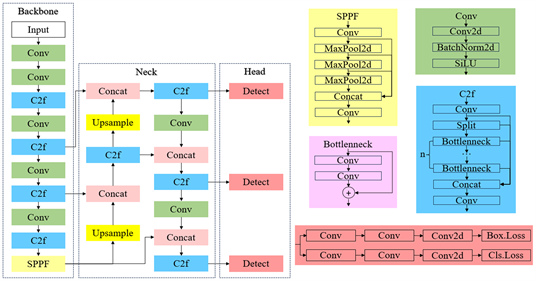

YOLOv8算法由Backbone、Neck和Head三部分网络结构组成,YOLOv8网络结构如图4所示。Backbone结构是一种采用基于深度卷积神经网络的特征提取结构,主要通过多个卷积层的堆叠和降采样操作,提取出不同抽象层级的边缘、纹理、形状等特征结构信息。其中使用的C2F模块不仅保证了结构轻量化,而且有助于在卷积过程中获得更为丰富的梯度流信息;SPPF模块主要通过引入不同的池化策略处理不同大小的特征图,实现对不同层次特征信息的捕捉。Neck结构是一种用于特征融合和上采样操作的结构,由一系列卷积网络层和上采样层组成,这些层可以将低级别的特征图与高级别的特征图进行融合,以提供更全局和更局部的特征信息,通过层级特征的融合可以更好地捕捉目标的细节和上下文关系,提高目标检测结果的准确性。Head结构通过逐层上采样和特征拼接的方式,融合不同尺度的特征信息,以提高目标检测的准确性和召回率,它将Neck结构中的第5层、第8层和第11层获得的3个特征图进行拼接,最后采用Detect操作预测特征图中的目标位置和类别,并输出检测结果。

Figure 4. YOLOv8 network structure diagram

图4. YOLOv8网络结构图

本算法损失函数包括分类损失和回归损失两部分。分类损失采用Varifocal Loss [10] ,Varifocal Loss是一种基于焦点的损失函数,用于处理类别不平衡的情况,它通过引入焦点参数来自动调节正负样本的权重,使得模型在训练时更加关注困难样本,从而提高模型的检测准确率。回归损失包括CompeleteIoU Loss和Distribution Focal Loss [11] ,CompeleteIoU Loss是一种用于回归的损失函数,它在计算预测框和真实框之间的重叠程度时,考虑了更多的因素,如形状、尺度等,相比于传统的IoU Loss损失函数能够更准确地衡量预测框和真实框之间的差异;Distribution Focal Loss是一种处理类别不平衡和背景类别的损失函数,它通过考虑各个类别的分布信息,让网络更加快速地聚焦于与目标位置距离近的位置的分布,从而提高目标检测的性能,这些损失函数可以提高目标检测模型的准确性和鲁棒性。

面积是图像处理中特征直方图内部的基本特征之一,它表示目标连通域范围内的所有像素点的个数,如公式(3)所示,Area (O)表示目标连通域O的面积,x和y分别表示连通域范围内任意一像素点的横坐标和纵坐标数值,Point (x, y)表示连通域范围内任意一像素点:

(3)

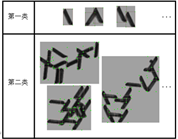

如图5所示,将切片后的局部图片按照目标连通域的面积特征分为两类,每类缺陷图片随机选取300张。采用labelImg标注图片样本中的识别目标制作数据集,并且按照7:1:2的比例将数据集划分为训练集、验证集和测试集。

Figure 5. Defective target area classification chart

图5. 缺陷目标面积分类图

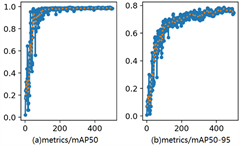

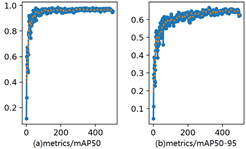

考虑到数据集样本少可能存在较困难的优化过程,因此训练过程采用迁移学习策略,选择标准化权重初始化YOLOv8网络,利用数据、任务或模型之间的相似性,通过源域和目标域之间知识的迁移使在源域训练而成的机器学习模型可以应用于目标域 [12] 。对于第一类和第二类缺陷,分别将训练参数中的图片尺寸设置为640 * 640和1200 * 1200,训练步长设置为500,从而生成对于晶圆背损伤缺陷识别计数的模型权重文件。如图6(a)、6(b)和图7(a)、7(b)所示分别为第一类和第二类缺陷训练过程中的平均精度指标图。

Figure 6. The mAP for type I objective deficiencies

图6. 第一类缺陷的平均精度指标

Figure 7. The mAP for type II objective deficiencies

图7. 第二类缺陷的平均精度指标

2.4. 后处理算法

使用训练后的权重文件对局部图片推理后,会得到一系列的目标区域候选框。通过设置合理的交并比(IoU, Intersection over Union)和置信度阈值,保证模型能够准确识别出缺陷目标。其中交并比反映的是预测目标区域与真实目标区域的重合程度,其取值范围在0到1之间,值越大表示重合程度越高;假设预测目标区域为

,真实目标区域为

,则交并比如公式(4)所示:

(4)

置信度反映的是预测框中包含检测目标的概率指标,其取值范围在0到1之间,其值越大表示预测框中存在检测目标的可能性越高。

本算法结合局部图片的包围盒信息,通过包围盒左上角的顶点相对于原始图片中的坐标对局部识别点位进行补偿,从而实现从局部图片识别点坐标向原始图片识别点坐标的回归,补偿方法如公式(5)所示,其中Absolute Mark Point表示标记点位在原始图片中的坐标,Left Top Point表示包围盒的左上顶点坐标,Relative Mark Point表示标记点在局部图片中的坐标。

(5)

3. 实验结果与分析

3.1. 实验环境

为了支持本文相关算法模型的训练与评估,本实验需要在高性能的计算环境中进行。实验设备包括配备多核CPU和高性能GPU的服务器,从硬件角度确保其计算能力和处理速度满足深度学习要求。服务器中的操作系统为Ubuntu发行版,同时本实验借助PyTorch主流深度学习框架,并通过CUDA工具加速计算过程,从软件角度确保了实验结果的准确性与可靠性。本算法部署的具体环境要求如表1所示。

Table 1. Algorithm deployment environment table

表1. 算法部署环境表

3.2. 实验结果

为验证本文算法有效性,在生产现场随机采集5张晶圆背损伤缺陷样本图片做识别实验。分别采用传统方法和本算法对缺陷目标做识别,识别标记结果如表2所示。以人工识别结果为标准,采用识别准确率和标准偏差系数两种指标对算法执行结果做实验分析,如表3所示。对比传统算法和人工算法的识别结果可知,传统算法的平均识别准确率为89.78%,平均标准偏差系数为7.62%,但是其对于粘连缺陷目标容易出现欠缺或者过度识别标记的情况;对比本算法和人工算法的识别结果可知,本算法的平均识别准确率为96.81%,平均标准偏差系数为5.5%,并且精确实现了对于粘连缺陷目标的识别计数。综上,和传统算法相比,本算法对于晶圆背表面损伤缺陷识别更为精确。

Table 2. Comparison table of labeling results

表2. 标记结果对比表

续表

Table 3. Identifying data analysis table

表3. 识别数据分析表

4. 总结

本算法在图像预处理算法基础上,采用感兴趣目标的连通域包围盒将原始图片切片为局部图片,根据局部连通域面积特征将其分类,并输入到采用迁移学习策略训练生成的模型文件,最终通过后处理算法实现对局部图片识别到的标记点位的补偿。通过对人工方法、传统方法和本算法的实验数据分析可知,本算法的平均标准系数偏差系数为5.5%,平均准确率达到96.81%。实验结果证明本算法相比传统算法具有更高的识别准确率,降低了工人的劳动强度,具有较好的现实意义和应用前景。

参考文献