1. 引言

目标跟踪作为计算机视觉领域的重要研究方向,在智能监控 [1] [2] 和人机交互 [3] [4] 等领域有着广泛的应用。在这些场景中,目标的运动轨迹是非线性的,而且背景中常常存在大量的噪声。由于粒子滤波器可以应对非线性系统和非高斯噪声,因此提供了一种稳健的跟踪框架 [5] [6]。在复杂的跟踪场景下,目标外观易受光照变化、遮挡、形变等因素的影响。因此,单一的视觉特征很难准确地表征目标。不同信息在不同场景下所起到的作用有所差别,许多学者利用信息之间的冗余性和互补性,提出多种信息融合的目标跟踪算法,以解决单一信息的不足 [7] [8] [9]。本文采用民主融合策略将形状信息和颜色信息自适应融合,该策略可以根据当前场景动态调整各特征信息的权重,从而更好地利用不同特征信息,改善动态场景的跟踪性能。本文主要研究行人头部跟踪。

2. 粒子滤波算法

粒子滤波的核心思想是使用非参数化的蒙特卡罗近似实现递推的贝叶斯滤波 [10],即利用带权值的粒

子表示系统的条件后验概率密度

,其中

表示当前的观测信息。从重要性密度函数中采样N个独立同分布的粒子

,根据蒙特卡洛思想,可以通过加权逼近系统的条件后验概率密度,即:

(1)

其中

为第i个粒子在k时刻的归一化重要性权值,

为k时刻第i个粒子的状态,

为狄拉克(Delta)函数。

粒子滤波提供了一种鲁棒的跟踪框架,它可以保持选择的多样性,同时考虑多个状态假设。在跟踪过程中,通过对多个候选粒子加权求和可以获得当前跟踪目标的状态(状态包含目标位置、宽高等信息)。

3. 特征提取

3.1. 颜色特征

为了在跟踪场景中区分跟踪目标和背景,必须选择区分度显著的视觉特征来描述目标。颜色是一种最常用的特征,在跟踪过程中,目标易发生旋转,缩放等变化,在这些过程中颜色特征一般比较稳定。使用颜色特征构建似然模型可以使目标跟踪变得简单易行 [11]。

本文采用常用的颜色直方图来描述颜色特征,直方图特征维数为

,分别代表R、G、B三个颜色通道的量化级数。为了降低背景干扰,增加可靠性,引入一个核函数,定义如下:

(2)

其中r表示像素点与区域中心点的归一化距离,离区域中心点越远核函数值较小,反之较大。

设y表示区域的中心点,

为区域内的像素点,那么该区域的颜色分布可表示为:

(3)

(4)

(5)

上式中I表示区域内所有的像素点个数;

为单位冲击函数,判断像素

是否在直方图的第u个单元上;f确保了

;

和

分别为目标区域的半宽和半高。图1表示选中区域对应的颜色直方图。

参考文献 [12] 的方法,使用巴氏系数来衡量候选粒子与目标模板之间颜色上的相似度:

(6)

其中,

和

分别表示候选粒子和目标模板对应的颜色直方图。

上式中,相似度与巴氏系数成正比。为了方便计算,进一步将它转化为巴氏距离:

(7)

巴氏距离越小,两种分布的相似度越高,越大则相似度越低。

得到相似度后,对相似度做进一步处理,使相似度高的粒子有较大的权值,反之粒子权值较小。颜色相似度定义为:

(8)

其中

表示颜色信息相似度的协方差。

3.2. 形状特征

颜色信息一个固有缺陷是没有充分考虑像素点之间存在的空间结构关系。当出现颜色特征相似的目标、或者目标的颜色信息发生一定改变时,就会对跟踪产生影响。例如跟踪一个人的头部,当他转身造成面部颜色特征消失时,就有可能导致跟踪失败。

本文引入目标形状信息。我们将人的头部轮廓近似看为一个椭圆,如果在图像中搜索到椭圆区域,则此区域很有可能就是目标区域,可以根据轮廓周边梯度变化较大的特点加以确定。

对于一个椭圆区域X,椭圆圆周上的梯度和表示为 [13]:

(9)

在椭圆圆周上,

为像素点j处的灰度梯度,

是总像素数。

人的头部轮廓不是真正的椭圆,为了提取到与实际相符的梯度,我们做如下改进。先求出像素点j的法线,以像素点j为中心、在法线上截取一段固定长度的线段

。我们用Canny边缘检测器沿j的法线方向检测图像边缘,可以得到线段

中属于边缘的点。求得

的所有边缘点的梯度,将梯度最大的点对应的梯度作为像素点j的梯度:

(10)

其中

表示

上的像素点的坐标。形状相似度为:

(11)

其中

是对应的高斯分布方差。

3.3. 民主特征融合策略

粒子滤波算法中最重要的一步是求解粒子的权重,本文采用民主融合策略根据当前场景下不同信息的可靠性,为不同的视觉信息赋予相应的权重,求取每个粒子的权重 [13]。这种自适应的融合方式可以实现不同信息的互补,提高跟踪算法的鲁棒性。最终的权值公式为:

(12)

其中

和

分别为颜色信息和形状信息的权重系数,表示信息的可靠性。且有

。则第k帧第i个粒子最终的权值表示为:

(13)

最终目标预测状态为:

(14)

因此,我们需要定义一个可靠性因子q来衡量由单个信息得到的预测结果与信息融合的目标模板之间的距离,q定义为:

(15)

(16)

其中

和

分别表示颜色信息、形状信息与融合信息之间的可靠性,

和

分别表示颜色信息权重、形状信息与融合信息之间的巴氏距离。距离越小,q越大,说明该信息的可靠性越高。a为常数。

一般情况下,相邻的两帧图像之间目标状态不会产生很大的变化,因此我们引入计算信息权重系数的公式:

(17)

其中

是常量,用来确定加权。

是连续两帧之间的时间间隔。

4. 完整的粒子滤波跟踪算法流程

完整的粒子滤波跟踪算法步骤如下:

1) 初始化:人工标注第一帧中的跟踪目标,以它为中心,采样得到N个粒子

,初始化赋予所有粒子相同权重,初始

;计算目标模板的颜色分布直方图。

2) 预测:利用状态转移方程得到当前时刻的粒子群

。状态转移方程为:

(18)

A为状态转移矩阵,

为高斯噪声。

3) 计算粒子的权值:根据公式(8)计算

,根据公式(11)计算

,然后根据公式(12)计算粒子融合后的权值w。

4) 目标状态估计:由公式(14)计算出k时刻的估计结果;由公式(15)和(16)分别计算两种信息的可靠性因子

和

;根据公式(17)和条件

计算出k + 1时刻两种信息的权重系数

和

。

5) 重采样获得一组新的粒子集

。

6) 判断是否结束,不结束则

,返回步骤2)。

5. 实验结果与分析

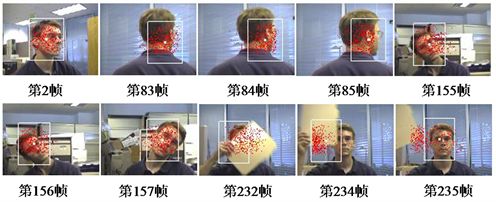

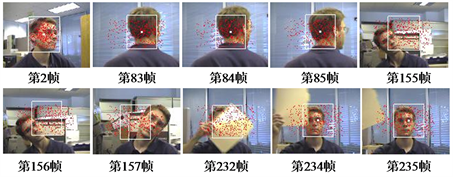

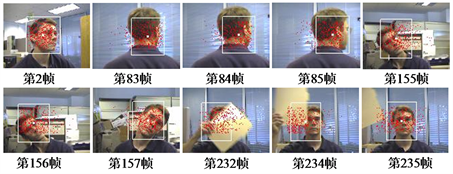

5.1. 男子头部跟踪实验

该实验视频拍摄场景在室内 [13],待跟踪目标是场景中男子的头部,该视频中没有其他人出现;跟踪难点在于目标移动是非线性的,并且在移动过程中还带有非平面旋转,存在部分甚至是全部遮挡。视频长度为500帧,每帧大小为

,帧率为30帧每秒。分别用基于颜色信息、基于形状信息、基于两种信息融合的粒子滤波跟踪算法进行对比试验。实验结果见图2,图3,图4。

Figure 2. Particle filtering algorithm based on color information

图2. 基于颜色信息的粒子滤波算法

Figure 3. Particle filtering algorithm based on shape information

图3. 基于形状信息的粒子滤波算法

Figure 4. Particle filtering algorithm based on information fusion

图4. 基于信息融合的粒子滤波算法

从83帧到85帧,男子头部发生非平面旋转。如果仅采用颜色信息,由于头部旋转时面向镜头的主要是黑色头发、与初始的颜色特征有很大差距,因而跟踪框在这三帧明显偏向和肤色很接近的脖子部分。图232帧到235帧男子用和肤色很接近的黄纸扫过面部,跟踪框定位到黄纸上面去了,当黄纸离开后,跟踪才恢复,重新跟踪到目标。

图156帧和图157帧男子晃动头部,轮廓是一个倾斜的椭圆。如果仅采用形状信息,由于我们设定人的脸部轮廓是一个竖直的椭圆,就会导致跟踪出现错误,基本丢失目标。

如果采用两种信息融合的方法进行跟踪,在整个视频中都能准确的跟踪目标。实验证明,基于两种信息融合的粒子滤波算法相对于其他两种更具有稳定性。

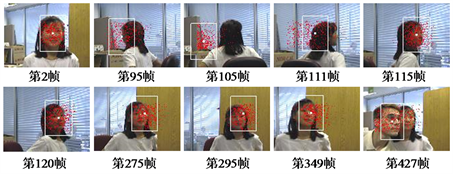

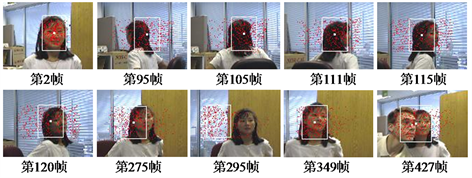

5.2. 女子头部跟踪实验

视频中的场景是室内 [13],摄像头随女子头部移动。视频长度为500帧,每帧大小为

,帧率为30帧每秒。此视频中跟踪目标存在平移,非平面内旋转,场景的颜色特征与目标颜色特征相似,相似目标的遮挡等诸多难点。我们采用不同的跟踪算法进行对比实验。实验结果见图5,图6,图7。

Figure 5. Particle filtering algorithm based on color information

图5. 基于颜色信息的粒子滤波算法

Figure 6. Particle filtering algorithm based on shape information

图6. 基于形状信息的粒子滤波算法

Figure 7. Particle filtering algorithm based on information fusion

图7. 基于两种信息融合的粒子滤波算法

从95帧到120帧,女子头部发生非平面旋转。如果仅采用颜色信息,由于图片左边的纸盒颜色和人的面部肤色较接近,并且头部旋转时面向镜头的主要是黑色的头发、与初始的颜色特征有很大差距,因而跟踪框在95帧和105帧丢失目标,跟踪到纸盒上面。图111帧到120帧女子的脸部转过来,跟踪算法恢复,重新跟踪到目标,进一步证明了粒子滤波算法具有从短暂跟踪失败中恢复的能力。

从275帧到295帧,对于仅采用形状信息的粒子滤波算法,女子头部左侧是梯度变化明显的窗帘背景,由于窗帘处梯度变化明显,导致跟踪失败。在图349帧中人脸挡住了窗帘,跟踪恢复。而采用两种信息融合的方法在275帧、295帧均未出现跟踪失败。说明了基于两种信息融合的粒子滤波算法的鲁棒性。

6. 结语

本文针对复杂场境下单一特征难以准确描述目标的问题,研究了一种基于形状信息和颜色信息自适应融合的粒子滤波算法。实验证明,与单独采用颜色或者形状特征的方法相比,基于两种信息融合的粒子滤波算法具有更好的鲁棒性。