1. 引言

目标跟踪技术可以被广泛地应用到视频监控、人工智能、无人驾驶等领域,是目前计算机视觉领域中重要的一部分 [1]。目标跟踪技术是指提前向算法输入目标的具体位置以及尺寸大小,然后在后续的视频序列中估计出目标出现的具体位置以及尺寸大小 [2]。由于目标追踪的过程中可能存在背景杂乱、光照变化等复杂的干扰因素,并且这些干扰因素会影响目标跟踪结果的精度,使得实际过程中难以取得理想的跟踪效果 [3]。

相关滤波技术(Correlation Filter, CF)框架是近几年来目标跟踪算法领域中的主流框架 [4]。基于相关滤波技术的目标跟踪算法流程主要包括:算法的初始化、目标特征提取、确定算法模型、进行目标定位、算法模板更新。如图1所示,当第一帧图片输入以后,算法的模型开始初始化,在后续帧中算法的更新和目标的定位交替进行 [5]。

Figure 1. Correlation filter tracking process

图1. 相关滤波跟踪流程

2016年,Danelljan等人提出了连续卷积跟踪算法(learning continuous convolution operators for visual tracking, C-COT),该算法采用了VGGNet的卷积特征,通过连续空间域进行差值操作,将不同分辨率的特征输入到滤波器中进行训练 [6]。2017年,Danelljan等人在C-COT的基础上,又提出了一种高效卷积性能的跟踪算法(efficient convolution operators for tracking, ECO),相较于原来的C-COT算法该算法减小了模型参数、压缩训练样本空间大小以及提供固定的模型更新策略 [7]。减少了80%的模型参数,90%的训练样本数,80%的优化迭代次数 [8]。

虽然当前的目标跟踪算法有较好的跟踪效果,但现存的跟踪算法主要采用的都是较为单一固定的模型更新策略进行更新。在实际的目标过程中,目标所处的环境变化很大,较为单一的更新策略难以应对复杂的环境 [9]。目标跟踪算法在跟踪目标更新时多采用逐帧更新或固定帧数间隔更新的方式 [10]。从跟踪序列样本和实时视频的观察中,容易了解到相邻的帧之间存在很强的相似性。当目标跟踪算法采用逐帧更新时,从这些样本中提取目标特征使得跟踪器容易发生过拟合,并且会造成不必要的计算时间及内存消耗,因此没有必要频繁地对框架参数进行更新 [11]。当目标跟踪算法采用固定帧数间隔更新时,无法针对目标环境变化,及时提供更多变化后的目标特性信息。

针对以上问题,本文设计了一种根据基于目标状态变化而调整滤波模板更新次数的自适应更新跟踪算法,算法的贡献包括以下几个方面:

1) 利用加权峰值旁瓣比原理对跟踪目标的特征响应图进行计算,估计出目标当前运动状态。计算目标变化状态下的旁瓣比。

2) 依据对目标状态变化的估计结果,自适应调整目标跟踪过程中滤波模板更新的间隔帧数。

同时采用OTB-100数据集 [12] 对本文提出的算法进行评估,由实验结果可知,改进后的算法能更好地应对不同的环境,具有较高的精度和鲁棒性。

2. 高效相关滤波目标跟踪算法

ECO算法 [13] 提出的因式卷积操作,降低了训练模型中参数的维度,同时采用高斯混合模型来生成不同的训练样本,将可能相似的训练样本归为同一类,减少了目标过拟合的情况,同时降低了模型的更新频率,提升了运算效率。

2.1. 分解卷积算子

在M个训练样本

中 ,每个单独通道d的特征层

具有不同大小的分辨率。其中样本空间x表示为

,

为

中的空间样本数量。使用插值模型

,将特征映射到目标连续空间域

。

(1)

1) 式中:

是一个周期为T > 0的插值核,

插值特征层,为连续周期函数。当

时,

表示插值特性映射。

ECO算法使用了基础滤波器中贡献最大的一组滤波器C (C < D)

,替代了基础算法C-COT中为每一个特征通道单独训练出的滤波器

,因式卷积算子如下:

(2)

2) 式中:P为

的系数矩阵,

为线性降维算子,

是特征层为C的滤波器的线性组合,

是对

进行滤波学习的系数。分解卷积算子可以使用不同的方式训练滤波器f和矩阵P。通过这个函数,所有的特征通道的卷积响应值被求和,得到最终定位的置信度。

在训练过程中,样本的标签也被映射为

,以此来保持空间各区域的采样点与标签一一对应。将

应用到训练样本

后得到期望输出的结果标签

。滤波器f通过m个训练样本对

来最小化(3)式函数。

(3)

3) 式中:j代表样本数,权重

决定了每一个训练的样本在训练过程中所占权重,正则化项对应着背景特征的空间区域,能够控制滤波器f在任意尺寸大小的图像区域进行训练,

被赋予了一个较大的值进行惩罚约束,对应的是目标的空间区域。

2.2. ECO算法基本流程

首先,算法提取给定区域的目标特征,提取的特征包括颜色特征和梯度方向直方图特征,同时利用余弦窗函数来缓解边界效应。然后将获取到的特征进行卷积运算然后映射到连续的空间域中,后采用主成分分析方法对特征降维,提取模型中能量高的信息部分,至此完成ECO算法的初始化 [14]。后续的跟踪过程中将处理好的目标特征与滤波器进行卷积操作得到滤波检测得分,再将特征加入到样本空间模型进行更新。

使用牛顿法对响应得分进行优化,得到跟踪目标的估计位置,并进行下一帧的跟踪操作。每隔

帧对滤波器进行更新。ECO算法的流程如图2所示。

3. 自适应更新机制

3.1. 目标状态变化分析

在基于相关滤波目标跟踪算法中的响应图计算公式为:

(4)

在(4)式中,

为

的傅里叶变换。

为从目标搜索区域中提取到的第t帧的特征。

为第

帧的滤波模板,

是由历史各帧的不同滤波模板融合得到。跟踪算法根据响应图G的最大值确定当前被跟踪目标的中心位置 [15]。

在以往的相关滤波算法中并没有对不同时期的历史滤波模板

区别处理 [16]。本文通过分析发现,不同时期的历史模板对实现准确跟踪的贡献不同。那么对不同时期的历史模板执行不同的操作可以影响跟踪的结果。例如,当跟踪目标开始受到光照因素影响时,跟踪目标的状态发生变化,根据状态的变化改变提升模板的更新频率,避免固定帧数更新造成目标关键信息丢失,提升算法的鲁棒性。

为了能更好地判断跟踪目标的状态变化,在本文的策略中采用了归一化处理后的加权峰值旁瓣比

的值来衡量跟踪目标在第t帧的状态 [17]。其中

为第t帧的滤波模板响应图的加权峰值旁瓣比。取得连续帧数的

可以直观地反映跟踪目标的状态变化。如图3中所示,未遮挡情况下的响应图的波峰明显比遮挡情况下的响应图平滑。

Figure 3. Response diagram of tracked target in different states

图3. 被跟踪目标处于不同状态时的响应图

其中,

的取值范围为

。

的计算公式为:

(5)

在公式(5)中,

为第t帧的响应图,

代表求出第t帧的最大响应值,

为去除中心位置

像素范围的响应图,

代表响应的平均值,

代表第t帧的响应图的标准差。

为峰值旁瓣比(Peak-to-Sidelobe, PSR),

相当于旁瓣比的权重,因此公式(5)可以认为是加权峰值旁瓣比。

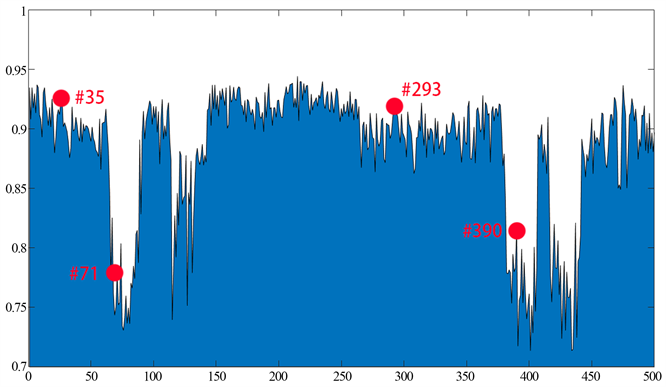

如图4展示了目标跟踪算法在Car2的跟踪过程中

值的变化趋势。在Car2视频数据中跟踪目标为位于图片左侧的白色车辆。从图4中可以看出由于第35帧和第239帧中的目标没有进入阴影区域且跟踪得较为准确,因此第35帧和第239帧的WPSR值较高(第35帧的值为0.92,第239帧的值为0.93)。在第71帧和第390帧中的目标皆进入阴影区域,因此第71帧和第390帧的WPSR值较低(第71帧的值为0.77,第390帧的值为0.81)。由于第35帧和第239帧在未被遮挡的情况下的WPSR值远大于第71帧和390帧的WPSR值,因此若将WPSR值作为跟踪目标状态变化与否的依据可以有效地提升滤波模板的鲁棒性。类似第71帧和第390帧这类处于变化状态的帧中有效信息较为稀疏,若采用低频率地更新滤波模板会造成部分有效信息丢失。类似第35帧和第239帧这类帧中有效信息较为丰富,但这类帧的相邻帧相似度很高,若采用高频率地更新滤波模板容易过拟合,且会造成不必要的内存消耗和时间花费。因此,通过上述分析可以得出,在目标跟踪过程中如果该帧的WPSR值较高,则说明跟踪目标状态稳定,滤波模板不需要过多重复的特征信息,如果该帧的WPSR值较低,则说明目标状态不稳定,滤波模板需要更多的特征信息进行更新。

Figure 4. WPSR value analysis of different historical templates (the targets in frames 35 and 293 are predicted accurately without shadow occlusion, and the targets in frames 71 and 390 are shadowed)

图4. 不同历史模板的WPSR值分析(第35帧和第293帧目标预测准确且无阴影遮挡,第71帧和第390帧目标被阴影遮挡)

3.2. 自适应更新帧数调整

在目标跟踪过程中,合理地跟踪目标更新机制对于目标跟踪算法的准确性及鲁棒性有极大的影响。高质量的滤波模板是保证算法性能优异的重要因素之一 [18]。滤波模板为保证自身准确性需要在跟踪过程中持续进行更新,选择一个合适的节点进行更新策略的调整是保证滤波模板始终具有较高质量的重要环节之一。如图5所示,跟踪的目标状态变化过大,滤波模板需要更加频繁地进行更新。

Figure 5. The target state changes greatly

图5. 目标状态变化大示例

在目标跟踪过程中,当目标的状态变化很大时,目标的外观变化幅度和目标的外观变化概率都将大大提升,此时,若不能及时的对滤波模板进行更新,则极有可能造成滤波模板发生漂移,最终导致跟踪目标失败。当目标的状态变化很小时,目标的外观变化幅度和目标的外观变化概率都保持在一个较低的水准,此时,若采用过于频繁的滤波模板更新频率则容易造成低效信息冗余,从而引起滤波模板的过拟合,最终容易导致目标跟踪算法的鲁棒性大大降低。如图6所示,跟踪的目标状态变化小,滤波模板不需要过多的更新。

Figure 6. Small change of target state

图6. 目标状态变化小示例

为了使跟踪算法应对目标状态的变化的瞬息万变,本章根据目标的WPSR值的变化自适应条件滤波模板的更新间隔。在目标跟踪过程中当目标状态变化较大时可以适当地提高滤波模板的更新间隔。在目标跟踪过程中当目标的变化状态较小时可以适当地降低跟踪算法的滤波模板更新间隔。

因此本章通过比较稳定状态下的估计值

和当前帧t的

值来确定当前帧t的更新间隔。当

值大于或等于

值时,则适当增大滤波模板的更新间隔。从而防止滤波模板过拟合进而导致跟踪算法的鲁棒性降低。当

值小于

值时,则适当减小滤波模板的更新间隔。从而防止滤波模板欠拟合导致模板漂移,进而导致跟踪失败。第t帧的更新间隔

与

值的关系如公式(6):

(6)

在(6)式中,

为第

帧时滤波模型更新间隔,

为间隔更新帧数的标准差。

稳定状态下的

估计值为:

(7)

其中

为稳定状态下WPSR值的标准差。

4. 实验与分析

4.1. 实验细节

在本章中采用了ECO作为基线跟踪算法,融合了基于峰值旁瓣比自适应更新策略的跟踪算法被称为ABPS (Adaptive updating strategy based on peak-sidelobe ratio)。对于本文实验结果,采用的是中心位置误差(CLE,用

表示) [19] 和重叠率(overlapping ratio,用

表示) [20] 两种方法进行评估:

, (8)

, (9)

在(8)式中,

为第t帧的跟踪目标中心位置,

为当前帧跟踪目标的实际中心位置。

为第t帧的跟踪结果所覆盖的区域,

为第t帧的实际位置所标注的区域,

表示区域的合并,

表示区域的重叠。

在本章实验中,使用的是一次性通过评估方法(OPE)的精确度图及成功率图来评估算法的性能。

4.2. 定量分析

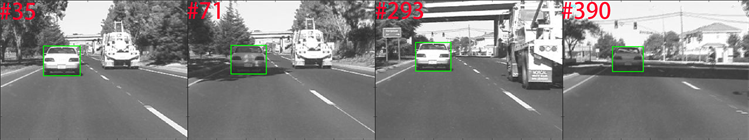

图7是算法在视频序列集上的精确度图和成功率图,改进后的算法精确度为79.9%,比原始的ECO算法的精准度提高了3.2%。本文测试的跟踪环境主要包括:快速运动(FM)、形变(DEF)、运动模糊(MB)、相似背景干扰(BC)等 [21]。在这9种不同跟踪条件下,得出改进后的算法和9种对比算法的精确度和成功率如表1和表2所示。

由表2可以得出,本文提出的算法在9种不同的跟踪环境下,其中有7种情况精度排名为第一,在形变和低分辨率的情况下排名第二,且相较于原ECO算法有所提高。由表3中不同算法的成功率可知,本文提出的算法在不同的跟踪环境下成功率均排名较高,且有6种情况下排名第一,平面外旋转、遮挡和形变的情况下排名第二,且比原ECO算法有所提高。因此改进的算法具有较高的精确度和鲁棒性,能够较好地应对复杂场景情况下的目标跟踪问题。

Figure 7. Accuracy and success chart of OPE evaluated by OTB-100

图7. OTB-100评估的精确度图和成功率图

Table 1. Accuracy of tracking algorithm in different cases

表1. 不同情况下跟踪算法的精确度

Table 2. Success rate of tracking algorithm in different cases

表2. 不同情况下跟踪算法的成功率

表3为本文改进算法与其他几种对比算法的关于中心位置误差及平均重叠率的比较结果。改进后的算法与原ECO算法相比较,平均重叠率提升了3%,中心位置降低提高了9 pixle。因此,本文改进后的算法能够更好地适应目标跟踪过程中的复杂环境变化,提高了跟踪的准确性和鲁棒性。

Table 3. Overlapping ratio, center location error and speed of 9 tracking algorithms

表3. 9种算法平均重叠率、中心位置误差和速度

4.3. 定性分析

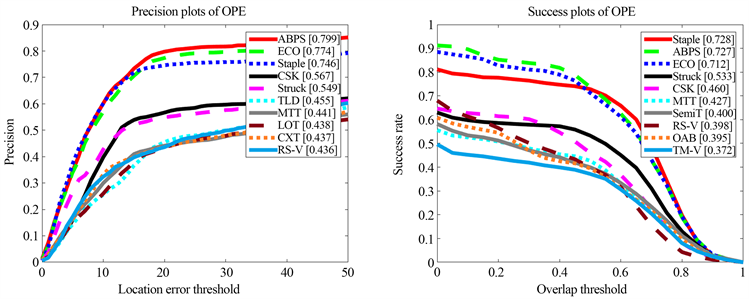

在OTB-100序列集中选取了具有代表性的视频序列跟踪数据,如图8所示。本节使用ECO、Staple、CSK、Struck等精度较高算法在不同场景中定性地对比分析跟踪算法的精确度和鲁棒性。

在Skating2视频序列中,算法跟踪的目标是图中黑色衣服的男性滑冰选手,同时在Skating2序列中存在着相似目标干扰等问题。可以看到在第13帧时,由于人物部分重叠原ECO算法产生漂移,与此同时Staple、Struck等框内出现了女性选手。由于50帧前时目标发生重叠情况,后又多次旋转,到第454帧时,只有本文准确定位到目标。因此本文算法能够在相似目标的干扰下保持较高的跟踪精度。

Figure 8. Tracking results on test video in sequence set

图8. 数据集上部分测试视频的跟踪结果

在Twingings视频序列中,算法需要跟踪的目标是手里的方形盒子。从第95帧开始到150帧,目标由远变近,尺度发生变化,Staple、CSK、Struck的算法没有很好的适应目标的外观尺度变化。在第242帧到第432帧,目标因发生旋转导致外观和尺寸巨大变化,原ECO算法的发生漂移,不能较好地适应新的尺寸和位置。在Biker视频序列第63帧到94帧时目标快速地跳跃到了另一条轨道上,此时视频序列含有快速移动、运动模糊等干扰因素,在目标由面向转为背向时,Staple、CSK、Struck算法发生漂移无法跟踪到目标,只有原ECO算法以及本文提出的算法能较为准确地定位到目标,并且在第94帧时,本文算法的精度较ECO算法更高。因此本文算法能在目标发生运动模糊和形变的情况下准确地跟踪目标。

5. 结论

本文在ECO算法的框架之上,针对单一的更新策略难以应对不同跟踪环境的目标跟踪问题,提出一种基于峰值旁瓣比的自适应策略更新机制。通过处理特征图响应值,获取跟踪目标的运动状态。根据目标运动状态的变化计算出恰当的更新间隔,提升滤波模板的准确性和鲁棒性。本文在OTB-100视频序列集上对本文算法性能进行评估,通过定量和定性分析,本文提出的算法在快速移动、运动模糊和目标相似的干扰情况下相较于原ECO算法有所提高。因此本文提出的算法相较于原ECO算法能更好地适应跟踪过程中出现的干扰,具有较高的精确度和鲁棒性。