1. 引言

目标跟踪已经成为智能监控系统和人体运动识别领域的关键技术之一 [1]。目标跟踪技术是在监控场景中完成对目标的检测的基础上,对目标进行有效准确地跟踪,为事件检测和行动识别提供支持 [2]。一般来说,目标跟踪包括以下几个步骤:目标检测、提取特征、建模、搜索目标、模型更新 [3]。目标跟踪的基本任务就是在目标检测的基础上,根据目标的初始位置来估计目标的后续状态进行跟踪。在近年来,目标跟踪技术已经取得了巨大进展,但是在跟踪过程中,存在遮挡、背景模糊等复杂情况影响跟踪结果,因此实现目标的有效、稳定跟踪依旧是一项极具挑战性的任务。

传统目标跟踪算法的研究主要集中于使用均值偏移 [4]、稀疏表示 [5]、粒子滤波 [6] 技术上,近年来目标跟踪算法已经逐渐转移到在相关滤波和深度学习的方向上发展。2010年提出了Mosse目标跟踪算法 [7],该算法奠定了基于相关滤波的目标跟踪算法的基础理论:通过训练滤波器模板和上一帧的采样模板得出输出响应,响应最大的位置即为这一帧的目标位置。由于基于相关滤波的跟踪算法在应对目标的光照、形态、尺度变化时都有较好的鲁棒性且能实现极快的跟踪速度,基于这样的滤波器的目标跟踪算法在接下来有了快速发展。CSK算法 [8] 则在此基础上改进了采样样本冗余问题,并加速了计算滤波器的过程。在此基础上,KCF算法 [9] 又对其进行了完善,并采用了HOG (Histogram of Oriented Gradients) [10] 特征,使得跟踪拥有更好的效果。此后DSST算法 [11] 又扩展了尺度跟踪,SRDCF [12] 算法和CFLB [13] 算法则是扩大了有效搜索区域,与此同时对滤波模板的边界加大惩罚,对滤波模板增加约束来增强跟踪器的鲁棒性。在CFLB的基础上,BACF (Background-Aware Correlation Filters) [14] 引入HOG特征,使得跟踪效果更好。虽然BACF算法通过对整个图像的剪裁进行采样,获得了高质量的样本,大大提高了跟踪精度,但是不能充分表达目标的视觉信息。同时,算法特征选取较为单一的HOG特征,对目标的视觉特征表征能力有限。除此之外,由于该算法对滤波器的更新没有很好地判别,当噪声过大时容易造成误差积累。

本文提出一种更加有效的基于背景感知相关滤波器的目标跟踪滤波器,融合了CN (Color Names)和HOG特征,结合了CN特征对变形鲁棒和HOG特征对光照鲁棒的特点,采用了多特征融合策略来改善BACF对视觉特征的表达不充分问题。同时采用DSST的尺度更新策略,位置和尺度通过两个模型分别更新,减少计算量。此外,本文引入一种新的置信度标准来处理遮挡问题。只有当置信度指标符合要求时,才更新滤波器模型,避免其在被遮挡的情况下被污染。

2. 背景感知相关滤波器

在视觉目标跟踪领域,基于相关滤波的跟踪方法在速度上表现出了比较优越的性能。相关滤波方法的最大优势在于能将时域相关转换成频率的乘积计算。但是,基于相关滤波的目标跟踪器一个根本缺点是目标的背景没有跟随滤波器不断建模,这可能导致跟踪效果的不鲁棒,也就是说理想的跟踪性能就达不到了。为了解决这种问题,一些算法提出了采用更具辨别能力的深度特征 [15] [16] 来解决,还有一些算法提出采用深度跟踪器来解决 [17] [18],虽然这些方法被证明效果很好,但它们提取深层特征或者应用深度跟踪框架的成本非常昂贵,这限制了的算法的实用性。为了解决这些问题,BACF算法通过对目标的前景和背景进行建模来减轻边际效应。基于背景感知的跟踪器可以建模前景和背景如何随时间变化,这显著增强了抑制背景的能力并避免模型漂移。

该算法在搜索区域扩大了滤波器H的大小,利用转置矩阵K缩小搜索区域的滤波器大小,得到与目标区域大小相对应的中值滤波器S,利用傅里叶变换矩阵F,使用滤波后搜索区域的输出和预期输出之间的最小平方误差值来获得背景感知滤波器的最优解。其表达式如下:

(1)

需要满足以下公式:

(2)

其中

为

的单位矩阵,

为目标的预期输出,Z为目标搜索区域的特征矩阵,

是正则项系数。T是搜索区域的特征矩阵的大小,D是目标区域的特征矩阵的大小(

),

表示核卷积。通过引入表达式S,计算偏差,就可以得到目标区域的滤波器S的表达式为:

(3)

其中,

表示复频率区域内的拉格朗日向量,

是惩罚系数。

利用Sherman-Morrison方法进一步降低了相关滤波器S的计算复杂度。表达式如下:

(4)

其中,

,

,

,

。

在相关滤波器H的搜索区域导出并更新拉格朗日向量的表达式:

(5)

最后模型更新策略还是跟传统CF一样的线性插值法:

(6)

其中,

为前一框架的目标模型,B为目标模型的学习率,

为本框架的目标,下标t为第t帧。

3. 本文改进的背景感知相关滤波器

3.1. 多特征融合

特征的选择对目标跟踪尤为重要,在传统的目标跟踪算法中,多采用单一特征,使得跟踪器性能在应对背景模糊、光照变化等复杂情况下不够鲁棒。HOG特征通过图像的局部方格单元上操作来获取梯度方向直方图,从而构成图像特征,所以它能很好地应对形变和光照变化,但是它对遮挡不够敏感,对运动模糊的鲁棒性较差 [10]。CN将3通道的RGB图像先投影到11个颜色通道,再归一化得到10个通道颜色特征,因此充分利用了目标的颜色特征,对于运动模糊和光强变化是鲁棒的,但是却很难适应背景相似的情况 [19]。

为了提高算法在复杂情况下的鲁棒性,提出了一种将HOG、CN特征自适应融合的算法。

由于在背景相似的情况下,单峰极易受到干扰,以滤波器响应的过程中的最高峰作为目标中心有可能发生跟踪器漂移的现象,因此本文利用平均峰相关能量APCE (Average Peak-to Correlation Energy) [20] 来进行权重分配。当目标跟踪良好时,目标滤波器响应为尖锐的单峰,此时的APCE值较大;当目标跟踪失败时,目标滤波器响应为波动的多峰,此时APCE值较小。

第t帧图像的权重值

计算如下:

(7)

其中

、

、

分别表示响应最高、最低和(w, l)位置上的响应。则第t帧的特征权重

公式如下:

(8)

其中ψHOG,t、ψCN,t分别表示HOG特征、CN特征的权重。EHOG,t、ECN,t表示第t帧时HOG、CN特征的平均峰相关能量。对这两个特征进行加权融合,得到融合后的响应最大值即为位置响应的目标位置y。

(9)

其中,yHOG、yCN分别代表HOG特征、CN特征响应。

表示初始权重。

采用这种特征融合的方式可以实现自适应特征融合,给特征响应不明显的特征赋予较低的特征权值,给特征响应明显的特征赋予较高的特征权值。

3.2. 尺度跟踪及高置信度更新策略

由于BACF算法将位置更新和尺度更新合并估计,通过不断计算不同尺度下的响应来更新模型,计算量较大,不能满足实时跟踪的需求,因此本文采用DSST的尺度更新策略,位置和尺度更新通过两个模型分别更新,减少计算量。为满足尺度变化剧烈情况,本文选用33个尺度。

在以往的跟踪器中大多都是在搜索区域中选取最大响应点来定位目标的,然而,实验表明最大响应点不能完美地代表目标响应点,例如当目标再次被相同物体遮挡时,最大响应点不会急剧下降,这将导致滤波器学习错误的目标。而且大多数的跟踪器不考虑检测结果是否精确,在每一帧结束都会对目标进行更新。实际上,当目标发生形变或被遮挡等复杂情况,当前帧检测有干扰时,分类器继续更新模型,就会得到大量的干扰信息,可能会导致后面大量帧的目标跟踪失败。

同时,目标跟踪算法中除了初始帧外,其他帧都包含一定的预测机制。因此,为了让跟踪模型在复杂条件下进行自适应更新,LMCF (平均峰值相关能量) [20] 提出多峰值检测这一个概念。如图1所示,在跟踪过程中,如果跟踪准确,则会出现一个尖锐的单峰波形,在有干扰的情况下会出现很多个起伏的波动峰形。图1(a)、图1(b)分别是OTB100数据集中的Jogging序列的第4帧和第76帧,图1(c)、图1(d)分别是图1(a)、图1(b)对应的滤波器峰值响应图。

通过峰值响应图可以看出,当没有遮挡情况且目标跟踪准确的时候,峰值响应图显示一个尖锐的主峰,周围较为平坦。而当目标出现遮挡情况时,则会出现波动的多峰现象,且遮挡越严重,次峰也会越明显,且离主峰的距离接近。此时跟踪器跟踪到的目标不一定是真实的目标,也就是说跟踪器已经发生了漂移,此时应该停止更新滤波器模型,因此,本文在改进算法中采用主次峰坡度比RPSPS [21] 作为更新指标:

(10)

其中,

,

表示响应最高峰峰值,即主峰值,

表示第二峰值,即次峰值,

表示响应最高峰的横纵坐标,

表示次高峰所在的横纵坐标。

当目标跟踪准确时,滤波器的峰值响应图呈现尖锐的单峰形状,除了主峰以外的响应面都较为平滑,此时的RPSPS值很大。而当出现遮挡时,滤波器的峰值响应图就会出现多峰,此时的响应最高峰和响应次高峰不仅高度接近,且距离也会相近,此时的RPSPS值就会很小,甚至趋近于0。

因此,本算法利用RPSPS作为跟踪结果的置信度指标,进行模型更新指令的决策。同时采用线性插值的方式来进行滤波器的更新,更新情况如下:

(11)

(12)

其中,

为前一框架的目标模型,B为目标模型的学习率,

为本框架的目标。

为判断是否需要更新的标志位,TUP为决策更新的阈值。

Figure 1. Jogging sequence tracking and response diagram

图1. Jogging序列跟踪及响应图

3.3. 本文算法流程图

本文提出的滤波器算法流程图如图2所示:

Figure 2. This paper filter algorithm flow chart

图2. 本文滤波器算法流程图

本文提出了一种抗遮挡的背景感知相关滤波器。在BACF滤波器的基础上进行改进,通过加入HOG特征和CN特征的自适应融合来提高滤波器对目标的识别性能;引入独立的尺度滤波器和位置滤波器同时进行跟踪,大大减少了计算量,提高了跟踪滤波器的实时性;最终通过主次峰坡度比来判断位置滤波器是否进行更新,减少更新次数的同时大大提高了目标跟踪的可靠性。

4. 实验

本文滤波器实验主要部署环境为Windows10系统的Matlab环境中,所有实验均搭载在CPU为AMD锐龙74800H、内存为16GB的PC上。本文算法的目标模型的学习率B为0.013,特征融合的初始权重ρ为0.7,惩罚系数μ设置为10,正则化系数λ设置为0.001,决策更新的阈值为0.452。本文的尺度估计采用与DSST算法一样的方式,选用更大的尺度池,单独训练一个尺度滤波器,本文选取的尺度数为33。

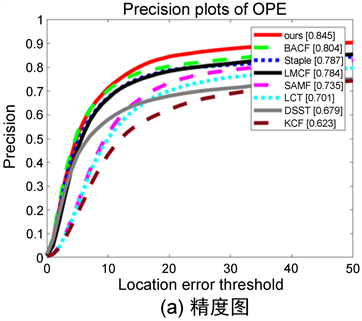

本节主要对本文提出的滤波器算法进行性能分析,并将本文滤波器与其他七个经典优秀滤波器:BACF、LCT [22]、DSST、KCF、LMCF、SAMF [23]、Staple [24] 进行对比分析。为了定性评估本文滤波器,本文采用了OTB100数据集中的100个视频序列对算法进行测试,这100个视频序列包含IV (Illumination Variation)光照变、SV (Scale Variation)尺度变化、OCC (Occlusion)遮挡、DEF (Deformation)变形、MB (Motion Blur)运动模糊、FM (Fast Motion)快速移动、IPR (In-Plane Rotation)平面内旋转、OPR (Out-of-Plane Rotation)平面外旋转、OV (Out-of-View)离开视野、BC (Background Clutters)相似背景、LR (Low Resolution)低分辨率这11个属性,基于一次性评估方法OPE (One-Pass Evaluation),运行这八个滤波器得到它们的平均精度图。运行结果如图3、表1和表2所示:

Figure 3. The accuracy and success rate curves of the proposed algorithm are compared with those of other 7 tracking algorithms on OTB100

图3. 本文算法与其他7种跟踪算法在OTB100上的精度图和成功率图曲线

图3八条不同的跟踪曲线代表了八个跟踪算法的跟踪性能和平均跟踪精度。其中精度图表示目标跟踪的平均中心位置精度,反映得是目标位置(bounding box)的中心点与人工标注(ground-truth)的目标的中心点的重叠程度。成功率图则代表了目标跟踪的平均重叠精度,反映得是目标位置(bounding box)的跟踪框与人工标注(ground-truth)的跟踪框的位置的重叠程度。实验结果显示了本文滤波器的平均中心位置精度(0.845)效果最优,在原BACF滤波器的中心位置精度(0.804)的基础上提高了5%。本文滤波器的平均重叠精度(0.772)同样优于其他七种跟踪滤波器,且在BACF的重叠精度(0.765)的基础上提高了0.9%。同时,本文滤波器的平均中心位置精度比LCT (0.701)高20.5%,比LMCF (0.784)高7.7%,比Staple (0.787)高7.3%,比SAMF (0.735)高14.9%,比KCF (0.623)高35.6%,比DSST (0.679)高33.2%。本文的平均重叠精度比LCT (0.647)高19.3%、比LMCF (0.713)高8.2%、比Staple (0.700)高10.2%、比SAMF (0.651)高18.5%、比KCF (0.623)高23.9%、比DSST (0.679)高13.6%。因此,本文提出的滤波器拥有更好的准确性。

Table 1. Eleven different attributes are representative of the center position accuracy and average accuracy of the eight filters

表1. 11种不同属性的代表性8个滤波器的中心位置精度和平均精度

Table 2. Eleven different attributes are representative of the overlap accuracy and average accuracy of eight filters

表2. 11种不同属性的代表性8个滤波器的重叠精度和平均精度

由表1和表2可知,在和七个经典跟踪算法在11个不同属性上精度的对比中,最优精度均加粗表示,可以看出本文滤波器在尺度位置变化、平面内外翻转、有遮挡、有相似背景、变形、运动模糊、快速移动、离开视野、低分辨率的属性中均有最优的中心位置精度,在尺度变化、平面外旋转、遮挡、相似背景、变形、运动模糊、离开视野、低分辨率的属性中均有最优重叠精度。因此,本文提出的滤波器具有更强的鲁棒性。其中,在11个属性中,本文滤波器在遮挡属性上对BACF滤波器有比其他10个属性更大的提升,在中心位置精度上提升了14.6%,在重叠精度上提升了8.9%。因此,本文提出的滤波器相比于原BACF滤波器具有较明显的抗遮挡性。

5. 总结

经过实验表明,和其他跟踪滤波器相比,本文滤波器在尺度位置变化、相似背景、低分辨率、遮挡等情况下都表现出了出色的准确性,其中,它尤其在抗遮挡性中表现出了良好的鲁棒性,验证了我们的滤波器在抗遮挡性能上的突出性。