摘要: 随着遥感技术的不断发展,遥感影像数据中包含的地物信息越来越丰富,因此被广泛应用于土地信息变化、灾害检测、环境评估等各个领域。建筑物作为主要的地表地物之一,同时是人类活动的主要场所,与人口和经济密切相关,被广泛应用于城市规划、智慧城市建设等各个方面。然而传统的建筑物提取方法耗时耗力,因此使用以卷积神经网络为基础的深度学习方法成为遥感图像处理的主流方法。本文在参考了国内外建筑物提取方法研究的文献后,采用Unet++的网络模型进行建筑物提取,并根据IoU、kappa系数以及F1这三个精度指标,评价其提取结果。

Abstract:

With the continuous development of remote sensing technology, the ground object information contained in remote sensing image data is more and more abundant, so it is widely used in various fields such as land information change, disaster detection, and environmental assessment. As one of the main surface features and the main place for human activities, buildings are closely related to population and economy, and are widely used in urban planning, smart city construction and other aspects. However, traditional building extraction methods are time-consuming and labor-intensive, so the use of deep learning methods based on convolutional neural networks has become the mainstream method for remote sensing image processing. In this paper, after referring to the literature on building extraction methods at home and abroad, the network model of Unet++ is used to extract buildings, and the extraction results are evaluated according to the three accuracy indicators of IoU, kappa coefficient and F1.

1. 引言

随着科学技术的不断进步,遥感影像的分辨率越来越高,能够提供的地物信息也越来越丰富。建筑物作为地球表面的主要地物之一,是人类活动的主要场所,与人口和经济密切相关,出现在我们生活的各个方面。建筑物的提取对城市建设规划、资源调查等方面有重要意义。因此通过遥感影像对建筑物的边缘轮廓进行自动、精准地提取是目前遥感信息提取的热点 [1]。传统的建筑物提取方法需要花费大量的人力、物力对建筑物进行轮廓勾勒,而且许多建筑物轮廓不规则,建筑物附近的绿化设施,树木会对房屋产生遮掩,这些问题对建筑物边缘轮廓的提取是一种巨大的挑战。

近几年来,随着深度学习的快速普及与发展,出现了许多以卷积神经网络为基础的网络模型 [2],在遥感影像的信息提取中提供了较为良好的成果,远远超过了传统的提取算法。Unet网络近年来在医学影像分割领域应用广泛,但在建筑物提取方面应用少、精度差,因此目前的研究大多是以改进的Unet网络进行地物提取 [3]。

如在Unet网络中,编码器和解码器分别加入通道注意力机制和空间注意力机制,以此提高模型分割的性能 [4]。Unet网络模型的关键在于将来自解码器的深层特征与来自编码器的浅层特征相结合,但是建筑物的特征信息容易在多次下采样和上采样过程中丢失。因此本文提出一种基于Unet++的卷积神经网络模型进行建筑物提取方法研究,并且与其他网络模型提取建筑物的结果与精度作比较和分析。

2. 研究方法

首先介绍Unet网络模型,Unet是基于编解码器语义分割算法,属于FCNN结构,其结构像一个U型结构,故此得名Unet网络 [5]。它的网络结构只包含卷积和池化操作,相对于现在的很多网络来说,Unet的层数较浅、参数较少,其在小样本的深度学习中有着良好的效果。

图像输入Unet之后首先经过两次卷积核为3 × 3、填充为1、步长为1、激活函数为ReLu的卷积操作。然后进行最大池化操作。然后在经过三次同样的两次卷积与下采样,得到的特征在经过两次相同的卷积操作。然后经过卷积核为2 × 2的上采样,同时与相应的编码阶段卷积特征进行拼接。拼接之后的特征图再次经过两次相同的卷积,再次重复三次同样的上采样与卷积操作。最后进行一次卷积核为1 × 1的卷积操作,输出预测结果。

Zhou [6] 等提出了一种基于嵌人的Unet的医学图像分割方法,该方法使用了Unet的优化网络Unet++,其编码解码器的子网络通过一系列嵌套且密集的跳跃路径连接,可以有效地减少编码解码器子网特征映射之间的语义差距,该方法比Unet方法具有更高的交并比(Interse < aion over Union, IoU)增益。

Unet++网络模结构型与Unet的类似,也是一个U型结构的网络模型 [7]。Unet++是将Unet的长跳跃连接变成了密集卷积块的短连接。

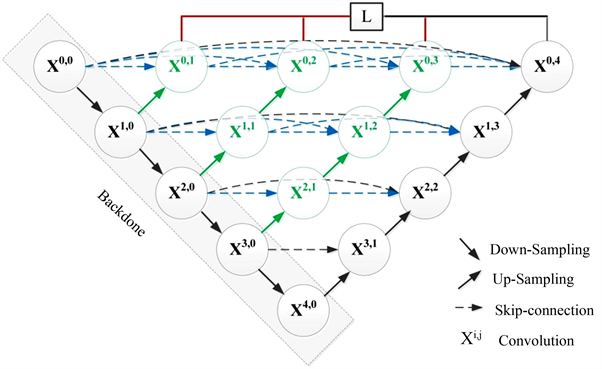

如图1所示,黑色的是Unet的结构,每个黑色的Xn,0都代表一个VGG卷积块。每个卷积块经过两次卷积,其中每次卷积采用3 × 3的卷积核、填充为1、步长为1,激活函数为ReLu。黑色向下的箭头代表2 × 2的最大池化,由图可知Unet++总共经过了四次下采样。

Figure 1. Unet++ network model structure

图1. Unet++网络模型结构

Unet++的水平层的每一点都有连接,能够抓取不同层次的特征,通过特征叠加整合在一起,其能结合浅层与深层特征,对小建筑物与大型建筑物都比较敏感,而不会像Unet网络模型因为不断下采样,丢失大型建筑物多边形的边缘信息与小型建筑物的信息,因此它比简单的Unet结构更为优秀。

3. 实验与分析

3.1. 实验数据集

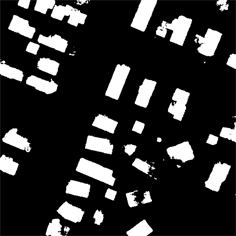

本文所使用的数据集为武汉大学季顺平团队构建的建筑物数据集WHU,该数据集由8188张不重叠的RGB图像组成,大小为512 × 512像素,空间分辨率为0.3 m。我们在实验中选取该训练集中的4736张图像为训练集与1036张图像为验证集。如图2所示,该航空图像较为清晰,大部分建筑物的形状规则,由提取图像可知,建筑物的轮廓能够较为准确的识别出来,但是也有部分建筑物被树木遮盖。

3.2. 实验环境

本次实验CPU型号为AMD Ryzen 5 5600H with Radeon Graphics 3.30 GHz,环境为Windows10。本次实验中,我们主要使用了Pytorch框架,并且初始化的网络模型的参数都是一致的。我们在训练阶段使用RMSProp作为优化器,使用的激活函数为ReLu [8]。

Figure 2. Comparison of the original image of the building and the extracted image

图2. 建筑原图与提取图像对比

3.3. 实验结果分析与精度评价

本文主要测试Unet++网络模型提取建筑物的能力,并以Unet,VGG这两个网络模型进行建筑物提取以作比较,三个模型的提取效果如图3所示。

(a) 原始图像

(a) 原始图像  (b) Unet++

(b) Unet++  (c) Unet

(c) Unet  (d) VGG

(d) VGG

Figure 3. The comparison between the original image and the extraction results of the three network models

图3. 原始图像与三个网络模型的提取效果图对比

为了判定算法的好坏,需要对训练模型的建筑物提取精度进行评价,本文采用IoU、kappa系数以及F1这三个常用的综合评价指标 [9] [10] [11],对三种模型的提取结果进行精度评价。

表1是Unet、Unet++与VGG模型对建筑物提取的定量结果。从表中我们可以看出Unet++模型的建筑物提取效果最佳、其次是VGG,而Unet提取结果最差。

Table 1. The accuracy evaluation of the extraction results of the three network models

表1. 三个网络模型提取结果的精度评价

其关键在于,Unet++的水平层的每一点都有连接,能够抓取不同层次的特征,通过特征叠加整合在一起 [12]。因为其能结合浅层与深层特征,对小建筑物与大型建筑物都比较敏感,而不会像Unet网络模型因为不断下采样,丢失大型建筑物多边形的边缘信息与小型建筑物的信息 [13],所以Unet++网络模型的建筑物提取结果是最佳的。

4. 结论

本文针对WHU数据集中的航空影像数据集,使用基于深度学习的方法提取建筑物信息。结果表明:Unet++的提取效果在进行比较的三种网络结构中是最佳的,它提取影像的kappa系数可达0.9324,IoU值达到0.8702,F1值为0.9206,实现了对建筑物的高精度提取,对复杂情况下的高分辨率遥感影像地物提取方法研究具有一定的参考价值,但是关于建筑物边缘轮廓以及与周围的阴影区分的细节上,还要思考其他方法进行完善。