1. 引言

茶叶作为一种重要的经济作物,在当前精准扶贫形势下是茶农脱贫的重要产业 [1]。然而,茶树在生长过程中容易产生病害,导致茶叶产量和质量下降,给茶农造成严重的经济损失。因此,能准确识别茶叶病害,并及时采取相应防护措施,对减少茶叶产量损失和提高茶叶品质具有重要意义。

传统的植物病害鉴定主要依靠人工识别,易受主观性影响。随着计算机技术的发展,图像处理和机器学习方法已广泛应用于植物病害识别 [2] [3]。孙瑜 [4] 等人使用粒子群算法优化支持向量机(SVM),对黄花菜叶部病害识别精度为81.67%。杨涛 [5] 等人利用K-means聚类对麦冬叶部病斑做分割处理,利用SVM对提取后的病害特征进行识别,识别精度为93.30%。黄太远 [6] 等人对茶叶病害进行特征提取后通过SVM进行分类,识别精度为93.75%。传统的机器学习方法在识别植物病害时必须预先提取病害特征,由于病斑大小不一,且具有复杂的纹理和颜色特征,人工提取的特征可能无法反映植物病害的基本属性。上述方法对植物病害的识别率较低。

深度学习方法不需要人工提取特征,目前已在目标识别和其他领域得到了广泛的应用 [7] [8]。徐岩 [9] 等人在ResNet50基础上融合通道注意力和空间注意力,对马铃薯病害识别精度为93.86%。鲍文霞 [10] 等人基于VGG16网络,引入迁移学习和SK模块,对苹果病害识别精度为94.70%。黄林生 [11] 等人在ResNet网络中引入SE注意力和Inception模块,对农作物病害识别精度为95.62%。上述研究虽然均取得较好的效果,但网络参数较大,不利于实现病害识别的移动端部署。本文基于自然环境下的3种茶叶病害和健康叶制作茶叶病害数据集,在MobileNet V2 [12] 中嵌入坐标注意力(Coordinate Attention,简称CA) [13] ,通过赋予目标区域高权重以增强网络对茶叶病害的特征提取能力,在达到高识别率的同时不增加网络参数。引入焦点损失(Focal Loss)函数 [14] 解决茶叶病害图像数量不均衡的现象,使网络训练过程中聚焦于难分类样本,提高网络识别性能。

2. 图像采集与预处理

2.1. 图像采集

实验中使用的图像数据均采于南京雨花台风景区和贵阳羊艾茶园,共采集图像1900张,其中茶藻斑病414张、茶轮斑病503张、茶云纹叶枯病371张以及正常叶612张,部分样本图像如图1所示。

(a) 茶藻斑病(b) 茶轮斑病(c) 茶云纹叶枯病(d) 正常叶

(a) 茶藻斑病(b) 茶轮斑病(c) 茶云纹叶枯病(d) 正常叶

Figure 1. Tea diseased leaf diagram and normal leaf diagram

图1. 茶叶病害叶片图与正常叶片图

2.2. 图像预处理

深度学习依赖于大量数据集,为避免出现模型训练过拟合现象,本实验对已采集茶叶病害图像进行数据增强操作。通过随机旋转、调整亮度、调整对比度、添加椒盐噪声等方法对病害图像进行扩充,图像数据增强情况如表1所示。对数据增强后共7150张图像。采集的原始图像尺寸为2736 × 3648,由于本模型要求输入固定维度,图像中像素过多会导致冗余信息增加,因此本试验将图像尺寸统一为224 × 224像素,按7:3的比例随机划分训练集和验证集。

Table 1. Sample status after data enhancement

表1. 数据增强后样本情况

3. 基于MobileNet V2的茶叶病害识别模型

3.1. MobileNet V2

MobileNet V2是2019年提出的一种轻量级网络,沿用了MobileNet V1中提出的深度可分离卷积,并引入倒置残差(Inverted residuals)结构进行改进,以提高网络性能。MobileNet V2整体网络结构如图2所示,主要由一个卷积核大小为3 × 3的卷积层、17个含有倒置残差结构的瓶颈层(Bottleneck)以及一层7 × 7大小的平均池化层(Avgpool)构成。

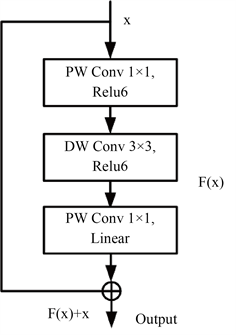

残差结构有助于解决网络梯度消失和梯度爆炸现象,使网络更深的同时又能保证良好的性能。传统残差结构对特征通道维度先压缩后扩展,而倒置残差结构首先通过1 × 1逐点卷积(Pointwise Convolution,PWConv)对输入特征维度进行压缩,其次送入深度卷积(Depthwise Convolution, DWConv)提取各通道的特征,最后使用1 × 1逐点卷积对特征维度进行压缩,避免了传统残差结构先压缩特征维度,导致上层输入通道过少,网络仅对空间中低维特提取效果较好的现象。另外为防止高维特征压缩至低维时出现特征信息丢失,MobileNet V2将倒置残差结构中降维卷积后的非线性激活函数ReLU6换为线性函数(Linear)输出,从而保留了特征信息的多样性,增强了网络的特征提取能力。MobileNet V2的倒置残差结构如图3所示。

Figure 2. Structure of MobileNet V2 network

图2. MobileNet V2网络结构

Figure 3. Structure of inverted residuals

图3. 倒置残差结构

3.2. 坐标注意力机制

注意力机制通过将网络注意力聚焦于目标区域,减少无关信息的干扰,提高视觉信息处理的性能。茶叶病害图像中含有丰富的目标与背景信息,传统神经网络很难区分两者间的差异,通过引入坐标注意力机制提高网络对茶叶病斑特征的敏感程度,从注意力的分配方面改善网络性能,坐标注意力机制结构如图4所示。

坐标注意力机制分为两部分,第一部分为坐标信息嵌入:将位置信息嵌入通道注意力,对输入特征分别进行水平和垂直方向上的平均池化,得到尺寸为C × H × 1和C × 1 × W的输出特征图,H和W分别为输入特征图的高和宽, 为通道数。每个特征图都包括输入特征图沿着一个空间方向的远距离依存关系,并保存沿着另一个空间方向的精确位置信息,使网络能更准确地定位目标区域。

第二部分为坐标注意力生成:首先,将第一部分的两幅输出特征图通过Concat操作拼接为C × 1 × (H + W)的特征图。其次,将特征图送入1 × 1卷积层,通道维度从C维降低为原来的C/r,经过归一化处理和非线性激活后,对获得的结果沿空间维度切分为两个张量,尺寸分别为C/r × H × 1和C/r × 1 × W。最后,通过两个1 × 1卷积层将特征图通道维度升至 维,利用Sigmod函数进行非线性激活。

最后通过乘法加权计算融合空间信息与通道特征,完成坐标注意力的施加。

Figure 4. Structure of Coordinate Attention

图4. 坐标注意力结构

引入坐标注意力的MobileNet V2倒置残差结构如图5所示,通过在倒置残差结构模块中最后一层逐点卷积后嵌入坐标注意力机制,使网络更关注目标区域,有效区分目标与背景,提高网络对病害的分类效果。

Figure 5. Inverted residuals of the embedded coordinate attention

图5. 嵌入坐标注意力的倒置残差结构

3.3. 损失函数

交叉熵损失(CrossEntropy loss)常出现于分类问题,为网络训练常用的损失函数,公式为:

(1)

式中,

为类别t的预测概率。由于交叉熵损失函数对所有样本损失的权值是相同的,而本文实验使用的茶叶病害数据集存在类别样本不均衡的现象,导致网络训练结果不佳,因此本文实验利用焦点损失函数替换交叉熵损失函数。焦点损失是由交叉熵损失改进得到,通过在交叉熵损失函数中引入γ和α两个参数重新分配样本权重,参数α用于解决正负样本不均衡的问题,参数γ用于解决难易样本不均衡的问题,使网络在训练时更关注难分类的样本,焦点损失函数公式为:

(2)

式中,

为类别t的预测概率,γ和α为超参数,如果γ = 0,则

等价于

。

4. 实验结果与分析

4.1. 实验环境

实验环境主要配置如表2所示。

Table 2. Experimental environment configuration

表2. 实验环境配置

4.2. 实验结果分析

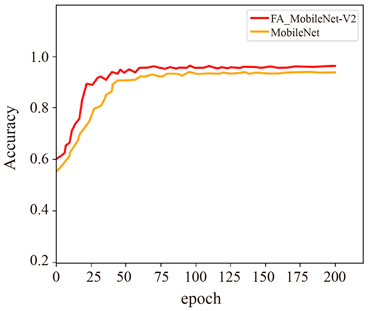

本文实验使用尺寸为224 × 224像素大小图像分别对MobileNteV2原网络和改进后的网络FA_MobileNet进行训练和验证,学习率和batch_size分别设置为0.001和16,使用Adam优化器,200次迭代后两种网络验证集准确率和损失值变化曲线如图6所示,可以明显看出改进后的网络在验证集上识别率高于MobileNteV2,收敛快的同时损失值更低,验证了改进后网络的有效性。

为验证本文改进方法的有效性,在MobileNet V2中使用不同改进策略组合,实验结果如表3所示。可以看出,在MobileNet V2网络中分别引入坐标注意力机制和焦点损失函数后对茶叶病害数据集的识别准确率较原始网络均有所提升,分别提升了1.55%和0.96%。融合两种改进策略的FA_MobileNet网络性能优于单独使用一种策略的网络性能,对茶叶病害的识别准确率提高了2.39%,网络参数量仅增加0.04MB。验证了嵌入坐标注意力和焦点损失函数对网络性能提升的有效性。

从网络竞争力角度出发,本文实验选取AlaxNet [15]、VGG16 [16] 和GoogLeNet [17] 这三种卷积神经网络与FA_MobileNet网络进行对比试验,不同网络比较结果如表4所示。可以明显看出FA_MobileNet网络对茶叶病害的识别效果最好,识别率达96.31%,较AlaxNet、VGG16和GoogLeNet分别高出8.66、3.67和2.16个百分点,网络参数量仅为2.27 MB。实验表明,FA_MobileNet网络相较于其他网络具有更好的竞争优势,能够满足移动端对复杂背景下茶叶病害识别的要求。

(a)

(a)  (b)

(b)

Figure 6. Variation curve of network validation accuracy and loss. (a) Variation curve of the accuracy; (b) Variation curve of loss

图6. 网络验证集准确率和损失值变化曲线。(a) 准确率变化曲线;(b) 损失值变化曲线

注:-表示未使用该方法,√表示使用该方法。

Table 4. Comparison of different network performance

表4. 不同网络性能比较

5. 结论

本文针对复杂背景下茶叶病害识别困难的问题,提出一种轻量级茶叶病害识别网络。在MobileNet V2网络中引入坐标注意力,同时考虑通道关系和位置信息,达到减少背景信息干扰的效果并使网络更准确定位至目标区域。利用焦点损失函数替换交叉熵损失函数,有效解决茶叶病害样本不均衡的问题,提高网络识别性能。与其他网络进行对比,实验表明本文改进后的网络具有识别率高,网络参数量小的优势,识别率和参数量分别为96.31%和2.27 MB,具有较强的实用性。

参考文献