1. 引言

在日常生活中,人类使用来自各种感官的信息(如视觉信息、听觉信息、嗅觉信息和触觉信息)来感知外部世界。其中,以视觉信息和听觉信息最为重要。将视觉和听觉通道的信息有效地融合为统一、连贯的知觉过程,被称为视听觉整合(Talsma et al., 2010a)。大量研究证明,与单一感觉通道视觉或听觉信息相比,当视觉和听觉信息同时出现时,人们反应得更快更准确,即产生了冗余效应(Lunn et al., 2019)。要成功地与周围环境中的刺激进行交互,我们需要有选择地处理与所面临的情境相关的信息,这个过程通常被称为注意(James, 1950)。Talsm等人的系列研究已经证实,注意可以在视听觉整合的多个阶段发挥重要的调节作用(Durk et al., 2007; Talsma et al., 2009, 2010b; Talsma & Woldorff, 2005)。

根据知觉负载理论(The Perceptual Load Theory),知觉加工的资源是有限的,如果一项任务的认知资源需求高,用于处理其他任务的注意资源就会变少(Lavie, 1995; Lavie & Tsal, 1994)。Alsius等人首次通过单任务和双任务范式(Dual Tasks)研究了注意负荷对视听觉整合的影响,被试需要在进行视听判断任务(McGurk任务)的同时进行一项无关的视觉或听觉任务,行为学和ERP的结果都表明在高注意负荷下视听觉整合效应降低(Alsius et al., 2005)。在进一步的研究中,研究者消除了认知言语加工占用认知资源的影响,运用了快速序列视觉呈现范式(Rapid Serial Visual Presentation, RSVP)呈现无语义视听觉刺激来操纵注意负荷,得到的结果与Alsius等人的研究结果类似(Ren et al., 2020)。另外,Alsius等人(Alsius et al., 2005, 2014)和Ren (Ren et al., 2020)等人的研究都涉及到了刺激属性的辨别,说明听觉注意和视觉注意在一定程度上是不同的。近年来,有研究者探讨了视觉、听觉注意负荷是否会对视听觉整合产生不同影响,同时划分了负荷水平,结果表明低视觉负荷下发生视听觉整合效应,高视觉负荷下未发生视听觉整合效应;随着听觉负荷的增加,视听觉整合效应会降低直至消失(毕浚皓,李君缘,平航,2021;毕浚皓,李君缘,平航,刘铸汉,2021)。显然,已有研究多是从单个注意焦点、静态视听觉负荷的角度进行的,但是日常生活中的许多场景需要持续性注意,比如人们在阅读、驾驶时,而目前缺少持续性注意负荷对视听觉整合产生的影响相关研究。

前人运用了RSVP范式操纵了听觉刺激的数量,来考察持续性听觉注意负荷对视听觉整合的影响,结果发现随着持续性听觉注意负荷的增加,视听觉整合效会减弱和延迟(Ren et al., 2021)。Wahn和König研究了持续性视觉注意负荷对视听觉整合的影响,结果表明在低、高持续性视觉负荷条件下视听觉整合效应类似,这说明持续性视觉注意负荷并未影响视听觉整合(Basil & Peter, 2015)。具体来看,Wahn和König让被试在完成视听觉定位(Localization, LOC)任务的同时,完成多目标追踪任务(Multiple Object Tracking, MOT)。

根据注意选择的视觉信息类型,可将注意划分为:基于客体(Object-based)的注意(Chen, 2012; Duncan, 1984)和基于空间(Space-based)的注意(Posner, 1980)。基于客体注意的选择对象是由多种特征或分布在多个空间位置的特征绑定而成的视觉客体,这些特征可获得时间上的平行加工(Duncan, 1984)。上述大量研究中运用了基于客体的注意(Alsius et al., 2005; Ren et al., 2020)。基于空间的注意选择某一空间位置作为注意焦点,加工焦点内的信息并抑制非焦点信息,它可以将注意从某一位置引导至另一位置(Theeuwes et al., 2011)。显然,Wahn和König的研究中两个任务都基于空间注意。另外,人类在空间分辨任务中更依赖视觉信息。那么,若运用基于客体注意的任务来监测视听觉整合效应,采用基于空间注意的任务来操纵持续性视觉注意负荷的程度,此种双任务又会对视听觉整合会产生何种影响呢?

综上所述,本研究将利用多目标追踪(Multiple Object Tracking, MOT)范式(Pylyshyn & Storm, 1988)——基于空间注意的任务来操纵持续性视觉注意负荷类型(无负荷、低负荷、高负荷),另外采用Go/No-go范式——基于客体注意的视听辨别任务来控制刺激类型(视觉、听觉、视听觉),从而来探讨持续性视觉注意负荷对视听觉整合的影响。基于前人研究结果,本研究预期,在三种不同(无负荷、低负荷、高负荷)持续性视觉注意负荷下,都将发生视听觉整合,随着负荷的增加,视听觉整合效应会逐渐减小。

2. 方法

2.1. 被试

实验最终招募十名被试(男性5名,女性5名)参与实验,年龄范围在18~21岁,平均年龄20.3 ± 1.8岁。所有参与者均为贵州中医药大学本科生,听力正常,视力或矫正视力正常,均为右利手,未患有精神疾病,无脑部损伤史。被试在实验结束后获得一定酬劳。

2.2. 实验装置和材料

本实验程序的编写和数据的采集均采用PsychoPy。刺激呈现在Dell SE2719HR型号的液晶显示器上,可视尺寸27英寸,分辨率为1920 × 1080像素,刷新率为60 Hz。实验在黑暗、隔音的环境下进行,屏幕背景为灰色。被试眼睛距离屏幕中心约60 cm。

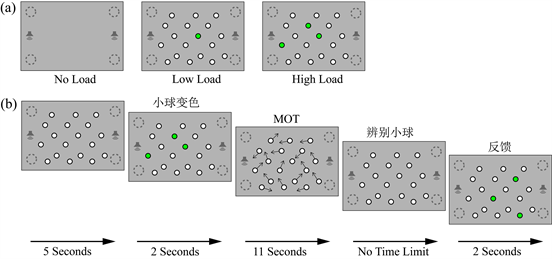

实验刺激如图1所示。如图1(a)所示,多目标追踪任务的材料为18个白色粒子;视听辨别任务中刺激共有6种呈现形式,视觉刺激如图1(b)所示,有视觉目标刺激(VT)和视觉标准刺激(VS);听觉目标刺激(AT)为60 dB的白噪音,听觉标准刺激(AS)为60 dB的1000 Hz正弦音;视听觉目标刺激(VAT)为视觉目标刺激和听觉目标刺激组合而成,视听觉标准刺激(VAS)为视觉标准刺激和听觉标准刺激组合而成。

2.3. 实验设计和程序

实验采用3 (持续性视觉注意负荷:无负荷、低负荷、高负荷) × 3 (刺激类型:听觉刺激、视觉刺激、视听觉刺激)的被试内实验设计。目标刺激和标准刺激的比例为1:4,同一负荷下实验共有300个试次。

2.3.1. 有持续性视觉注意负荷的情况

实验程序如图2(b)所示。每次测试开始时在屏幕中心呈现18个白色粒子,该刺激呈现5 s后,有1个(低负荷)或者3个(高负荷)靶粒子(图2(a))暂时变为绿色并在2 s后恢复白色,接着18个粒子无规则运动11 s后静止,要求被试在粒子静止后通过鼠标点击选出最初变为绿色的靶粒子,被试判断完毕后系统反馈出正确的靶粒子。在18个粒子无规则运动的11 s期间,视/听辨别任务中听觉刺激、视觉刺激、视听觉刺激在MOT任务显示区域外围的左上、左下、右上、右下灰色圆圈内随机出现,要求被试对VT、AT、VAT做出快而准的判断。

2.3.2. 无持续性视觉注意负荷的情况

如图2(a)中No Load所示,测试开始后,仅有视/听辨别任务出现在显示器上,要求被试对VT、AT、VAT做出快而准的判断。

Figure 2. (a) Different load conditions; (b) The paradigm of the experiment

图2. 实验负荷示意图 (a)和实验流程示意图 (b)

2.4. 数据分析

在每种条件下,分别计算每个被试的击中率和反应时。根据不同的负荷对每个被试的反应时和SD进行重组并取平均值。随后,使用SPSS 26.0软件,对目标刺激的反应时和正确率进行Friedman检验。另外,对每个受试者的数据建立独立的竞争模型(Miller, 1986)。独立竞争模型是基于对单独视觉和听觉刺激的视觉和听觉反应的概率之和的统计预测模型。并将视听觉整合模型与基于个体视觉和听觉的综合概率模型进行比较。

3. 结果

3.1. 击中率

比较无负荷、低负荷、高负荷条件下的三种目标刺激的击中率,采用Friedman检验。结果如表1所示:在无负荷条件下,视觉目标刺激的击中率(92.0%)、听觉目标刺激的击中率(91.5%)和视听觉目标刺激的击中率(94.5%)的差异无统计学意义(P = 0.707);在低负荷条件下,视觉目标刺激的击中率(90.3%)、听觉目标刺激的击中率(87.1%)和视听觉目标刺激的击中率(94.9%)的差异无统计学意义(P = 0.097);在高负荷条件下,视觉目标刺激的击中率(91.5%)、听觉目标刺激的击中率(96.3%)和视听觉目标刺激的击中率(97.4%)的差异有统计学意义(c2 = 6.320, df = 2, P < 0.05),采用Bonferroni法校正显著性水平的事后两两比较发现,目标刺激的击中率两两之间无统计学意义(视觉–听觉:P = 0.438;视觉–视听觉:P = 0.172;听觉–视听觉:P = 1.000)。

将视觉目标刺激、听觉目标刺激、视听觉目标刺激分别在三种负荷条件下的击中率进行比较,采用Friedman检验。结果如表1所示:视觉目标刺激在无负荷条件下的击中率(92.0%)、在低负荷条件下的击中率(90.3%)和在高负荷条件下的击中率(91.5%)的差异无统计学意义(P = 0.345)。听觉目标刺激在无负荷条件下的击中率(91.5%)、在低负荷条件下的击中率(87.1%)和在高负荷条件下的击中率(96.3%)的差异有统计学意义(c2 = 8.486, df = 2, P < 0.05);采用Bonferroni法校正显著性水平的事后两两比较发现,无负荷条件下听觉目标刺激的击中率(91.5%)略大于低负荷条件下的击中率(87.1%),两者间差异无统计学意义(P = 0.353),无负荷条件下听觉目标刺激的击中率(91.5%)略小于高负荷条件下的击中率(96.3%),两者间差异无统计学意义(P = 0.656),低负荷条件下听觉目标刺激的击中率(87.1%)显著小于高负荷条件下的击中率(96.3%,P < 0.05)。视听觉刺激在无负荷条件下的击中率(94.5%)、在低负荷条件下的击中率(94.9%)和在高负荷条件下的击中率(97.4%)的差异无统计学意义(P = 0.435)。

Table 1. Response time (RT/ms), hit rate (%) and standard deviation (SD) under different load condition in audio-visual discrimination task

表1. 视听辨别任务中不同负荷条件下的反应时(RT/ms)、击中率(Hit Rate/%)及其标准差(SD)

3.2. 反应时

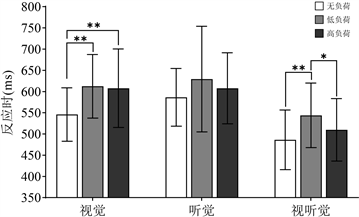

比较无负荷、低负荷、高负荷条件下的三种目标刺激的反应时,采用Friedman检验。结果如表1和图3所示:无负荷条件下,视觉目标刺激的反应时(546 ms)、听觉目标刺激的反应时(586 ms)和视听觉目标刺激的反应时(486 ms)的差异有统计学意义(c2 = 14.600, df = 2, P < 0.01);采用Bonferroni法校正显著性水平的事后两两比较发现,视觉目标刺激的反应时(546 ms)略快于听觉目标刺激的反应时(586 ms),两者间差异无统计学意义(P = 0.353),视觉目标刺激的反应时(546 ms)略慢于视听觉目标刺激的反应时(486 ms),两者间差异无统计学意义(P = 0.076),听觉目标刺激的反应时(586 ms)显著慢于视听觉目标刺激的反应时(486 ms, P < 0.001)。低负荷条件下,视觉目标刺激的反应时(612 ms)、听觉目标刺激的反应时(630 ms)和视听觉目标刺激的反应时(544 ms)的差异有统计学意义(c2 = 12.200, df = 2, P < 0.01);采用Bonferroni法校正显著性水平的事后两两比较发现,视觉目标刺激的反应时(612 ms)略快于听觉目标刺激的反应时(630 ms),两者间差异无统计学意义(P = 1.000),视觉目标刺激的反应时(612 ms)显著慢于视听觉目标刺激的反应时(544 ms, P < 0.01),听觉目标刺激的反应时(630 ms)显著慢于视听觉目标刺激的反应时(544 ms, P < 0.05)。高负荷条件下,视觉目标刺激的反应时(608 ms)、听觉目标刺激的反应时(608 ms)和视听觉目标刺激的反应时(510 ms)的差异有统计学意义(c2 = 15.800, df = 2, P < 0.001);采用Bonferroni法校正显著性水平的事后两两比较发现,视觉目标刺激的反应时(608 ms)与听觉目标刺激的反应时(608 ms)无显著差异(P = 1.000),视觉目标刺激的反应时(608 ms)显著慢于视听觉目标刺激的反应时(510 ms, P < 0.05),听觉目标刺激的反应时(608 ms)显著慢于视听觉目标刺激的反应时(510 ms, P < 0.001)。

将视觉目标刺激、听觉目标刺激、视听觉目标刺激分别在三种负荷条件下的反应时进行比较,采用Friedman检验。结果如表1和图3所示:视觉目标刺激在无负荷条件下的反应时(546 ms)、在低负荷条件下的反应时(612 ms)和在高负荷条件下的反应时(608 ms)的差异有统计学意义(c2 = 15.200, df = 2, P < 0.01);采用Bonferroni法校正显著性水平的事后两两比较发现,无负荷条件下视觉目标刺激的反应时(546 ms)显著快于低负荷条件下的反应时(612 ms, P < 0.01),无负荷条件下视觉目标刺激的反应时(546 ms)显著快于高负荷条件下的反应时(608 ms, P < 0.01),高负荷条件下视觉目标刺激的反应时(608 ms)略快于低负荷条件下的反应时(612 ms),两者间差异无统计学意义(P = 1.000)。听觉目标刺激在无负荷条件下的反应时(586 ms)、在低负荷条件下的反应时(630 ms)和在高负荷条件下的反应时(608 ms)的差异无统计学意义(P = 0.905)。视听觉目标刺激在无负荷条件下的反应时(486 ms)、在低负荷条件下的反应时(544 ms)和在高负荷条件下的反应时(510 ms)的差异有统计学意义(c2 = 12.600, df = 2, P < 0.01);采用Bonferroni法校正显著性水平的事后两两比较发现,无负荷条件下视听觉目标刺激的反应时(486 ms)显著快于低负荷条件下的反应时(544 ms, P < 0.01),无负荷条件下视听觉目标刺激的反应时(486 ms)略快于高负荷条件下的反应时(510 ms),两者间差异无统计学意义(P = 1.000),高负荷条件下视听觉目标刺激的反应时(510 ms)显著快于低负荷条件下的反应时(544 ms, P < 0.05)。

Figure 3. Response Time (RT) under different load conditions

图3. 不同负荷下的反应时

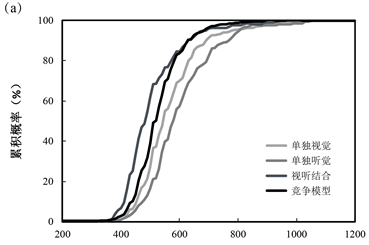

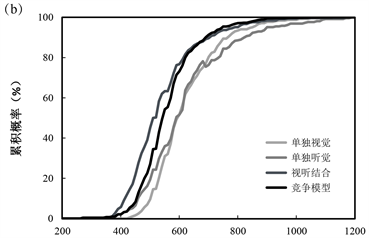

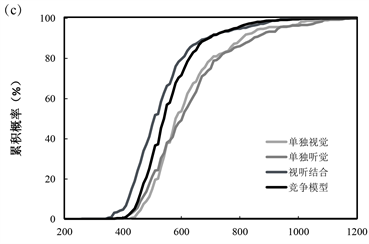

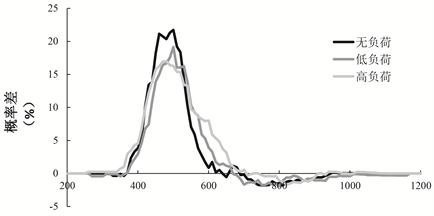

3.3. 竞争模型(Race Model)分析

首先,在200~1200 ms的反应时间范围内,计算出以10 ms周期不同持续性视觉注意负荷条件下的概率值。不同持续性视觉注意负荷下实际单独视觉、单独听觉、视听觉结合累计概率和竞争模型(Race Model)累计分布概率如图4所示。其次,将不同持续性视觉注意负荷下实际视听觉结合的累计概率与竞争模型(Race Model)累计分布概率的累计差异概率值相减,在每10 ms上进行单样本t检验(与0进行比较)。结果如图5所示,在无负荷条件下,显著违反竞争模型(显著大于0)的时间窗口为380~580 ms,P < 0.001,峰值在450 ms,为26.3%;在低负荷条件下,显著违反竞争模型(显著大于0)的时间窗口为360~580 ms,P < 0.05,峰值在500 ms,为17.9%;在高负荷条件下,显著违反竞争模型(显著大于0)的时间窗口为370~600 ms,P < 0.001,峰值在450 ms,为21.5%。说明在三种条件下,都发生了视听觉整合。另外,无持续性视觉注意负荷和高持续性视觉注意负荷两种条件下的整合窗口,发生的时间和峰值相似,说明在无、高持续性视觉注意负荷两种条件下的视听觉整合没有显著差异;而低持续性视觉注意负荷条件下的峰值显著小于无、高注意负荷两种条件下的,说明低持续性视觉注意负荷下的视听觉整合效应减弱。

Figure 4. Race model under each sustained visual load. (a) No load; (b) Low load; (c) High load

图4. 不同负荷下的竞争模型。(a) 无负荷;(b) 低负荷;(c) 高负荷

Figure 5. Direct comparison of bimodal and race model

图5. 视听觉结合模型与预测竞争模型的直接比较

4. 讨论

本研究采用Go/No-go范式,结合多目标追踪(Multiple Object Tracking, MOT)范式(Pylyshyn & Storm, 1988),由多目标追踪范式操纵持续性视觉注意负荷类型(无负荷、低负荷、高负荷),来考察不同程度的持续性视觉注意负荷对视听觉整合的影响。结果发现,低持续性视觉注意负荷下的视听觉整合效应显著小于无持续性视觉注意负荷和高持续性视觉注意负荷下的视听觉整合效应;无持续性视觉注意负荷和高持续性视觉注意负荷下的视听觉整合无显著差异。表明不同程度的持续性视觉注意负荷会对视听觉整合产生不同影响。

在反应时结果上,在不同负荷条件下均发现双通道目标的反应时显著快于单通道目标,即产生冗余信号效应,体现了双通道的加工优势,与以往研究结果一致(Lunn et al., 2019; McCracken et al., 2019; Tang et al., 2019)。基于Race Model结果,研究发现无持续性视觉注意负荷下要比低持续性视觉注意负荷下违反竞争模型的峰值更大,即低持续性视觉注意负荷会减弱视听觉整合效应。根据知觉负载理论(The Perceptual Load Theory),注意资源是有限的,如果一项任务占用了大部分注意资源,那么用于处理其他任务的注意资源就会变少。在实验中,由于完成多目标追踪任务(MOT)需要更多的注意资源,被试只能利用较少的注意资源完成视听辨别任务。Talsma等人针对注意和视听觉整合之间的相互作用进行过一系列研究,发现相较于没有注意到刺激的情况,注意到刺激的情况下视听觉整合效应会增强(Durk et al., 2007; Talsma et al., 2009, 2010b; Talsma & Woldorff, 2005)。因此,视听觉整合在低持续性视觉注意负荷下降低,可能主要是由于在视听辨别任务中可用于处理听觉和视觉信息的注意资源的减少。

然而,不同于以往研究,本研究中无持续性视觉注意负荷和高持续性视觉注意负荷下的视听觉整合效应类似,且都大于低持续性视觉注意负荷下的视听觉整合,虽然多目标追踪任务中对注意容量的考察可以利用追踪数量的变化进行直接量化操作(魏柳青等,2010),但本研究缺少对多目标追踪任务正确率的考察,因此无法得知被试在实验中是否一直在进行多目标追踪,即无法确定被试是否在持续性高注意负荷下进行的视听辨别任务。同时,本研究结果不同于Wahn和König得出的低、高持续性视觉负荷下视听觉整合效应类似的结论,说明完成基于空间注意的任务和基于客体注意的任务时存在差异,未来可以结合脑成像等技术进一步探讨。

此外,值得注意的是,简单效应分析的结果显示,在视觉目标刺激上,无负荷条件下的反应时显著快于低、高负荷下的反应时;听觉目标刺激上,三种不同注意负荷条件下的反应时均未出现显著差异。大量研究表明,对一种感觉通道的信息的加工不受来自另一通道的信息的影响,但会影响同一感觉通道内其他信息的加工,即注意是单通道的(Alais et al., 2006; Bonnel & Hafter, 1998; Larsen et al., 2003)。因此,本研究中视觉负荷的增加并未影响被试对听觉目标刺激的反应,原因可能是视听觉利用的是独立的注意资源。所以未来研究可以结合持续性视觉和持续性听觉注意负荷,探讨双重负荷对视听觉整合的影响。

本研究完善了前人对于持续性注意负荷对视听觉整合影响的研究,发现低持续性视觉注意负荷会减弱视听觉整合效应,而高持续性视觉注意负荷并未对视听觉整合产生显著影响;同时,本研究中并未对多目标追踪任务(MOT)的正确率进行监测,另外中等程度的持续性注意负荷并未考察,未来可以进一步优化。

基金项目

2021年贵州省大学生创新创业训练项目(202110662043)。