1. 引言

多目标跟踪要求定位并识别视频中不同的目标 [1] [2],作为计算机视觉的一个重要研究课题,它为多种实际应用提供了关键的核心技术支持,包括视频分析 [3]、自动驾驶 [4]、机器人 [5] 等。目前,多目标跟踪主要依靠目标检测技术进行定位,然后根据运动预测和重识别特征关联不同帧中的目标形成轨迹。相比于只依靠运动预测进行关联,使用重识别特征能够获得更强的抗遮挡能力,因为它可以识别出被遮挡后重新出现的目标。因此,为被跟踪的目标提取良好的重识别特征是近年来的一个热点研究方向。基于检测的跟踪模型(Detection-based-Tracking Models, DBT) [6] [7] 使用一个离线训练的目标重识别网络提取图像帧中检测切片的重识别特征,但这类方法会导致模型的复杂度显著升高,并且跟踪速度随着目标的数量增多而明显下降。

为了兼顾跟踪算法的关联性能和实时性,Wang等人 [8] 首先构建了联合检测和重识别的跟踪模型(Joint-Detection-and-Embedding Models, JDE),在检测算法上加入一个分支用来学习重识别特征,极大地降低了提取重识别特征的复杂度。随后Zhang等人 [9] 针对锚不适合重识别特征提取的问题进一步提出了基于目标中心点的联合检测和重识别的跟踪模型,实现了良好的跟踪准确度和实时性。

联合检测和重识别的跟踪模型虽然简单且有效,但是它们的性能通常不如基于检测的跟踪模型,性能的差异来源于联合检测和重识别模型面临的两个挑战:

1) 目标检测和重识别任务之间存在矛盾。检测任务需要区分不同的类,例如背景中的行人和车辆,因此需要为相同类的对象提取更相似的特征;而重识别任务要求区分的是个体,它需要为同一类中的不同对象提取具有差异的特征。在同一个骨干网中提取这两个相矛盾的特征导致了模型优化的困难。

2) 被遮挡的目标难以提取有效的重识别特征。不同于基于检测的跟踪算法 [6] [7] 可以使用大量额外的重识别数据集训练目标重识别模型,JDE模型 [8] [9] [10] [11] [12] 的重识别分支依赖检测模型聚合的特征进行分类学习。基于目标中心点的模型通过可变形卷积将目标的特征向其中心位置聚合。但在实际的聚合过程中,中心点特征通常重点关注到目标中心位置附近的信息,这导致当目标中心位置被遮挡时,网络很难找到目标正确的特征区域。

针对任务间的矛盾问题,近两年来,研究者使用特征解耦模块将主干网提取的原始特征图映射到子任务分支中 [11] [12]。这些解耦模块采用不同的注意力机制建模子特征图的相关关系,从而生成丰富且具有差异的检测特征图和目标重识别特征图。但是,这些模型没有从目标重识别本身的特性进行解耦。由于要区分所有目标,重识别特征更加关注深层特征图中的语义信息。为此,我们设计了一种关注深层特征的融合解耦方法,该方法使用不同的方式融合骨干网输出的多分辨率特征图,分别生成适合检测和重识别任务的特征图。

此外,为了聚合遮挡目标的有效特征,研究者通常在目标重识别分支后加入一个复杂的注意力网络学习不同尺度目标以及目标的相关性 [11] [12]。但是这导致了计算量的增加,在训练时需要更多的计算资源。为了缓解这一问题,本文提出了一种依据目标可视度构建监督热图的方法。该方法采用数据集中标注的可视度信息调整构建监督热图时的高斯核参数,使被遮挡的目标得到更大的关注,从而令目标区域的信息以更大概率聚合到目标中心,引导模型关注遮挡目标与其周围物体的联系。

综上所述,本文的主要贡献如下:

1) 改进了一种带特征解耦的无锚框的JDE跟踪算法,使用CA注意力机制和自底向上的融合模块将原始特征图解耦为检测特征图和目标重识别特征图。

2) 针对联合检测和重识别的跟踪算法难以提取被遮挡目标有效特征的问题,将目标的可视度融入到监督信息中,根据可视度调整目标中心热图的高斯核参数提高训练时对遮挡样本的关注。

3) 在MOT17验证集中对本文方法进行了测试,实验结果表明本文算法能够明显超过基准方法,并且改进的解耦方案优于其它同类型的解耦方法。

2. 相关工作

2.1. 联合检测与重识别模型

联合检测与重识别的跟踪模型在单个神经网络中实现目标检测和重识别特征提取,以简化多阶段的网络设计,减小模型并提升跟踪速度。这些模型通常建立在先进的检测算法上,例如JDE [8] 使用一个单独的Re-ID头在YOLOv3框架 [13] 原有的检测分支之外学习表观特征;FairMOT [9] 基于CenterNet网络 [14] 设计了目标中心点的特征提取分支;RetinaTrack [15] 修改RetinaNet [16],使用独立的分支对每个检测锚框进行分类、回归和表观特征提取,以防止为重叠目标提取相同的表观特征。为了在表观特征中融入时间和空间信息,GSDT [17] 利用图网络实现帧间特征融合,提升遮挡和变形目标的特征提取能力;CorrTracker [18] 采用自监督的方式同时学习目标的时空特性和尺度信息,提取轨迹的表观特征,明显提升了跟踪准确度。但以上算法均未解决目标检测和重识别的优化矛盾问题。本文在基于目标中心点的跟踪算法上,针目标重识别自身特点,将骨干网输出的原始特征解耦,使用不同的融合策略生成关注不同特征的检测特征图和重识别特征图。

2.2. 注意力机制与特征解耦

注意力机制是用来自动计算模型输出对不同特征关注度的一种特殊结构,通过注意力机制对中间特征进行加权从而过滤非典型信息。例如,SE [19]、CBAM [20] 以及CA (Coordinate Attention) [21] 中的注意力模块可以广泛应用于多种网络架构中对特征的通道及空间进行加权注意,提升模型的效果。在多目标跟踪算法中,研究者也基于注意力机制处理目标检测和重识别任务,生成不同的注意力图融合适合各自任务的典型特征,以提取更丰富且准确的重识别特征。例如,CSTrack [11] 设计了一种通道注意力解耦模块,称为互相关网络(Cross-correlation Network, CCN),通过目标检测与重识别特征的自相关和互相关操作生成通道注意力图,然后对各自特征图进行通道注意力加权;RelationTrack [12] 提出了一种全局的通道注意力机制,融合全局信息解耦骨干网提取的原始特征图。近期,SimpleTrack [10] 提出了一种自底向上的特征融合模块用于目标重识别分支,从而根据目标检测和重识别的任务特性进行了解耦。虽然SimpleTrack使用与检测分支不同的结构进行重识别融合的解耦方式有效,但是重识别特征融合模块更加关注浅层特征,这可能导致融合后的特征缺失深层语义信息。为了在重识别分支中充分聚合深层的语义特征,本文在深层特征上采样的过程中使用空间和通道注意力机制保留重要信息,并且逐层相加融合各分辨率的特征图,以减少信息的丢失。

Figure 1. Flow chart of JDE algorithm

图1. 联合检测与重识别算法跟踪流程

3. 算法设计

3.1. 算法框架

本文采用的联合检测和重识别在线跟踪框架基于目标中心点进行跟踪,如图1所示。该框架对视频序列进行单帧处理,其中的深度网络用来实现目标检测和重识别特征提取。输入的序列图片经骨干网提取深度特征图,再通过解耦器分解为用于目标检测的特征和用于目标重识别的特征,然后分别在头部网络中检测目标并提取对应目标的重识别特征向量。在跟踪阶段,数据关联模块根据由运动特征和重识别特征(表观特征)分别构建的代价矩阵确定检测与轨迹间的匹配关系,并迭代更行轨迹状态。其中轨迹的运动特征和表观特征分别通过卡尔曼滤波和指数移动平均(EMA) [8] 逐帧进行更新。

3.2. 深度网络

本文采用Stacked Hourglass Networks [22] [23] 作为骨干网,该网络在输入图片4倍下采样的高分辨率特征图上进行密集的预测,可以有效区分空间位置相近的目标,防止目标在特征图上的中心点映射存在大尺度的偏移而导致对应位置的重识别特征存在偏差,从而适应拥挤的多目标跟踪场景。为了通过该网络获得良好的目标检测特征图和重识别特征图,本文对其中的多分辨率特征融合模块进行了改进。如图2所示,首先使用两个结构相同参数不同的CA注意力将同分辨率的特征图进行初步的分解,突出各任务关注的特征通道和位置;然后对检测分支使用Stacked Hourglass Networks原有的自顶向下的特征融合结构聚合不同分辨率的特征;对重识别分支使用一种自底向上的特征融合结构进行特征聚合,在融合过程中使用空间和通道注意力操作保持深层特征中的语义信息。

Figure 2. The overall framework of the decoupling algorithm

图2. 解耦算法整体框架

3.2.1. CA注意力

本文利用CA注意力 [21] 将骨干网提取的多分辨率特征图进行初步的解耦,假设

表示骨干网输出的多分辨率特征图,N为特征层数,通过公式(1)将所有分辨率的特征图分解成两组:

(1)

其中

和

分别表示解耦后的检测和重识别多尺度特征图,

和

代表结构相同参数不同

的CA注意力模块。其中CA注意力是一种兼顾特征图位置关系的通道注意力模块,它在输入特征图上分别进行宽和高两个方向的通道注意力操作,以此捕获目标的位置信息和通道关系,可以有效增强特征的表达能力。

3.2.2. 自底向上融合模块

低分辨率的深层特征包含了丰富的语义信息,可以帮助模型进行更细粒度的对象级别的识别。在解耦的重识别分支中,采用一种自底向上的方式向浅层特征中传递深层语义信息。具体来说,将低分辨率的深层特征转化为高分辨率特征一共包含四个步骤:一是特征图上采样,将下层特征图尺寸调整到与上层特征保持一致;二是空间注意力,利用上层特征准确的空间信息生成空间注意力图,对上采样后的特征图进行空间信息编码;三是通道注意力,利用下层特征图生成的通道注意力权重对上采样后的特征图进行通道上的处理;四是将得到的特征图与上层特征图进行相加融合,从而保留原始信息。由此可以得到融合公式为:

(2)

其中

表示由可变形卷积和反卷积组成的上采样操作,

表示1 × 1的卷积层,

表示Sigmoid激活层,

表示层间的通道注意力操作。

的结构如图3所示,首先使用全局平局池化和全局最大池化聚合全局信息,然后使用一个标准的两层卷积模块将下层特征的通道维度压缩到与上层一致,最后与输入特征进行乘法调整各通道的权重。

Figure 3. CAM interlayer channel attention

图3. CAM层间通道注意力

3.2.3. 遮挡目标高斯核自适应调整策略

中心点检测和跟踪算法在输出特征图上进行一个密集的预测,判定像素点是否为目标中心点。为此本文采用基于热图的表示方法将标签信息转化为热力图的形式,在单类多目标跟踪场景中(例如行人多目标跟踪)热力图的维度为

,H和W分别代表模型输出的特征图的高和宽,1表示类别数。热图中与标注目标中心点重合的位置的预计响应值为1,视为正样本;不在目标标注框区域的预计响应值为0,视为负样本;标注目标中心到目标边界的响应值呈指数衰减,通过目标尺寸及可视度控制衰减速度。

具体来说,对于图中每个目标的真实边界框

,它在4倍下采样后的特征图中的映射边界框为

,使用高斯核函数平缓地将目标的中心点分布到热图中:

(3)

其中

为目标尺度自适应标准差,通过以下操作进行确定:

(4)

其中Guassian radius操作根据输入边界框尺寸自适应确定高斯核半径,它随着目标尺寸增大和目标可见度减小而增加,S表示目标的可见程度。

4. 实验

4.1. 实验细节

本文实验在两台NVIDIA GeForce RTX 2080Ti GPU上进行,操作系统为Ubuntu 20.04.1,采用PyTorch实现深度学习模型的训练和测试。本文模型首先使用在COCO数据集 [24] 上预训练的参数进行初始化,然后使用CrowdHuman [25] 验证子集和MOT17 [26] 训练集的前半部分进行微调,最后在MOT17训练集的后半部分进行测试。其中CrowdHuman数据集只提供检测级别的标注,因此对该数据集使用自监督的方式 [9] 训练重识别分支。实验采用Adam [27] 优化器更新模型参数,输入图像的大小设置为1088 × 608,Batch size设为12,总共训练30个epoch,初始学习率设置为10−4,在最后10个epoch减为10−5。

4.2. 实验结果

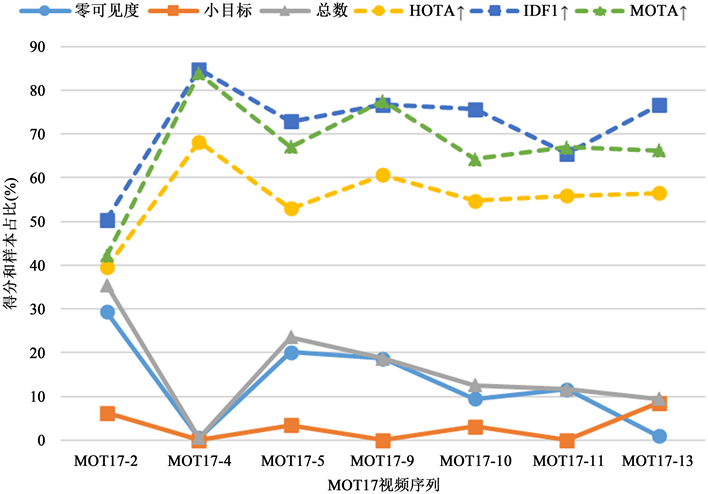

本文在MOT17验证集上对所提方法的跟踪性能进行测试。该数据集共有7段标注视频序列,其中第2、4、9段序列为固定镜头的街道行人场景,其余为镜头发生抖动或移动的行人场景,跟踪结果如表1所示。表中使用的跟踪评价指标来自于MOTChallenge基准,它们的具体含义在表2中进行了总结。为了说明不同类型的样本对跟踪性能的影响,本文在图4中给出了不同序列上HOTA、IDF1和MOTA三个重要指标以及对应序列中标注可视度为0和小尺寸目标(定义为面积小于900平方像素)数量占比的折线图。从表1结果可以看到,整体上三个指标随着0可视度和小样本比例的增加而减小,其中,IDF1指标受可视度为0的样本占比影响更大,而HOTA和MOTA受到小目标和可视度为0样本的双重影响。例如在序列13中没有0可视度样本但存在较多的小目标,此时IDF1依然取得较高得分,而HOTA和MOTA得分与序列10及序列11的分数基本持平,这说明目标遮挡是造成关联错误的主要原因。为了进一步说明本文算法的有效性,我们在表3中对比了同类型的跟踪算法。其中粗体代表最优结果,*代表使用了SimpleTrack [10] 提出的关联策略,没有*的表示采用FairMOT的关联策略。从表3结果可以看到,在使用FairMOT的关联策略时,本文方法比最先进的基于解耦的算法在HOTA和IDF1两个主要指标上分别提升了0.8和1.1。这两个指标的提升说明本文所提算法能够提取更可区分的重识别特征。在使用了SimpleTrack所提关联策略后,本文方法比最先进的基于解耦的算法在HOTA、IDF1和MOTA三个主要指标上分别提升了0.8、0.7和0.8,并且MT和FN都能够达到最优。这表明在使用特征解耦的跟踪算法中,本文所提的特征解耦模块能够有效将骨干网输出的原始特征图进行合理的解耦,从而提升跟踪效果。

Table 1. Tracking results of different video sequences

表1. 不同视频序列的跟踪结果

Table 2. Multi-object tracking evaluation index and its meaning

表2. 多目标跟踪评价指标及含义

Figure 4. Line chart of tracking results

图4. 跟踪结果折线图

Table 3. Tracking results of different tracking algorithms on MOT17 dataset

表3. 不同跟踪算法在MOT17数据集上的跟踪结果

4.3. 消融实验

本文的主要创新点为自底向上融合模块、CA注意力解耦和遮挡目标高斯核自适应策略。下面分别对这三个结构进行消融实验,消融实验在MOT17验证集上进行。其中表4为在FairMOT算法上添加各个模块的消融结果,BU_D代表自底向上融合模块,OA表示使用遮挡目标高斯核自适应策略,CA表示使用CA注意力解耦。从表4结果可以看到,在FairMOT算法上单独加入自底向上融合模块之后,HOTA和IDF1分别提升了0.9和2.2,MOTA得分略微下降,单独加入使用遮挡目标高斯核自适应策略也能够分别提升1.0的HOTA得分和1.8的IDF1得分,并且MOTA得分也只有微小的下降。在同时使用这两个策略之后,模型的跟踪性能在HOTA、IDF1和MOTA三个指标上都有了进一步的提升。最后加入CA注意力进行初步解耦之后,模型在HOTA、IDF1和MT三个指标上取得了最佳表现。

最后,我们比较了SE、CBAM和CA三种不同注意力模块在初步解耦时的有效性,实验在MOT17训练集的前半部分进行训练,在MOT17训练集后半部分测试,结果如表5所示。从表5结果可以看到,如果使用SE注意力进行初步解耦,模型的整体跟踪效果将会下降,这可能是由于单独的通道注意力无法

Table 4. Ablation study of different modules on the MOT17 dataset

表4. 在MOT17数据集上对不同模块的消融实验

Table 5. Effects of different attention mechanisms in initial decoupling

表5. 不同注意力机制在初步解耦时的效果

有效建模各分辨率特征图中的有效信息。CBAM和CA注意力取得了相同的MOTA得分,但是CA注意力在HOTA、IDF1、MT、ML和FN五项指标中都取得了最佳表现。

4.4. 可视化分析

为了从直观上验证本文算法的有效性,本文在一个困难场景中对所提算法进行了可视化分析,如图5所示。其中图5(a)分别为本文方法和FairMOT算法在MOT17-6的序列的跟踪结果。在这幅图像中,一个人穿过了遮挡物。FairMOT未能提取出具有代表性的Re-ID特征,导致目标没有与正确的轨迹关联。

具体来说,FairMOT在#147帧时得到的目标位置不准确,然后在帧#148目标的身份发生了切换。但是本文方法在行人穿过其它遮挡时依然能够稳定地跟踪。

此外,我们进一步使用CAM可视化方法 [28] 显示了模型对跟踪目标的关注区域,如图5(b)所示,其中图像取自MOT17-8序列。从标出的三个区域中可以看到,使用了遮挡目标高斯核自适应策略后的模型对被遮挡目标的可见区域施加了更大的关注,这从侧面说明了该策略的有效性。

5. 结论

本文在基于中心点的联合检测和重识别跟踪模型中增加使用自底向上融合解耦模块,获得更加丰富且具有差异性的检测特征和重识别特征,较好地解决了联合检测和重识别跟踪模型中检测和目标重识别任务之间的优化矛盾问题。针对遮挡问题,提出遮挡目标高斯核自适应策略,提高了模型对遮挡目标的关注,使模型可以提取遮挡目标可见区域的有效特征。实验结果表明,本文算法所提部件均能提升基准方法的跟踪效果,在MOT17验证集上取得了良好的表现。但是,使用两个分离的融合模块处理检测和重识别分支不仅增加了模型参数,而且使两个分支无法共享重要信息。此外,联合跟踪模型的跟踪精度依旧逊色于基于检测的跟踪模型,因此更加合理的解耦方式依旧是后续值得进一步研究的内容。

NOTES

*通讯作者Email: 13952004682@139.com