1. 引言

图像语义分割作为人工智能的热点之一,在农业、医学、交通等领域发挥着至关重要的作用。在我国,实施乡村振兴战略之后,通过Landsat8卫星、Modis卫星或无人机提供的遥感图像或鸟瞰图对水稻种植面积提取、农业耕地识别等图像语义分割技术为普惠金融、农业保险以及农村产业发展提供了有力的支撑。

对于图像语义分割,2012年AlexNet [1] 的提出为深度学习的发展奠定了快速发展的基石;2013年深度卷积网络(DCNN) [2] 通过提取网络更深的语义信息,与传统的机器学习方法相比具有更强大的特征提取能力;2015年UNet [3] 和SetNet [4] 等基于编码–解码结构的网络结构发挥了全卷积神经网络(FCN) [5] 的优势,其中UNet对不同通道级通过下采样与上采样进行特征融合,使得模型的特征表达能力更加突出;2014年开始提出DeepLab系列,DeepLabV1 [6] 通过去掉池化层保证了特征的平移不变性,并加入空洞卷积扩大感受野避免获得有限的特征信息,DeepLabV2 [7] 提出空洞空间金字塔池化层(ASPP)以获得多尺度的特征信息,DeepLabV3 [8] 加深了网络结构,在空间金字塔池化层中融合了位置信息,并在DeepLabV3+ [9] 则采用了编码–解码结构,通过对深层特征上采样与浅层特征进行融合,增加了图像的语义分割能力,但同时也存在一定的不足,如:边缘信息不明确、分割大目标存在孔洞等。

随着深度学习的发展,注意力机制成为提高模型精确度的必要手段之一,一些学者尝试将注意力机制融入到网络模型结构当中去。2018年提出的残差注意力机制 [10] 通过对不同通道赋予不同的权重,抑制非必要的通道,从而更加突出所需要的特征,这对于多波段遥感图像语义分割起到了极大的作用;同时2018年提出的CBAM (convolutional block attention module) [11] 同时关注了通道与空间两个因素,提出了通道注意力机制与空间主语里机制,丰富了特征的提取;此外2021年提出的坐标注意力机制 [12] 缓解了全局平均池化对于特征提取不足的影响,将位置信息嵌入到通道注意力中,对不同空间方面的特征进行提取。

此外,深度学习的发展一定程度上促进着适用于不同场景的语义分割模型的发展,特别是在我国乡村振兴战略支持下,针对于农作物而提出的诸如水稻面积提取、小麦倒伏识别、农作物病态情形抓捕等问题提出的深度学习模型。2019年Pena [13] 将SegNet用于农作物语义分割当中,与传统的机器学习方法相比,精确度得到了大幅度的提升;2021年宁纪锋,倪静 [14] 等人通过将注意力机制加入到DeepLabV3+模型当中,精度高于原有的DeepLabV3+模型,且对于无人机拍摄的多光谱遥感图像农田识别精度高于可见光;2021年,邓泓,杨滢婷 [15] 通过调整空间金字塔池化层中空洞卷积的膨胀率,从而提高了水田的边缘分割精度;2022年任鸿杰,刘萍 [16] 等人通过改进空间金字塔池化层,加入了处理正负样本不平衡的损失函数,优化了对于农田模型边缘的识别能力;2022年董荣胜,马雨琪 [17] 通过融合不同尺度农作物类别的特征信息,将浅层与深层的特征结合起来,提高特征的表达能力。

从上述等研究发现,现有的针对于农作物语义分割的模型存在一定的不足,表现为:1) 没有针对实际情况而提出的模型,如现有农作物种植区域存在着条形分布、离散分布等情形,采用普通的语义分割模型不具有针对性;2) 直接采用传统特征融合方式,未能抑制不重要的特征层的特征表达,从而造成信息污染和干扰;3) 未能缓解由于样本不平衡问题带来的影响。

针对以上问题,本文针对普通DeepLabV3+模型进行改进并进行模型评估,提出了以下改进思路:1) 使用全局平均池化不可避免地合并来自无关区域的污染信息,因此替换原有空间金字塔中的全局平均池化层为条形池化层;2) 加入自适应特征融合模块,在特征融合模块中加入多尺度通道注意力机制,赋予不同深度特征层相应权重,并提高对小尺度目标的关注度,降低特征融合过程中的噪声干扰,提升模型的鲁棒性;3) 利用类别平衡函数Focal Loss [18] 与Dice Loss [19] 缓解了样本不平衡的问题。

2. 网络模型

2.1. DeepLabV3+模型

DeepLabV3+模型在DeepLabV3模型的基础上改进为编码–解码结构。首先,针对于编码器部分,该模型通过骨干网络进行特征提取并输出浅层特征,再通过空间金字塔池化层增加卷积核的感受野,获取多尺度信息;其次,针对于解码器部分,该部分对编码器部分输出的下采样结果进行上采样,并与编码器部分输入的浅层特征进行结合;最终,通过卷积操作输出预测图像,具体网络结构如图1所示。

改进过后的DeepLabV3+模型通过增加空间金字塔池化获取多尺度信息,增加卷积核的感受野的同时缓解了因为下采样中池化层降低图片维度而导致的信息损失,最后为了减少下采样过程因为网络加深而导致的信息损失,DeepLabV3+模型采用了编码–解码的方式融合浅层特征与深层特征达到特征融合的目的,其中对深层特征上采样的方式采用线性插值方法,通过特征融合使得特征表达能力增强。

2.2. 条形池化层

条形池化层整体采用残差网络结构,通过水平面与垂直面的一维卷积对输入图像做一维池化,最后再进行融合,并与原有特征图进行点乘。如图2所示,首先条形池化层通过H × 1和1 × W的两个一维卷积对输入图像进行一维卷积,如公式(1)、公式(2)所示:

(1)

(2)

其中W为输入图像的宽,H为输入图像的高,c为输入图像的通道数,

为在水平方向做一维池化的输出结果,

为在垂直方向做一维池化的输出结果。

其次,通过上采样还原为与原图相同维度的特征图,再将两个方向池化过后的特征图进行融合,最后通过Sigmoid激活函数输出每个像素点的权重并与原图进行点乘形成新的特征图,如公式(3)、公式(4)所示:

(3)

(4)

其中,expand为上采样操作,z为上采样之后两个特征图融合的结果,

为Sigmoid激活函数,F为1 × 1卷积,

为点乘操作,

为最终输出特征图。

改进过后的空间金字塔模块(SP_ASPP+)如图3所示。

条形池化层对于具有长条形结构或离散分布的目标对象具有良好的特征提取作用,特别是在提取农作物的面积时,采样点的农作物种植地呈现如图4所示的长条型结构以及离散分布状态,因此采用如全局最大池化或者全局平均池化不能很好地提取特征,其将不可避免地合并来自无关区域的污染信息。

2.3. 自适应特征融合模块

2.3.1. 局部通道注意力机制

局部通道注意力机制如图5所示,首先,通过全局平均池化将H×W×C的特征图压缩为1 × 1 × C的特征图。具体过程如公式(5)所示:

(5)

其中,H、W和C分别表示为输入图像的高、宽和通道数;

为全局池化操作;

为输入的特征图。

其次,通过卷积层压缩通道数,获得通道之间的关系,再通过批归一化和ReLU激活函数规范权重分布,得到每个通道的权重s。具体过程如公式(6)所示:

(6)

其中

,

,BN为批归一化操作,

为激励操作;z为挤压操作得到的池化特征图;

和

分别为第一层卷积层和第二层卷积层的权重;r为降维系数。最后将权重与原始特征相乘,得到新

的特征。具体过程如公式(7)所示:

(7)

其中

为点乘操作。

局部通道注意力使得神经网络在训练过程中可以赋予不同重要程度的通道不同的权重,自适应选择通道的有效信息,排除某些通道上的噪声信息。全局通道注意力结构以残差注意力机制的结构为基础,通过增加批归一化和ReLU激活用于调整权重分布,残差结构增强了模型对强噪声和高冗余数据的处理能力。

2.3.2. 全局通道注意力机制

全局通道注意力与局部通道注意力相似如图6所示,输入同样为H × W × C的特征图,输出为维相同维度的通道权重矩阵。局部通道注意力机制通过全局平均池化简化了位置信息,将位置信息压缩到一个像素点之上,使得神经网络更好地关注于通道之间的关系,在对小尺寸目标的特征提取上具有较好的鲁棒性,但由于将水平方向和垂直方向上的信息压缩到一个像素点会导致重要的位置信息损失,因此全局通道注意力模块舍弃了全局平均池化,关注全局信息,直接采用1 × 1卷积将输入特征图的通道数降为原来的1/16,通过卷积建模各通道间的相关性,并将特征图通道数恢复为C。

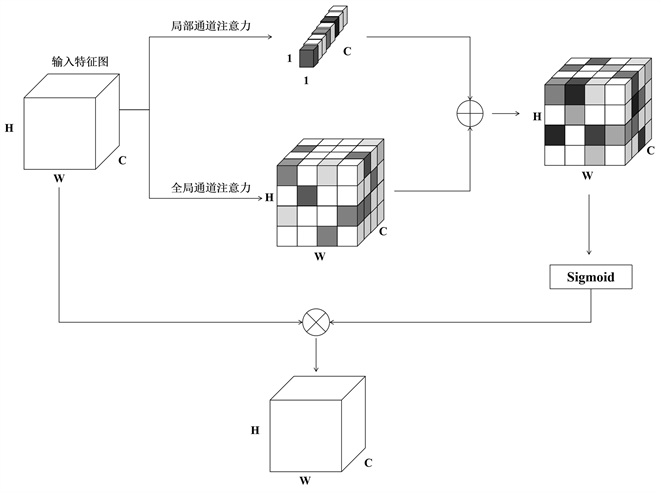

2.3.3. 多尺度通道注意力机制

多尺度通道注意力结合全局通道信息和局部通道信息,如图7所示。首先局部通道注意力机制更好地关注了通道之间的关系并且提高了神经网络对小尺度目标的关注度;其次,全局通道注意力机制舍弃全局平均池化,更加关注位置上的特征信息。通过结合全局通道信息和局部通道信息,降低特征融合过程中的噪声干扰,提升图像语义分割算法的鲁棒性。具体过程如公式(8)所示:

(8)

其中,Z为输入的特征图,A为局部通道注意力,B为全局通道注意力,

为Sigmoid激活函数,

为对应元素点乘,

为最后输出特征图。

Figure 7. Multi-scale channel attention

图7. 多尺度通道注意力机制

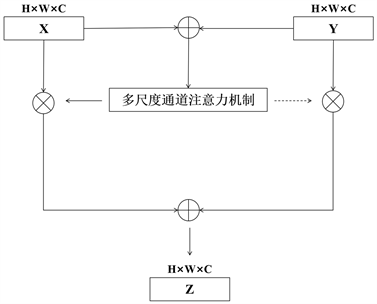

2.3.4. 自适应特征融合模块

Figure 8. Adaptive feature fusion module

图8. 自适应特征融合模块

自适应特征融合模块如图8所示。首先,将不同尺度的特征图对应元素进行相加,并通过多尺度通道注意力机制获得不同通道的权重;其次,对不同尺度的特征图的通道赋予权重;最后,将赋予权重侯的不同尺度的特征图对应元素相加,以达到特征融合的目的。具体过程如公式(9)所示:

(9)

其中,X和Y为维度相同的两个不同特征层的特征图,G为多尺度通道注意力,

为对应元素点乘,

为最后输出特征图。

自适应特征融合模块等同于对不同尺度的特征图进行加权平局以达到选择较重要的特征层的作用,均衡了输入特征所携带信息所占比重。

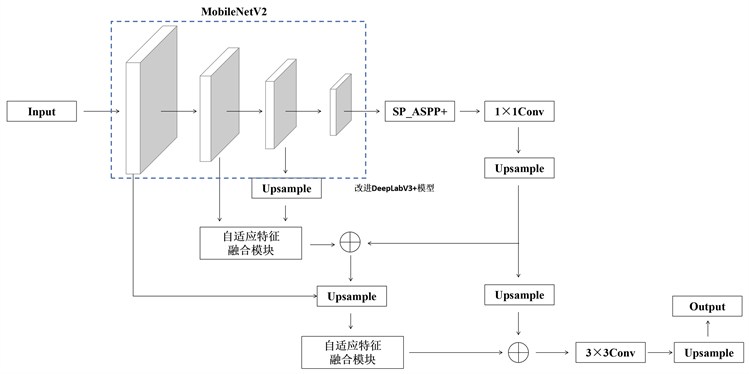

2.4. 改进DeepLabV3+模型

Figure 9. Improved DeepLabV3+ model

图9. 改进DeepLabV3+模型

改进DeepLabV3+模型如图9所示。首先,通过特征提取器MobileNetV2骨干网络提取特征;其次,通过SP_ASPP+模块利用不同感受野的卷积核获得多尺度目标信息;最后,通过两次自适应特征融合模块对不同尺度的特征信息进行融合。

改进DeepLabV3+模型首先改善了由于全局平均池化带来的冗余信息的干扰,针对样本本身出现的条形结构以及离散结构提出SP条形池化层,增加了特征信息的提取能力;其次,由于低层特征分辨率更高,包含更多位置、细节信息,而高层特征具有更强的语义信息,但是分辨率很低,对细节的感知能力较差,因此通过自适应特征融合模块可以自适应地选择对提升语义分割精度有用的特征层信息,缓解了普通特征融合模块带来的由于尺度和语义信息不一致带来的信息差错。

2.5. 损失函数

为了缓解类别不平衡问题,引入Focal Loss与Dice Loss替代交叉熵损失函数。本文考虑改进的Focal Loss,其同时考虑了“正负样本平衡”和“难以分辨样本”的问题,根据不同类别样本的数量设置权重,并给予更难辨别的样本更大的权重。具体过程如公式(10)所示:

(10)

为样本类别权重,给不同类别的样本损失函数给予权重;p为样本预测置信度;

减少预测置信度较高样本损失函数的比重,使得模型更关注置信度较低样本损失函数的优化。由于Dice Loss训练时不稳定,因此与改进的Focal Loss结合使用.具体过程如公式(11)所示:

(11)

3. 实验

3.1. 数据集

为了验证改进DeepLabV3+模型的有效性,本文通过实地考察采集,选取成都市青白江区以及大邑县中两个试验地的数据,并通过人工标注区分水稻以及非水稻区域并制作标签,水稻区域标注为1,非水稻区域标注为0,对这两类样本进行语义分割实验。

通过裁剪、翻转、旋转以及加入噪点对数据进行数据增强分别产生1152张尺寸大小为256 × 256的三波段遥感图像,其中训练集736张,验证集185张,测试集231张。遥感图像格式为jpg格式,标签格式为png格式,实验中不更改遥感图像和标签的图像格式,如图10,图11所示。

3.2. 实验参数与环境

为了保证实验的公平性,本文通过控制变量法保证每个实验中的超参数相同,5个实验均将初始化学习率设置为0.005,学习率下降方式选择余弦下降方式,优化器选择Adam优化器,动量设置为0.9,weight decay设置为0.0001,下采样倍数设置为8,迭代次数设置为200次,骨干网络使用MobileNetV2的预训练权重进行训练。实验在Linux系统中执行,实验平台为Python3.7,深度学习框架为Pytorch1.10.0,CUDA版本为11.6,显卡型号为NVIDIA Tesla A40。

3.3. 评价指标

为了评估模型性能,本文在选择交并比(mIoU)、召回率(Recall)、训练参数2种指标来评价模型的精度,以上2种指标标准值越高则精度越高。

3.4. 实验结果

为了验证改进DeepLabV3+模型有效性,设计了4个实验,分别为对照组实验、在DeepLabV3+模型中加入SP_ASPP+模块、在DeepLabV3+模型中加入自适应特征融合模块、在DeepLabV3+模型中加入SP_ASPP+模块和自适应特征融合模块,并对不同模型的一个Batch的训练参数进行统计,实验结果如表1、表2、表3所示。

Table 1. Ablation results (IoU)

表1. 消融实验结果(IoU)

Table 2. Ablation results (Recall)

表2. 消融实验结果(Recall)

Table 3. Ablation results (Total Params)

表3. 消融实验结果(Total Params)

由表1、表2发现,首先,在DeepLabV3+模型中加入SP_ASPP+模块后,在2种数据集的消融实验中平均IoU指标值与平均召回率指标值均得到了提升;其次,在DeepLabV3+模型中加入自适应特征融合模块后,在2种数据集的消融实验中平均IoU指标值与平均召回率指标值均得到了更大的提升,其中,青白江区试验地的平均IoU指标值与平均召回率指标值分别提升了5.83%和3.52%;最后,在DeepLabV3+模型同时加入SP_ASPP+模块与自适应特征融合模块后,效果比单独加入两类模块,在两个试验地上的平均IoU指标值与平均召回率指标值分别提升了6.25%、4.56%和2.12%、2.97%。这两类实更好验证明了改进DeepLabV3+模型的有效性。同时由表3发现,改进DeepLabV3+模型相对减少了训练参数,在数量级上保证了轻量型网络的特征,同时提升了相对精度,具有良好的性能。

此外,为了说明改进DeepLabV3+模型的性能,与当下主流网络(FCN8S、SegNet以及UNet++)进行对比,对比实验结果如表4、表5以及表6所示。通过对比实验说明,改进DeepLabV3+模型相比当下主流网络而言,在保证了轻量型网络的基础上同时提升了语义分割的精度,具有较好的应用效果。

Table 4. Comparative experimental results (IoU)

表4. 对比实验结果(IoU)

Table 5. Comparative experimental results (Recall)

表5. 对比实验结果(Recall)

Table 6. Comparative experimental results (Toal Params)

表6. 对比实验结果(Total Params)

首先,改进DeepLabV3+模型通过SP_ASPP+模块中的SP条形池化层缓解了由于全局平均池化带来的位置信息损失,针对数据集中的“条型结构”以及“离散结构”提出了较好的解决方案,将方形卷积核拆分为两个不同方向的一维卷积核,并通过残差网络结构实现长期依赖关系,达到提高特征提取的能力;其次,自适应特征融合模块通过全局和局部通道注意力机制缓解尺度变化和小对象引起的问题,弥补不同尺度间的特征不一致,实现特征融合。最后的预测图像如图12所示,在原始图像1中,水稻区域呈现离散分布,对照组出现了预测水稻区域粘连和多余的情景,通过加入SP_ASPP+模块缓解了由于全局平均池化带来的信息干扰,自适应特征融合模块使得特征提取更加完善,而通过两类模块融合达到了比较好的预测效果,缓解了区域粘连和多余的问题;在原始图像2中,方框1中为条型结构,方块2中为离散结构,对照组未能将条形结构区域预测出来,而SP_ASPP+模块虽然缓解了部分条形结构区域消失的问题,但由于特征信息提取不完全,未能将水稻区域完全预测,自适应特征融合模块增加了特征信息,但同时增加了部分冗余信息,而通过两类模块融合使得特征信息有较好的表达。

4. 结束语

本文提出改进DeepLabV3+模型,并利用2种试验地数据进行训练和测试,得到的主要结论为:

首先,针对样本出现的条形结构区域和离散结构区域,加入SP_ASPP+模块缓解了由于全局平均池化层带来的位置信息损失,减少了冗余信息带来的干扰;其次,通过自适应特征融合模块自适应选择特征层的信息进行融合,抑制不重要的特征层的信息表达,克服输入特征之间语义和规模不一致的问题。

由于骨干网络为轻型MobileNetV2网络,因此若要得到更高的精确度,可以替换如Xception网络、ResNet网络作为骨干网络,在实验条件允许的情况下,后期可以通过替换骨干网络以达到提升网络性能的目的。