1. 引言

骨关节炎(OA)是迄今为止最常见的肌肉骨骼疾病,其发生与年龄有着密切的联系,是全球中老年人关节疼痛和功能障碍的主要原因之一。膝关节疾病的诊断依赖于医生的观察和个人经验,需要大量的人力和时间,随着医学影像技术的发展,通过计算机辅助诊断技术对膝关节软骨MR成像进行图像处理可以辅助医生诊断软骨的变化并实现早期诊断。

由于MR图像中的软骨细小狭长,形态多变,与周围组织对比度相似,存在伪影、噪声、图像模糊等问题,因此软骨的自动分割和定量分析存在困难。相比于传统的图像分割算法,深度学习算法有更好的分割精度。深度学习具有从数据中自动学习深层次和鉴别性特征的能力。目前,利用深度学习与医学影像技术结合已经成为医学影像分割、分类以及病变识别的主要方法。卷积神经网络(CNN)是目前应用最为广泛地深度学习算法。全卷积神经网络(FCN)通过卷积计算,对上采样后的特征图进行逐像素分类,实现了端到端的训练。Badrinarayan [1] 等人基于FCN提出了SegNet构建了编码–解码对称结构,实现端到端的像素级分割。2015年,Ronneberger [2] 等人将FCN与SegNet网络结合,提出一种U型网络模型U-Net,该网络基于编解码结构,网络左侧输入图像逐层进行特征提取,右侧则进行上采样实现特征融合,目前已成为医学图像分割首选模型。Felix [3] 等人结合统计形状模型和两种不同的CNN (2D U-Net和3D U-Net)在二维CNN分割的基础上进一步分割,对病理数据、成像伪影以及不同MRI序列中的不同图像外观具有鲁棒性,但训练起来相对复杂。Somaye [4] 提出了一种基于CNN的框架和手工制作的基于特征的学习框架JD-HCl方法,该方法以级联的方式结合了从ACT的预分割区域(从3D U-Net获得)提取的本地和上下文手工特征。与使用端到端深度学习技术的最佳结果相比,该方法提高了分割性能,并减少了平均表面距离和体积误差,然而还是会出现软骨间边界的欠分割和过度分割的问题。

虽然目前已有一些深度学习方法用于分割膝关节软骨,但在膝骨关节炎的相关研究仍然不是很多。且只使用U-Net网络对其训练,存在网络性能退化、图像空间特征利用率低等问题,使得分割准确率偏低。本文将深度可分离卷积模块代替卷积模块作为基本模块,减少参数量,增加对深层信息的提取。利用基于ECA的金字塔模块获取不同的感受野,克服了U-Net模型单一感受野的局限性,提高了对不同大小目标的分割能力。设计多尺度输出融合的深监督模块,提高了U-Net网络的分割效果。

2. 改进的U-Net分割方法

2.1. U-Net结构

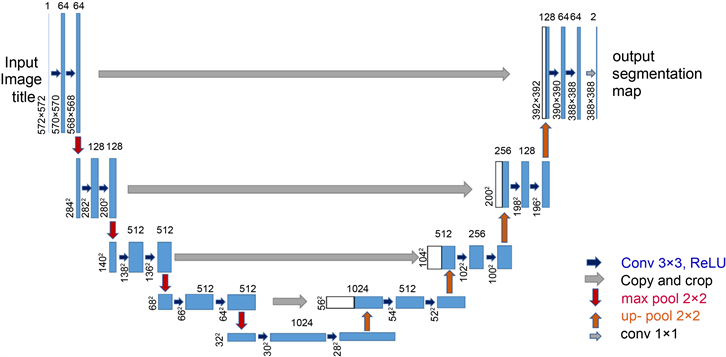

U-Net网络结构是全卷积神经网络(FCN)基础的改进,主要由三部分组成:编码器(Encoder)、解码器(Decoder)和跳跃连接(Skip Connection),由图1可见,网络分为左、右两个部分,左边是压缩过程,即编码阶段,右边是扩张路径,即解码阶段。收缩路径主要采用卷积网络结构,由两个重复的3 × 3卷积核组成,且均使用RELU激活函数和一个用于下采样的步长为2的2 × 2最大池化层。在每个下采样步骤中,每进行一次池化,图像就会缩小为之前尺寸的一半,特征通道数量变为之前的两倍。扩张路径和收缩路径正好相反,它是进行反卷积的过程。每步都包含对特征图进行上采样,扩张路径中每进行一次上采样(Upsample,简称Up),图像就会放大为之前尺寸的双倍,对应的特征通道数变为之前的一半;最后,再进行一次1 × 1操作,使网络模型对像素点进行分析推断。U-Net在编码阶段通过卷积和下采样降低图像尺寸,提取一些浅层的特征信息;而解码阶段通过卷积和上采样获取一些深层次的特征。中间通过叠加的方式,将编码阶段获得的特征图与解码阶段获得的特征图叠加在一起,结合深层次和浅层次的特征,细化图像,最后根据得到的特征图进行预测分割。

Figure 1. U-Net of the network structure

图1. U-Net结构图

2.2. 本文提出的改进U-Net模型

本文在U-Net网络基础上,用深度可分离卷积模块代替卷积模块,该模块大大减少了参数量。在ECA-Net网络中提取一种高效的注意力机制(ECA模块)结合金字塔模块提出EAS特征提取模块,提高对软骨目标细节信息的提取。最后加入多尺度输出融合模块,更好地捕捉复杂的特征,并有效地提高模型的性能。

2.2.1. 深度可分离卷积模块

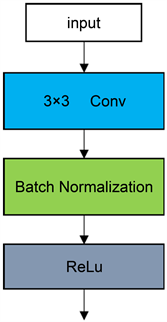

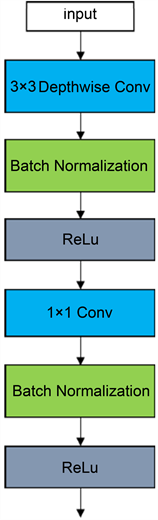

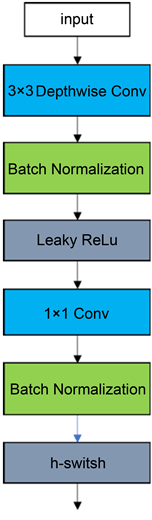

深度可分离卷积模块 [5] 是一种特殊的卷积操作,他将卷积操作分解为两个步骤:深度可分离卷积和逐点卷积。第一步是深度可分离卷积,它将输入图像的每个通道分别卷积,而不是将所有通道一起进行卷积,这样可以减少参数量,从而提高模型的计算效率。第二步是逐点卷积,它将深度可分离卷积的输出进行点卷积,以提取特征。如图2(a),普通的卷积模块相似,深度可分离卷积模块在Depthwise和Pointwise层后加BN层和激活函数层,如图2(b)所示,但使用ReLU做为激活函数,因其对负值取0的特性,会失去部分的特征信息,所以使用LeakyReLU替代ReLU作为激活函数,并且在逐点卷积后使用h-switsh函数替代ReLU作为激活函数减少网络层数增加造成的网络梯度消失的问题,如图2(c)。模型的优势在于可以提高模型的计算效率,减少参数量,增加对深层信息的提取,提高模型的准确性。h-swish函数是swish激活函数的简化,swish的计算方法如公式(2-1)所示:

(2-1)

其中

是个常数或可训练的参数。swish具备无上界有下界、平滑、非单调的特性。相较于ReLU激活函数及其衍生激活函数,在负责的卷积神经网络中,swish激活函数可以很好的提高神经网络对目标检测的精度。但是swish函数存在计算量大的问题,h-swish函数的出现很好的解决了swish函数在计算量上的限制。h-swish函数的计算方式如公式(2-2)所示

(2-2)

(a) 标准卷积模块

(a) 标准卷积模块  (b) 深度可分离卷积模块

(b) 深度可分离卷积模块  (c) 优化的深度可分离卷积模块

(c) 优化的深度可分离卷积模块

Figure 2. Deep separable convolutional module

图2. 深度可分离卷积模块

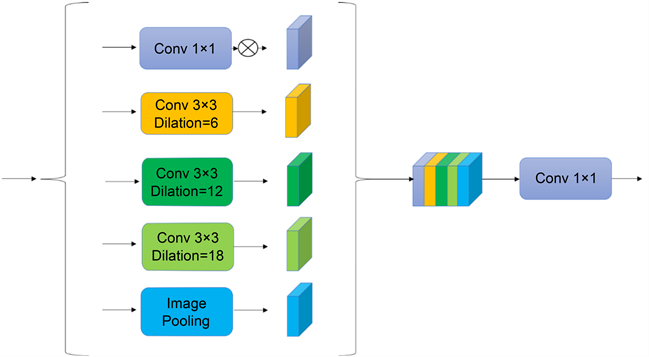

2.2.2. 基于注意力机制的金字塔模块

Chen [6] 等人在DeepLabV3算法中提出了空洞空间金字塔池化模块。ASPP模块包括一组并行的具有多个扩张率的空洞卷积,通过调整卷积核的感受野来提高多尺度目标的识别效果。ECA-Net [7] 是一种高效的通道注意力机制。该模块改进了原有的SE-Net模块,只有少量的参数,并且能够提高网络的检测性能。ASPP模块不仅引入了全局平均池化路径来获取图像级特征,而且使用了多条空洞卷积路径,在一定程度上降低下采样操作导致目标边缘信息的损失,更重要的是能够获取到图像多尺度的特征。但ASPP模块并行结构中第1条路径并没有用空洞卷积获取多尺度特征,而是通过使用1 × 1卷积核,对输入的特征图调整通道数,无法有效的对特征进行筛选。上文提到的ECA-Net网络模型属于通道注意力机制,通过对特征通道施加注意力的方式来调整特征的重要程度,本文将其与ASPP模块结合,提出了EAS模块。如图3本文将EAS模块嵌入到U-Net网络的编码端,提高网络对多尺度的软骨特征提取能力。

Figure 3. Pyramid modules based on attention mechanism

图3. 基于注意力机制的金字塔模块

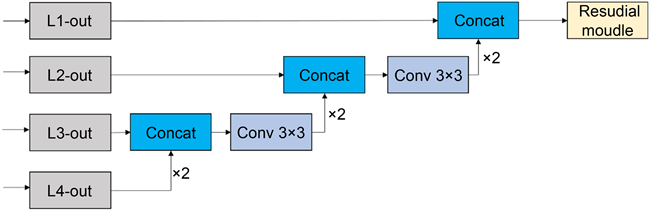

2.2.3. 多尺度输出融合模块

对于采用编码–解码结构的U-Net网络来说,只有最后一个阶段输出最后的模型预测分割图。最终模型预测分割图通过对最后一次跳跃连接的输出特征图融合得到。最后阶段虽然结合了最底层的特征和经过了融合压缩后的高层特征,具有良好的空间位置信息和像素类别信息。然而,模型编码端经过了多次卷积池化等操作,获得图像特征降低模型参数的同时,会失去一些特征信息。并且在解码端多次进行上采样操作,恢复特征图尺寸的同时,同样会失去部分信息,二者都会使预测的精度下降。故提出多尺度输出融合模块 [8] ,如图4所示,它可以将多个不同尺度的输出结果进行融合,从而提高模型的准确性和精确度。它可以帮助模型更好地捕捉复杂的特征,并有效地提高模型的性能。此外,多尺度输出融合模块还可以帮助模型更好地处理不同尺度的输入,从而提高模型的准确性和精确度。在选择特征融合的方式上,一般有两个:一是add融合方式,另一个是concat融合方式。add融合方式是对上下路的对应位置元素的值进行相加,但在融合过程中会损失原始特征的信息,难以体现特征间的互补性。concat融合方式是对上下路的直接级联融合,将不同的通道进行合并,不仅避免了add融合方式对原始特征信息产生的损伤,并对上下路的特征进行通道数的合并,综合了前面所得到的特征,从而得到后续的特征。

Figure 4. Deep supervision module of multi-scale output fusion

图4. 多尺度输出融合的深监督模块

2.3. 损失函数

在进行网络训练的时候,损失函数也是一个重要的环节。损失函数的值越小,那么预测值就越接近真实值。交叉熵(Cross Entropy, CE)是医学图像分割最常用的损失函数。但是,在分割类别不平衡时,往往会丢失较小的目标。从图可看出本文属于小目标分割,软骨占图像比重较小。戴斯损失函数(Dice Loss, DL) [9] 是由戴斯系数演变而来的损失函数,通过预测结果与真实结果之间的重叠F差异来计算,表达式如(2-5)所示,其中Pre表示预测图像,Gt表示真实图像。所以本文将两者结合,最后使用的损失函数由两部分组成

(2-3)

(2-4)

(2-5)

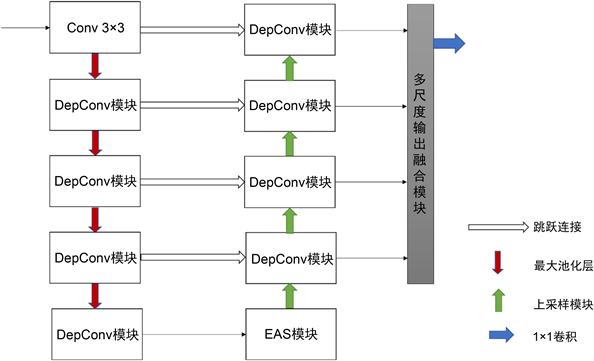

2.4. 本文模型结构

虽然U-Net在生物医学图像领域取得了很好的效果,但仍有可改进的地方。本文提出的EAS-U-Net如图5所示,以深度卷积可分离模块代替卷积模块作为基本模块,减少参数量,增加对深层信息的提取。由于存在大小不一的分割目标,添加基于注意力机制的金字塔模块(Atrous Spatial Pyramid Pooling, ASPP),利用具有不同感受野的卷积操作获取丰富的上下文信息。在多输出融合的深监督模块中融合不同,实现多层次特征的互补,提高分割精度注意力模块是一种能让模型对重要信息重点关注并充分吸收学习的技术,它可以帮助网络快速锁定待处理部分,减少不必要的计算损耗,是一种非常有用的降低网络计算量的方法。大量实验证明注意力模块的加入提升了图像分割网络的分割性能。结合戴斯损失函数(Dice Loss)和交叉熵(CE Loss)两种损失函数的混合损失函数,从而将两者者优点进行结合,更加充分地利用语义信息。

3. 实验结果与分析

3.1. 实验环境与数据集设计

实验环境为Ubuntu操作系统,python3.8编程语言和Pytorch1.7.0深度学习框架,硬件采用CPU为Intel Xeon Silver 4210R、内存为56GB和显卡为RTX 3090的计算机,采用CUDA11.0加速计算。学习率为0.01,优化器采用权重衰减为0.0001、动量系数为0.9的SGD,batchsize大小设为16,预设的训练轮数为50。

Figure 5. Diagram of the network structure

图5. 网络结构图

本文使用公共数据集OAI-ZIB [3] ,来源于美国国家卫生研究院的骨关节炎行动计划。数据集采用神经影像学信息技术计划(NIFTI)格式,它能把3D图像存储为NIFTI文件,从而有效地解决了单一文件丢失的问题。数据集总共包含507套MRI和相应的人工标注图,每一套都包含130张左右切片,每张切片的分辨率为384 × 384,其中人工标注的内容包括股骨、胫骨、股骨软骨、胫骨软骨等膝关节的不同部位。本实验将所有数据及转化为PNG格式,挑取100套,每套100张左右切片。

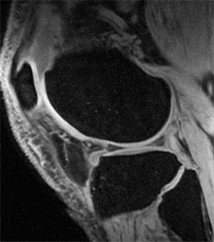

本文使用三维医学处理软件ITK-SNAP,可视化OAI-ZIB数据集中随机一套膝关节数据,图6示了部分MRI数据图和标注图。图中第一列是MRI的横断面,第二列是矢状面,第三列是冠状面。图6(a)~(c)表示膝关节三个断面的数据图,图6(d)~(f)表示膝关节数据图对应的标注图。标注图中不同颜色代表不同的膝关节解剖结构,以图6(e)为例,从上至下的颜色依次代表股骨、股骨软骨、胫骨软骨、胫骨。本文任务目标膝关节软骨具体包括股骨软骨以及胫骨软骨,由于MRI的矢状面与横断面相比可以更明显地展示软骨的细长月牙状特点,与冠状面相比可以避免两侧软骨同时出现,故本文实验数据均使用MRI的矢状面。读取数据集,对每套进行遍历,判断标注图有无股骨软骨和胫骨软骨的标注信息,若没有目标软骨的信息,则去掉对应的数据和标注切片,如图7。

由于本文只研究股骨软骨和胫骨软骨,所以对数据集进行预处理,针对标注图,计算各部位的像素值,并将像素重新归类,设置背景灰度值是0,股骨软骨灰度值是1,胫骨软骨灰度值是2。

(a) 原图

(a) 原图  (b) 标注图

(b) 标注图  (c) 预处理后标注图

(c) 预处理后标注图

Figure 7. The preprocessing result graph

图7. 预处理结果图

3.2. 评价指标

为了能精确度量网络对膝关节医学影像中软骨的分割效果,在本文中将戴斯系数、精确率以及豪斯多夫距离作为评价指标。

1) 戴斯系数

戴斯系数(DSC)是分割任务中为了衡量两个样本相似程度最常使用的评价指标,取值范围是[0, 1],见公式(3-1)Pre代表网络预测图像,Gt代表真实图像。

(3-1)

2) 精确率和召回率

在分割任务中,预测值和真实值会产生四种结果。真阳性(TP)表示预测值为真,真实值为真。假阳性(FP)表示预测值为真,真实值为假。真阴性(TN)表示预测值为假,真实值为假。假阴性(FN)表示预测值为假,真实值为真。精确率和召回率可以通过四种结果得到。

精确率(Precision)衡量预测结果中正确预测的值所占的比例。详见公式(3-2),TP + FP为被预测为正样本的数量:

(3-2)

召回率(Recall)衡量标签为正样本的实例中正确预测的值所占的比例,见公式(3-3)。TP + FN标签为正样本的数量:

(3-3)

3) 豪斯多夫距离

豪斯多夫距离(HD)通常用来度量两个无序点集合的相似程度。详见公式(3-4)。A、B分别为集合

和

。

代表集合A到集合B的有向距离。

为单向豪斯多夫距离

和

中较大者,用来衡量两个集合的最大不匹配度,豪斯多夫距离越小,两个数据集越相似。

(3-4)

3.3. 实验测试与对比

本文针对U-Net模型在膝关节MR软骨图像分割过程中效果不理想的问题,对网络模型进行了改进并成功完成了模型的训练。图8为模型在训练集上的损失曲线,由图8可看出,模型在迭代次数达30左右时,损失函数值基本趋于不变,稳定在0.28左右,表示模型基本收敛。图9为模型在验证集上的损失曲线,验证集能够反映训练后的实际模型。当模型迭代30次后,损失函数值基本趋于不变,稳定在0.27左右。代表训练完成。

下面是训练好的模型在测试集分割后得到的结果,部分图如图10所示。由左往右分别是原图、标签图像、Unet结果图和EAS U-Net结果图。

从图10不同模型分割效果对比图可以看出,几种方法都存在一定的漏分割和错误分割的现象。本文所提出的网络对软骨分割具有较高的分割精度,U-Net预测的分割图出现了明显的软骨缺失,而EAS U-Net预测的软骨区域明显大于U-Net分割结果,说明EAS U-Net提高了对小目标的分割能力。

为进一步验证改进的网络分割精度是否提升,针对以下指标进行计算。如表1所示,相比于其他的网络模型,本文提出的改进的网络模型,在相同测试集的各项指标都有一定的优势,说明本文的改进模型在膝关节软骨的分割上能达到理想的分割效果。

Table 1. Quantitative evaluation of segmentation of different models

表1. 不同模型的分割的定量评估指标

4. 总结

膝关节软骨的精确分割对膝骨关节炎的早期诊断以及治疗有着重要意义。本文在U-Net网络的基础上,提出了一种端到端的EAS U-Net。通过深度可分离卷积模块代替标准卷积模块,能够减少参数数量,从而提高模型的计算效率,利用基于ECA的扩张卷积模块ASPP,一定程度上降低下采样操作导致目标边缘信息的损失,设计多尺度输出融合模块实现特征信息互补。通过不同网络模型的对比试验,本文提出的网络模型在膝关节软骨分割上取得了较好的分割精度。