1. 引言

遥感图像目标检测是指使用特定的方法从遥感图像中搜索并标记感兴趣的目标,其在城市规划、智慧农业、路网监测、军事探测等方面均有广泛应用 [1] 。例如,基于遥感图像数据研究推测城市体系空间结构的演化趋势,设计、制定高效的土地使用战略;基于多源遥感数据构建综合干旱监测模型,为地区防旱抗旱实践提供科学依据;基于高分辨率遥感图像信息,搭建军事阵地动态监测平台等。随着遥感卫星技术的发展,遥感图像目标检测具有更多的应用前景和科研价值。

由于成像平台和成像方式不同,遥感图像相较于自然图像具有背景复杂、目标像素数少以及尺度变化大等特点,这导致直接将自然图像的目标检测方法应用于遥感图像目标检测时效果不佳。对此,许多研究学者提出、改进了适用于遥感目标检测的深度学习网络。Wang等 [2] 利用K-means对大小不一的飞机目标进行聚类分析获得代表性的飞机尺寸,以此提高对多尺度飞机目标的检测精度。Ding等 [3] 使用密集卷积网络和多尺度表示等改进、增强基础VGG16网络。姚群力等 [4] 提出了一种多尺度卷积神经网络遥感目标检测框架,通过改进特征金字塔结构增强多尺度目标的检测能力。刘楠等 [5] 改进Faster R-CNN网络,设计通道数可调模块和感受野可调模块以分别提升检测遥感目标检测的速度和精度。

为进一步提高复杂背景干扰下多尺度遥感目标的检测精度,本文提出一种基于多尺度特征增强的遥感图像目标检测方法,使网络关注遥感图片中丰富的位置信息和多尺度特征信息,提高遥感图像目标检测精度。首先使用引入注意力机制的HRNet网络替换原ResNet网络,引导主干网络关注有用的特征区域,抑制复杂遥感图像背景的干扰;然后设计多尺度特征增强金字塔网络,强化多尺度特征信息,增强对多尺度目标的检测能力。本文从公共数据集中选择五类遥感目标搭建实验数据集,通过消融实验验证所改进部分的有效性,与近年的经典目标检测方法进行对比实验验证本文方法的检测性能。

2. 网络结构

基于多尺度特征增强的遥感图像目标检测方法网络结构如图1所示,主要包含四个部分:主干网络(Backbone Network)、多尺度特征增强金字塔网络(Multi-Scale Feature-Enhanced Pyramid Network, MSFE-FPN)、区域提议网络(Region Proposal Network)和级联检测器网络(Cascade Detector Network)。

主干网络使用HRNet [6] 替换ResNet来提取遥感图像的特征信息,图片输入到主干网络后依次经历四个阶段提取特征信息。以输入三通道遥感图片为例,在第一阶段,首先经过卷积层将图像的特征维数从3扩展到64;然后经过四个添加注意力机制的瓶颈模块引导网络关注图像中的重要特征信息;最后分别经过两个卷积块,产生高低两个分辨率的并行子网输入到第二阶段。后续三个阶段与第一阶段类似,逐步增加一条并行多分辨率子网,在主干网络的第四阶段获得四个并行多分辨率子网输出。

2.1. 注意力机制

注意力机制在深度学习领域被广泛应用,并且在目标检测任务中表现出优秀的性能。本文在HRNet第一阶段加入CBAM (Convolutional Block Attention Module, CBAM) [7] ,使主干网络能够自适应细化输出特征,关注图像的重要特征区域,增强其对复杂图像背景的抗干扰能力。加入CBAM的瓶颈块如图2所示。

Figure 2. Add CBAM to the bottleneck block

图2. 瓶颈块中添加CBAM

在加入CBAM前使用1 × 1卷积和3 × 3卷积代替单独的3 × 3卷积,以降低图像维数、减少网络中的参数量。CBAM包括注入通道注意力和空间注意力两部分。首先对特征图注入通道注意力,通过均值池化和最大池化操作对特征图的位置信息进行聚合,然后通过共享MLP生成通道注意特征图;随后对特征图注入空间注意力,在经平均池化和最大池化操作后将它们连接起来产生一个特征描述符,通过卷积层生成空间注意特征图。

2.2. 多尺度特征增强金字塔网络

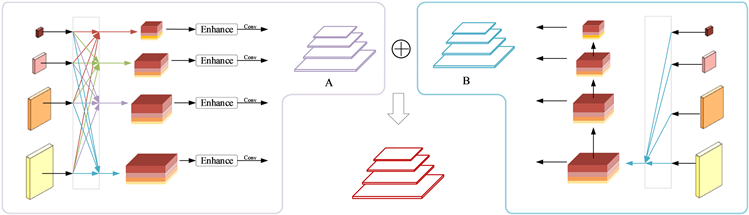

特征金字塔网络(Feature Pyramidal Network, FPN) [8] 通过自下而上的路径和横向连接获得特征图中的语义信息和位置信息以提高多尺度目标检测精度。众多研究者提出促进高低层间的信息交流等策略以增强各层次的特征表达。例如,PANet [9] ,Balanced FPN [10] ,BiFPN [11] 等。受上述研究启发,本文构建一个多尺度特征增强金字塔网络(MSFE-FPN),通过组合HRNet的多分辨率输出构建金字塔A,增强已有的特征金字塔B,然后两者相加输出多尺度特征增强金字塔。MSFE-FPN结构如图3所示。

Figure 3. Multi-scale feature-enhanced pyramid network (MSFE-FPN)

图3. 多尺度特征增强金字塔网络(MSFE-FPN)

多尺度特征增强金字塔网络的构建主要有两个步骤:组合HRNet各分辨率子网的特征输出;注入自注意力权重,强化各层特征信息。组合HRNet各分辨率子网的特征输出首先需要调整各分辨率输出到同一分辨率,再对其进行连接。调整过程包括对高层特征图进行双线性插值上采样以及对底层特征图进行平均池化下采样操作,调整过程公式表达如下所示。

(1)

其中,

为HRNet并行输出的特征图,

为双线性插值上采样操作,

为平均池化下采样操作。

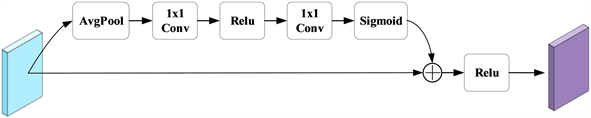

强化各层特征信息是对特征图注入自注意力权重,使网络根据全局的特征信息去加强有用的特征,淡化无用的特征。输入特征图经全局平均池化操作获得自注意力权重,将其转换到0~1范围后获得到特征图中,具体过程及公式定义如下所示。

(2)

其中,G是输入特征图,

是增强后的特征图输出,AvgPool是平均池化操作,

是卷积核尺寸为1 × 1的卷积操作,Relu和Sigmoid是激活函数(图4)。

Figure 4. Feature information enhancement structure

图4. 特征信息增强结构

3. 实验结果与分析

3.1. 实验数据集与评价指标

实验数据选自公开遥感图像数据集DIOR [12] 。由于DIOR数据集规模大、种类多,本文从中选择了五类尺度变化明显及有较多小目标的类别,包括飞机、船舶、储罐、烟囱和风力发电设备五类。各类别数量及训练、测试、验证集划分情况统计如表1所示。

使用平均精度(Average Precision, AP)和均值平均精度(mean Average Precision, mAP)作为评价指标。AP是精确率–召回率(Precision-Recall)曲线下面的面积,mAP是所有目标的平均精度的平均值。理想的目标检测网络可以在召回率增长的同时保持较高的精确率。AP和mAP的公式定义如下。

(3)

(4)

3.2. 对比实验

将本文方法与近年的经典目标检测方法进行比较实验,选择对比的经典目标检测方法包括YOLOv5、Faster R-CNN [13] 、RetinaNet [14] 、和PANet [9] 。使用AP和mAP指标对各目标检测网络的目标检测性能进行评估,检测结果如表2所示。从表中可以看出,本文方法具有最好的mAP,并且在飞机、储罐和烟囱三个类别中具有很大的优势;与RetinaNet、Faster R-CNN和PANet相比,mAP分别提高了18.96%、18.16%和13.82%。

Table 2. Comparative experimental results

表2. 对比实验结果

在上述对比实验中,YOLOv5是经典目标检测方法中表现较好的一个,从数据集中选择部分遥感图像对YOLOv5和本文方法做可视化结果对比,对比结果如图5所示。同一遥感图片使用YOLOv5时会出现漏检、误检的情况,而本文方法能够正确地检出,结合表2实验结果可以得出:本文方法能够较好的完成遥感图像目标检测任务。

3.3. 消融实验

本文所提方法中主要改进两个部分:使用加入CBAM的HRNet作为主干网络;使用MSFE-FPN网络结构。为了证明这两部分的有效性,本节进行消融实验分析讨论。对比的基线模型为使用HRNet作为主干网络的Cascade R-CNN网络,使用AP和mAP作为评价指标,所得实验结果如表3所示。

Table 3. Ablation experiment results

表3. 消融实验结果

从表3可以看出,引入CBAM后,各类别遥感目标检测平均精度均有提升,mAP提高了2.30个百分点;使用MSFE-FPN后,除风力发电设备类别有所下降外,其余类别平均精度均有提升,mAP也提升了2.38个百分点。为了证明整体结构的有效性,将CBAM与MSFE-FPN同时引入到网络中进行实验。在两个部分的共同作用下,前部分实验检测精度有所下降的风力发电设备类别提高了3.9个百分点,mAP提高了2.62个百分点。由此可见,CBAM一定程度上可以弥补MSFE-FPN的不足,这两个部分在提高网络性能过程中具有互补性。这表明着本文方法所使用的加入CBAM的HRNet和MSFE-FPN可以有效提高网络的检测性能。

3.4. 检测结果可视化

特征热力图反映了网络更侧重关注图像中的哪块区域。本文方法和原始Cascade R-CNN的特征热力图响应对比如图6所示。从图中可以看出,相较于原始Cascade R-CNN方法,本文方法对于多尺度目标、密集小目标有较好的特征响应;对于复杂背景下的储罐目标检测(红色矩形框选中区域),Cascade R-CNN方法并没有检测到目标区域,而本文方法在目标区域有正确的特征响应。

遥感小目标可用于目标检测的像素数较少,大大增加了遥感目标检测的难度。对此,筛选出验证数据集中存在遥感目标标注框小于30 × 30的遥感图像进行检测,图片示例如图7(a)所示。本文方法的检测结果如图7(c)所示。在同标注图7(b)的对比中可以看出,本文方法可以成功检出大部分遥感小目标,并且置信度都在80%以上。

4. 结束语

本文针对遥感图像目标检测中背景复杂、目标像素数少以及目标尺度变化大等问题,提出一种基于多尺度特征增强的遥感图像目标检测方法。使用HRNet网络作为主干网络并设计使用多尺度特征增强金字塔网络,增强对遥感目标位置信息提取以及多尺度特征表示;在主干网络HRNet中加入注意力机制,使网络关注有用图像区域,增强网络整体抗干扰能力。实验结果验证了本文方法的有效性,能够有效提高遥感图像目标检测精度。本文方法也有不足之处,所使用网络框架在检测速度方面检测推理较慢,后续工作将在轻量化网络模型的方向继续开展,进一步提升该方法的性能。

基金项目

国家自然科学基金天文联合基金(U1831133)、上海市科委科技创新行动计划(21S31904200, 22S31903700)、中科院空间主动光电技术重点实验室开放基金(2021ZDKF4)。

NOTES

*通讯作者。