1. 引言

随着科技的不断发展,世界迎来了信息时代,对信息的需求和利用与日俱增。信息论作为通信理论和方法论得到了广泛的研究和应用,发挥着重要作用。信源是信息的来源,其作用是直接生成可能包含信息的消息 [1] ,信源也是通信系统的重要组成部分,是通信系统信息传播的发起者,通过对信源进行编码,可以提高通信系统的有效性。

信源和信息熵是信息论的重要组成部分,那么信源之间的关系自然也是信源的重要内容,了解信源关系是必要的,只有理清关系,才能全面、正确地掌握和分析信源的特性,更好地理解信息论中的相关概念和原理。

维恩图,是19世纪英国学家Jonn Venn发明的,是在所谓的集合论数学分支中,在不太严格的意义下用以表示为集合(或类)的一种草图 [2] 。维恩图能够直观的表示事物之间的关系和运算,可用来解释信息论中各信息量间的关系。

目前各种教材中关于信源关系论述很不充分。一般将无失真信源与信息熵作为一章,包括信源特性与分类、离散信源的信息熵、离散序列信源的熵、互信息、冗余度、连续信源的熵与互信息等小节,只在互信息一节中用维恩图简单解释一下各信息熵之间的关系 [3] 。另外,在介绍互信息时常常用到信道等概念,也有教材直接将互信息内容放在信道和信道容量一章来介绍,这是很不妥的。针对这一问题,根据多年的教学分析和研究总结,本文系统地分析了信源关系,重点阐述了其在通信系统中的各种含义和启示,并采用维恩图来直观地表示。对信源间关系的理解有助于从全局上对信息论内容的理解和掌握,更有利于将信息论作为方法论来学习和应用。

2. 两个信源及其基本关系

信源往往由许多的符号消息所构成 [4] [5] ,例如英文信源,可构成不同的消息序列,称为离散序列信源,在更多的情况下都是离散有记忆的,即序列符号间相互具有相关性。

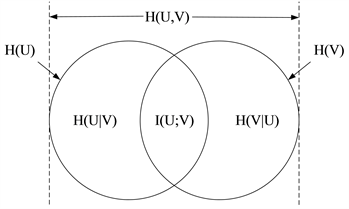

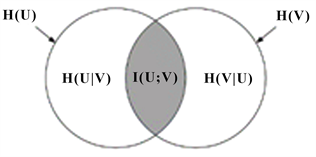

信息熵是自信息的统计平均值,联合熵和条件熵则分别是联合自信息和条件自信息的统计平均值 [6] 。互信息(也称交互熵)是信息熵与条件熵的差值,是一种消除的不确定性的度量,等于先验的不确定性减去尚存在的不确定性。用维恩图表示的两个信源间的关系如图1所示,各信息熵之间的关系可以用(1)和(2)两个公式表示。

Figure 1. Venn diagram representation of two sources

图1. 两个信源的维恩图表示

(1)

(2)

信源

和信源

的关系,根据交互熵

的有无,可分为相关和不相关,相关还可以分为相交和包含;根据信息熵的性质,还可分为联合、条件和交互三种关系。所谓联合关系,实质上就是两信源的联合,由信源联合熵

体现;条件关系实质上是将一个信源看作是另一信源的条件,由信源条件熵

、

体现;交互关系实质上就是两个信源的相交,由信源互信息

体现。

在信息论中,通信系统模型由信源、信道、信宿以及提高系统性能的编码器、译码器组成,如图2所示,信息论课程的教学内容则与之相对应。

在通信系统中,信源与信宿通常具有相同的特性,其关系也是相对的,当多个信道串接时,处在中间的信源既是后一信道的信源,也是前一信道的信宿。一个或者多个信源经过变换或处理可以产生新的信源,另外,某种限制条件还可以等效为某种信源特性,信源关系可以隐含着某种信息处理的方式,即通信系统中的某种概念或含义。

3. 信源联合关系的分析与启示

(一) 信源联合的方式

信源之间可以相互联合,由多个信源组合成一个新的信源。在时间上由多个单个消息信源组合而成的信源则称为序列信源,此时相互的关联通常称为记忆性。在空间上由多个单个消息组合成一个新的消息,对应的新的信源则称为扩展信源,例如由字母构成单词,由原来的以字母为消息,变为以单词为消息。但无论哪种联合方式,其联合熵是一样的。

(二) 信源的联合熵

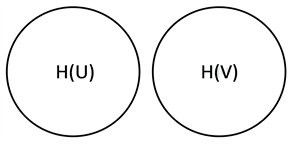

两个信源可以有关联,也可以无关联。两个离散无关联信源如图3所示,反应在维恩图上,两个圆没有相互重叠的部分,此时信源的联合熵为两个信源熵相加。

在多数情况下,信源发出的序列大多是有关联的,如图4所示,信源间相互存在约束和依赖性。在维恩图中表现为两个圆有相互重叠的部分,重叠的面积反映了它们关联的大小。可以看出

,信源的联合熵等于信源

的信息熵和

已知情况下信源

的条件熵之和。

(三) 信源的冗余度

在通信系统中,研究信息熵的重要目的是尽可能使每个信源符号携带的信息量越大,传输信息的符号数越少,传输效率越高。将图3和图4进行比较可以看出,二个离散有关联信源的联合熵小于二个离散无关联信源的联合熵,即

。因此,信源间的相关度反映了信源的冗余现象,常用信源冗余度来表示信源在实际发送信息时所包含冗余信息的程度,可以通过无失真信源编码方式来压缩信源冗余度,提高传输效率。

4. 信源条件关系的分析与启示

(一) 保留的信息熵

从图4中可以看出,信源

和信源

相互关联时,两者之间存在相交,条件熵可以反映两信源之间的关联程度,其本质上是由条件概率来体现。当

确定时,

的不确定性受到

的限制也就随之下降,下降量就是相互关联的那一部分,此时信源

仍保留的信息熵即为条件熵

,反之亦然。

(二) 信息熵的增量

从图4中可以看出,如果将信源

和信源

合并成为一个新的信源时,新的信源的信息熵就从

变成了联合熵

,信息熵增加了,信息熵的增量部分就是条件熵

。对比图3和图4可以看出,条件熵总是小于等于无条件熵,即

。

(三) 信道的传输特性

在通信系统中,可以将图4中的

看成信源、

看成信宿,则

表示信宿收到信源发出的消息后所得到的信息量,反映了信道的传输性能。从图中可以看出:

,条件熵

表示信源在传输过程中损失的信息量,即信道中损失的信息量,所以也称损失熵。另一方面,

,条件熵

表示确定信道中某种噪声所产生的信息量,所以也称噪声熵。根据事件间关系的类型和信道的特性来分析,存在四种特殊的信道类型,如图5所示。

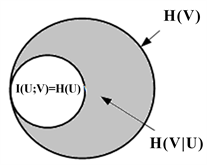

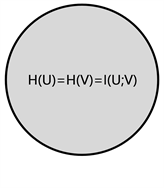

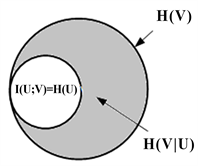

图5(a)表示信源和信宿相互独立,图中两个圆没有重叠,即

。可以理解为信源输出全在信道上损失了,称为全损离散信道。

图5(b)表示一种包含关系,信宿收到了信源的全部信息,但收到的信息量大于信源的信息量,即损失熵为零

,噪声熵

,称为有噪无损信道。

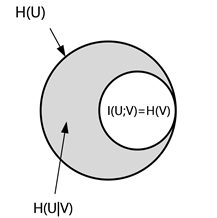

图5(c)表示信宿和信源是一一对应的关系,信宿获得的信息量就是信源发出的信息熵,即

,此时信道的噪声熵和损失熵都为零,称为无噪无损信道。

图5(d)表示另一种包含关系,信宿只收到信源发出的部分信息,即

,但

,即此时噪声熵为零,损失熵不为零,称为无噪有损信道。

(a) 全损离散信道 (b) 有噪无损信道

(a) 全损离散信道 (b) 有噪无损信道

(c) 无噪无损信道 (d) 无噪有损信道

(c) 无噪无损信道 (d) 无噪有损信道

Figure 5. Venn diagrams for four special channels

图5. 四种特殊信道的维恩图

5. 信源交互关系的分析与启示

(一) 信源间的相关度

根据上文所述,信源

和信源

相互关联时,两者之间相交,存在公共部分,可以反映两信源的关联或约束程度,即如图4中的互信息

。无论从信源

还是信源

角度来看,其关联度都是一样的。

(二) 信道的传输率

在通信系统中,研究信道的目的是为了增大信道的传输率,互信息

反映的就是信宿接收到

后平均每个符号所获得

的信息量,也就是信道的信息传输率,即

。信源输出的是信息熵,真正被接收者收到的信息量其实是互信息。

对于一个固定信道总存在一个特殊的信源,使信道中平均每个符号所传输的信息量最大。在信息论中将这个最大的传输率定义为信道容量

,

,信道容量是信道特有的属性,反映了信道的特性。

(三) 编码器的特性

在通信系统中,采用编码技术来提高通信系统的性能,如图6所示,可以将

看成编码器的输入,

看成是编码器的输出,则

和

的关系反映了编码器的特性。

(a) 理想的加密编码 (b) 实际的加密编码

(a) 理想的加密编码 (b) 实际的加密编码

(c) 限失真信源编码 (d) 信道编码

(c) 限失真信源编码 (d) 信道编码

Figure 6. Venn diagrams for three types of encoding

图6. 三种编码的维恩图

图6(a)表示编码输入与输出相互独立,互信息为零,对于加密编码而言,即表示在无密钥时从信道接收到的信息看不到任何关于信源的信息,是理想的加密编码性能。

图6(b)表示实际的一般加密编码性能,互信息不为零,存在一定的相关性,给破译创造了条件,降低了保密性能。

图6(c)表示输出信源的信息熵变小了,只是输入的一部分信息,可用来表示限失真信源编码。限失真信源,即失真有限的信源,用信息率失真函数

来度量 [7] 。实质上就是选择一种编码方式,如合并和删除,从无失真信源中取出满足条件的部分信息构成新的限失真的信源,实现信源压缩。其本质上也等效于无噪有损信道,如图5(d)所示。

图6(d)表示输出信源的信息熵变大了,可以是信道编码,增加了监督信息,从而为差错控制提供了条件,提高系统可靠性。

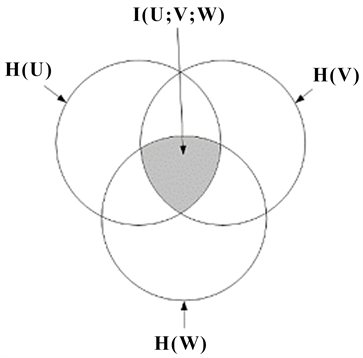

6. 三个信源的关系分析与启示

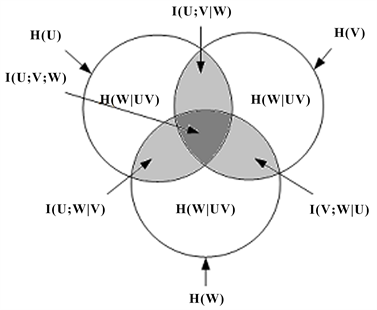

(一) 三个信源及其信息熵

根据上述思路,三个信源的维恩图如图7所示,图中的三个圆的面积分别表示三个信源的信息熵,即H(U)、H(V)和H(W),同时标出了对应的各类信息熵 [6] 。三个信源同样也有联合、条件和交互等关系,由于联合关系与两个信源类似,所以重点分析条件和交互关系。

Figure 7. Venn diagrams of three sources

图7. 三个信源的维恩图

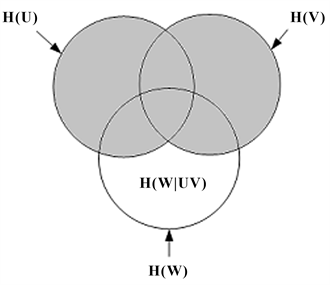

Figure 8. H(W|UV) under joint conditions

图8. 联合条件下的熵H(W|UV)

(二) 条件关系

(1) 联合条件下的熵

如果将其中的两个信源联合成一个新信源,并作为条件,此时则等效为两个信源时的条件关系,条件熵

如图8所示,具体分析可参照两个信源的条件关系。

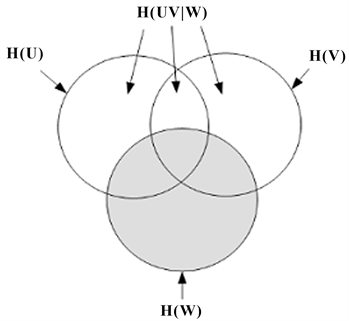

(2) 条件下的联合熵

如果将其中一个信源看作条件,则可以求另外两个信源的联合熵,如图9所示。在信源

已知的条件下,信源

和信源

的联合熵为

,该结果与两个信源的联合熵类似,只是附加了一个条件限制,再次表明条件就是限制,限制就是确定。

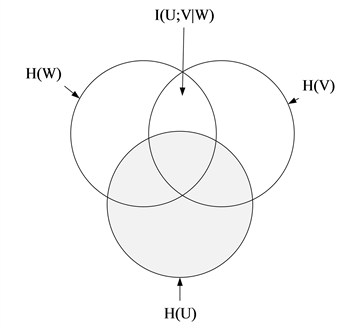

(3) 条件下的互信息

条件互信息是指在某种条件下信源间的互信息,如图10所示,条件互信息

的含义是在信源

确定的情况下,信源

和信源

的互信息。从图中可以看出条件下的互信息明显变小了,除了有条件之外,两个信源时互信息的关系对于条件互信息也适用。

在通信系统中,信源

也可以是某种具体条件,限制消息概率的分布形式,具有等效的信源特性,从而等效为某种条件下两个信源的关系。通常表现为某种条件下的通信系统性能的优化,如信道容量、信道容量代价函数。

Figure 9. Joint entropy under condition

图9. 条件下的联合熵

Figure 10. Conditional mutual information I(U; V|W)

图10. 条件互信息I(U; V|W)

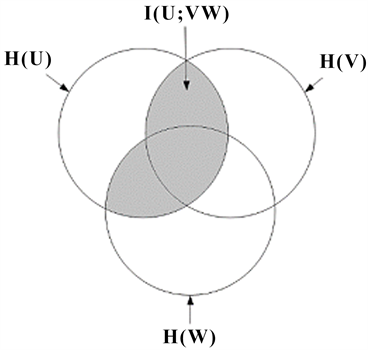

(三) 交互关系

(1) 信源间的相关度

三个信源时,信源与信源之间的关系就可以分成一个信源和两个信源之间的关系或者是三个信源之间的关系,同样可以用互信息来描述信源间的相关程度或相互约束程度,如图10~12所示,其中关于条件互信息已上文讨论过了。

如果将其中两个信源看成一个整体,三个信源就等效为二个信源。如图11所示,将信源

和信源

看成一个整体,信源

和信源

就变为二个信源的关系了。此时互信息的形式就和二个信源时相似,可以得到联合互信息

,关系式为:

(3)

(4)

Figure 11. Joint mutual information I(U; VW)

图11. 联合互信息I(U; VW)

Figure 12. Mutual information of three sources I(U; V; W)

图12. 三个信源的互信息I(U; V; W)

对于普通的三个信源,那么信源间的相互关系和互信息如图12所示。三个信源间的相关程度就是互信息

,从图中可以得到互信息为:

(5)

因此,三个信源间的互信息所对应的关系与两个信源时相似,只是多了某些限制因素,所以同时具有互信息的其它基本关系,如限失真信源。

(2) 多用户信道

在通信系统中,可以将三个信源看成是一个信源和两个信宿。如图11所示,将

看成是信源,

和

看成是信宿,此时

表示的是信源

和信宿

的互信息,因此可以看成是一进二出信道或分集接收。从图中可以看出,联合信宿收到信源的信息量明显大于单个信宿时的信息量,也体现了信息不增原理。同理,也可反过来看成是两个信源和一个信宿,此时可看成是两进一出信道或多路发送,通过多路发送可以减少信道带来的损耗,使信宿获得更多的信息。

(3) 串联信道

在通信系统中,通常信源

先传输给

,

再传输给

,如图12所示,就是由两个信道构成的串联信道。此时信宿

获得信源

的互信息即为

。可以看出,这种传输方式信宿

收到的关于信源

的信息量通常会小于信源直接传输给信宿的信息量,同样也体现了信息不增性原理。在实际通信中常使用串联信道,如微波中继通信。

7. 结束语

本文针对目前信息论教材中关于信源间关系论述不充分的问题,根据多年的教学研究,采用维恩图表示法,系统分析了信源的联合、条件和交互三种关系,重点阐述了其在通信系统中的各种含义和启示,反映了信源、信道和编码的信息处理本质,从信源关系角度认识和理解信息论的研究内容。通过维恩图方式描述信源关系,不仅能够轻松理解信息论中一些重要概念和含义,更能将信源、概率、集合和信息熵联系起来理解信息论。关于信源关系的内容,作为信息论的重要组成部分,并进行分析研究,有助于从全局上加深对信息论内容的理解和掌握,也更有利于将信息论作为方法论来学习和应用。

致谢

本文系2023年度浙江省“十四五”研究生教学改革项目——“基于应用型人才能力提升的《信息论与编码》课程改革与实践”(建设项目:2023-87)的成果之一。