1. AIoT人工智能物联网简介

1.1. AIoT概念

AIoT (人工智能物联网)是人工智能(AI)与物联网技术(IoT)相融合的产物。AIoT以不同的维度来收集物联网产生的数据,将海量的数据存储于云端或边缘端,再通过大数据分析,以及更高形式的人工智能,实现万物智能数据化联网 [1]。

1.2. AIoT和边缘计算介绍

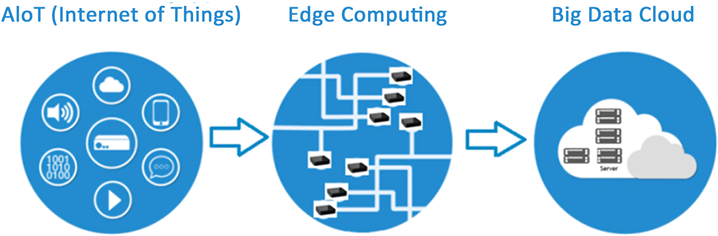

随着人工智能技术的井喷式发展,智能物联网(AIoT)概念被提出,物联网系统将各种传感器信息采集之后,不再是简单的进行数据传输在云端强大的中央计算机服务器上处理,而是在终端设备、边缘服务器上,通过人工智能算法对数据进行智能化分析 [1]。AIoT边缘计算是物联网和人工智能AI系统的融合。例如现在计算能力增强的图像采集处理终端,交给云端计算机分析的数据量较少,而是在许多边缘终端上就近完成大部分图像计算分析工作。AIoT边缘计算架构如图1所示:

Figure 1. AIoT edge computing architecture

图1. AIoT边缘计算架构

这种网络架构降低了数据在终端和云端的延迟,从而提高了数据本地化处理速度,保护了数据隐私,对云资源的占用较少,降低了云服务的成本。

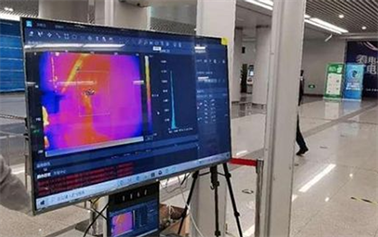

边缘计算的典型用例在新冠肺炎防控上得以体现。在新冠疫情期间,公共场所的防疫措施借助AIoT等新技术进行人员筛查。运行在边缘设备上的人工智能算法处理高清摄像头采集到的大量人体目标的温度测量数据和视频图像数据,检查人们是否佩戴口罩或体温偏高,迅速生成警报和提示信息。随着边缘处理能力的增加,联网设备和物联网(IoT)的不断扩展,检测和处理任务越来越多地转移到物联网的网络边缘。边缘计算在防疫领域的应用如图2所示:

Figure 2. Application of edge calculation in epidemic prevention

图2. 边缘计算在防疫领域的应用

2. 物联网AIoT与艺术结合的构想

根据目前笔者所在教育单位所提出的“科学与艺术结合”的教学和科研构想,笔者提出了AIoT教学和实验条件建设思路。未来的物联网技术课程可引入高性能的人工智能边缘计算开发套件,构建物联网 + AI边缘计算 + 智能交互的AIoT解决方案 [2],将基于AIoT的交互式技术融入艺术产品设计,实现科学与艺术的结合。

2.1. 交互式技术在AIoT的应用

交互式技术是AIoT物联网和艺术产品结合的重要手段。实现智能交互艺术产品,需要科学技术的跨专业支撑。笔者调研了艺术与科学融合的产业现状,分析了教育级科技平台和艺术作品实现跨专业融合的可行性。

随着科技的不断发展和艺术的不断丰富,科技和艺术在许多领域发生了碰撞 [3]。在当今信息时代,艺术家开始将科技手段和工具融入创作,科技与艺术的结合激荡出更多元的艺术表现与互动跨领域特质,在表现形式与内容上更强调互动性,把跨领域创作带向更多元化及更开放的发展。装置艺术、实验音乐、声音影像、空间交互,充分利用空间并与观者建立互动。给观者带来全新体验。

国内以“低科技艺术实验室”为代表的先驱,已经在科技与艺术的结合创作方面有所尝试。“低科技艺术实验室”专注于艺术与科学之间的跨学科联系,探索混合媒介环境中的科技应用,作品涵盖:虚拟人工生命体、互动LED装置、动态机械装置、互动影像、游戏媒介等。手势交互式灯光控制艺术作品如图3所示:

Figure 3. Gesture recognition interactive light control art works

图3. 手势识别交互式灯光控制艺术作品

2.2. 交互式AIoT教学实验设计

产业内从事AIoT科技与艺术结合项目的技术门槛较高,投入规模较大。从教育行业实际条件来看,扩展升级现有的物联网教学设备进行AIoT交互式应用教学和科研,与艺术产品设计融合的可行性较高。

笔者提出使用低成本的智能交互式控制的技术开展物联网AIoT实验教学,采用手势传感器、嵌入式系统、图像识别处理技术设计教学实验内容。

2.2.1. 基于手势传感器的手势识别实验设计

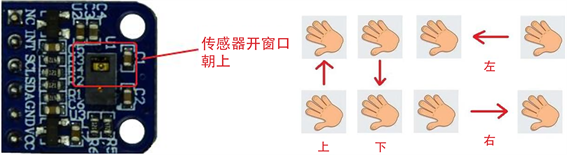

该实验要求学生设计一套基于手势传感器和STM32单片机的交互系统,该系统能通过手势控制灯光效果和音乐的播放。手势传感器和STM32单片机的硬件组合如图4所示:

Figure 4. Combination of gesture sensor and single chip microcomputer

图4. 手势传感器和单片机的组合

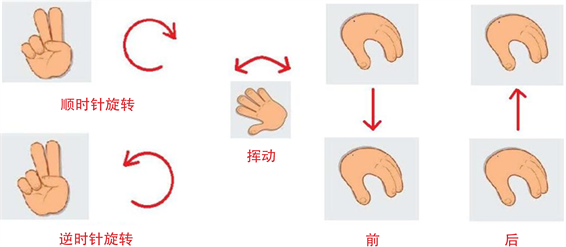

实验原理是使用内部集成了光学数组式传感器的PAJ7620U2芯片,以使复杂的手势和光标模式输出,对九种手势进行识别,支持上、下、左、右、前、后、顺时针旋转、逆时针旋转和挥动的手势动作识别,对持手势接近作识别,将识别信息交给单片机进行处理。手势传感器识别的各种手势如图5和图6所示:

Figure 5. Gesture sensor recognizes “up, down, left and right” gestures

图5. 手势传感器识别“上、下、左、右”手势

Figure 6. “Clockwise, counterclockwise, waving, front and back” gesture recognition

图6. “顺时针、逆时针、挥动、前、后”手势识别

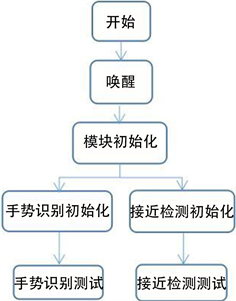

STM32单片机唤醒手势传感器开始工作,根据检测结果接收手势传感器发出的9个手势识别的中断标志输出,由中断服务函数控制灯光效果和音乐播放。单片机控制手势传感器的工作流程如图7所示:

Figure 7. Workflow of gesture sensor

图7. 手势传感器工作流程图

该实验要求学生了解手势传感器PAJ7620模块的功能特点,掌握手势传感器PAJ7620模块的使用方法,掌握基于标准库或基于寄存器的手势传感器编程控制方法,掌握手势识别模块和STM32单片机之间的IIC接口编程使用方法,掌握STM32单片机控制外围灯光和音乐播放器件的编程方法。最终实现基于手势传感器的手势识别交互系统的设计。

基于手势传感器的交互手势识别系统适用于各类互动交互艺术产品、智能家居等应用场景。试想一下,挥一挥手,打开灯光,挥一挥手,打开音乐,一切尽在弹指间。

2.2.2. 基于OpenCV的手势交互实验设计

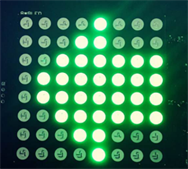

该实验要求学生设计一套基于OpenCV的手势交互系统,要求学生采用配置了OpenCV环境的树莓派结合摄像头进行手势捕捉和识别,能识别手的上下左右等多个方向的手势指向,树莓派控制LED点阵模块显示手势方向。该系统如图8所示:

Figure 8. Raspberry pie OpenCV gesture interaction system

图8. 树莓派OpenCV手势交互系统

该实验要求学生了解OpenCV开源计算机视觉库的基本概念,掌握OpenCV的开发接口的使用方法,能使用Python编程语言结合OpenCV进行实时动态图像处理操作,掌握树莓派控制外围器件的编程方法,实现完整的交互式控制。

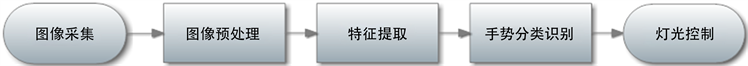

实验原理是通过OpenCV对样本手势图片进行特征检测和训练分类,对输入的手势进行特征识别。系统的工作流程依次是图像采集、图像预处理、特征提取、手势的分类识别、灯光控制。通过树莓派连接的摄像头获取手势照片,首先降低图片像素值,选取具有代表性的手势图片。再从环境背景中根据皮肤颜色检测人手所在区域,对图像进行二值化处理。采用边缘检测提取手势的边缘图像和轮廓矩阵,对手势进行特征提取,生成手势的特征向量,作为训练样本对手势分类器进行训练。用训练好的手势分类器对摄像头输入的手势图像处理得到特征向量进行分类,得到手势所属类别,获得手势识别结果。最后根据手势识结果通过树莓派的GPIO接口和外围器件对LED点阵进行动态显示控制,或交由树莓派的物联网通讯使能其他无线终端完成相关控制功能。OpenCV手势交互系统工作流程如图9所示:

Figure 9. Workflow of OpenCV gesture interaction system

图9. OpenCV手势交互系统工作流程

在实验中,学生将学习基于Python语言的OpenCV编程使用方法,掌握图像变换的阈值处理、边缘和轮廓检测、模板训练、模板匹配、特征检测、深度学习技术,掌握树莓派的GPIO外设控制编程方法,最终实现基于OpenCV的手势交互系统的设计。

2.2.3. 基于OpenCV的人脸识别交互实验设计

该实验要求学生设计一套基于OpenCV的人脸识别交互系统。要求学生采用配置了OpenCV环境的树莓派结合摄像头进行人脸捕捉和识别,能根据人脸识别结果进行艺术装置的开闭控制。该系统人脸识别效果如图10所示:

Figure 10. Raspberry pie OpenCV face recognition

图10. 树莓派OpenCV人脸识别

实验原理是使用OpenCV自带训练好的Haar级联分类器数据进行人脸检测。使用OpenCV自带的haarcascade_frontalface_alt.xml人脸特征文件作为人脸分类器数据文件 [4],能够检测出树莓派摄像头获得的实时动态图像中的人脸,根据不同的人脸用不同颜色的矩形框起标识区分。使用EigenFaces特征脸识别器对已知人脸图像训练模型,再通过训练好的模型对未知人脸图像进行识别,确认其身份,通过树莓派控制物联网内的艺术装置的开闭。OpenCV人脸识别系统的工作流程如图11所示:

Figure 11. Workflow of OpenCV face recognition interactive system

图11. OpenCV人脸识别交互系统工作流程

在实验中,学生将学会Haar级联分类器检测人脸的编程方法,掌握人脸识别器EigenFaces的编程使用方法,结合树莓派的GPIO控制外部开关器件,或通过物联网通讯使能其他控制终端实现开关功能,最终实现基于OpenCV的人脸识别交互系统的设计。

2.2.4. 基于Yolo的AI识别交互实验设计展望

目前笔者正在研究英伟达高性能边缘计算技术的应用。英伟达Jetson系列套件的高性能GPU配合官方优化的CUDA,可并行处理TensorFlow、PyTorch、Caffe/Caffe2、Keras、MXNet等神经网络,比如通过Tensor RT加载模型,进行推理运算效率很高,树莓派Cortex-A72核心的性能和算力相对有限。笔者计划采用英伟达Jetson Nano套件,使用Yolo进行AI图像数据分析,开展手姿识别估计分类、动态识别跟踪、人体动作姿态识别预估的应用研究,并设计相关教学实验内容。基于Yolov4的手姿识别效果如图12所示:

Figure 12. Hand posture recognition effect based on Yolov4

图12. 基于Yolov4的手姿识别效果

基于AIoT的边缘计算技术,结合机器学习技术 [5],开发识别交互控制功能产品,是实现科学与艺术结合的入门抓手,技术门槛和投入规模相对较低。在此基础上积累一定的教学和工程经验,再向复杂的声光电控制延伸。未来还可以将AIoT边缘计算、交互式控制和VR/AR技术结合,连接现实世界和虚拟世界,探索AIoT与艺术结合的高阶应用教学和科研。

2.3. 物联网课程AIoT建设思路

物联网技术课程应紧密结合物联网与人工智能相关专业理论教学,在现有物联网综合实验平台的基础上增设人工智能及交互式设计教学实验平台,采用人工智能计算机视觉技术、交互式技术、物联网技术的融合立足于基础教学,开展科学与艺术的融合的跨界工程教学和科研。通过设置理论教学内容和实验项目环境来培养学生对实际AIoT物联网、人工智能、交互式技术应用项目的实践操作能力,培养学生基本的AIoT物联网应用开发能力,增强学生的创新实践能力,提高学生的学习主动性和科技创新能力,鼓励科学与艺术结合的跨界工程应用探索。