1. 引言

近红外图像广泛应用于厂房、森林的热源探测、医用成像、安防检测、农业检测以及工业生产中温度测量与过程控制、近红外光谱分析等领域。众所周知,近红外图像是灰度级单通道图像,存在分辨率和对比度低,边缘不清晰,视觉效果不理想,信息识别困难以及难以满足实际使用的需求等问题。因此,需要对近红外图像进行彩色化处理,以获取更多的图像信息用于后续应用。

目前,近红外图像彩色化的研究方法有基于偏微分方程、基于图像分割以及基于图像融合等方法。本文重点关注基于图像融合的近红外图像彩色化方法,该方法可进一步分为三类 [1] :有监督、半监督、无监督。

有监督方法是通过反向传播的模型对有标签的近红外图像和彩色图像训练,然后再用训练好的模型融合原始近红外的图像,最终得到融合后的彩色图像。Hao Zhang等人提出一种基于梯度变换的残差学习网络 [2] ,该方法将残差学习与融合网络结合,可以缓解深度网络中的梯度消失问题。但是深度的过度增加不会提升性能,反而会增加训练时长。为此,Menghui Jiang等人提出了一种基于残差的卷积神经网络 [3] ,该网络加入的空间–通道混合注意力模块可以减少训练时间。但是,卷积运算的分布比较局限,即使在深度网络中,也无法获得全局信息。Lin He等人提出一种感知泛锐化神经网络 [4] ,它在卷积神经网络中构建一个双分支结构分别获取近红外图像和彩色图像的信息。这种网络虽然能够分别提取信息,但忽略了输入图像之间的互补性,以至于提取特征时会有疏漏。Jianwen Hu等人提出一种基于动态卷积神经网络的多尺度泛锐化方法 [5] ,多尺度动态卷积可以在不同尺度上提取图像的细节特征,有助于对细节的捕捉。但是,该方法会使计算量大大提高。有监督的学习方法训练过程都依赖于标签图像,需要消耗大量的人力,为了减少人工标注的成本,半监督的方法被提出。

半监督方法是通过少数有标签的近红外图像与大量无标签的近红外图像和彩色图像进行融合训练。Sergio Vitale等人提出了一种在卷积神经网络泛锐化模型中加入跨尺度学习的半监督方法 [6] ,该方法将有标签的融合结果与无标签彩色图像一起输入网络中训练,提高了网络的融合性能。除此之外,还有学者利用复合损失函数来实现半监督学习。Huang Shanshan等人提出了一种采用双胞胎结构的半监督图像融合方法 [7] ,该方法通过设计结合WGAN [8] 和cGAN [9] 损失以及峰值信噪比(Peak Signal to Noise Ratio, PSNR)损失的复合损失函数实现半监督学习。虽然半监督方法已经减少了有标签图像的使用,但当有标签图像与原始无标签图像的分辨率和尺度不一致时,半监督方法适用性降低。

无监督方法无需人工标注,很大程度地减少了人力资源的消耗。Changsheng Zhou等人提出了一种无监督的感知泛锐化方法 [10] ,该方法不需要通过退化图像进行训练,而是基于自编码和感知损失进行训练,但是得到的图像分辨率较低,图像质量差。Shuyue Luo等人提出了一种基于卷积神经网络的无监督泛化方法 [11] ,来解决信息不能在简单堆叠的卷积架构中有效流通的问题,但是该方法同样存在生成图像分辨率低、质量差等问题。

上述研究表明,基于融合的近红外图像彩色化研究都存在融合过程影响图像质量和降低图像分辨率的问题。为此本文设计了一种图像融合和超分辨率重建相结合的算法,用于近红外图像的彩色化。整体的图像融合框架设计采用DenseFuse的网络结构,在其中加入通道注意力机制模块、亮度增强模块以及在融合图像后加入超分辨率重建模块。通道注意力机制模块的加入可使图像的细节特征更好地被捕捉,亮度增强模块的加入使得彩色化后的图像亮度提升,图像超分辨率重建模块的加入使得彩色化后的图像细节被进一步刻画,可以极大程度地克服融合过程中对图像分辨率造成的损失。文中提出的算法在KAIST数据集和IVRL RGB-NIR数据集上进行了验证,通过和其他几个网络的比较以及消融实验,验证该算法的有效性。

2. 本文算法

本文提出的基于图像融合和超分辨率重建相结合的近红外图像彩色化算法的流程图见图1,该算法由两部分组成。第一部分是基于融合的近红外图像彩色化模型,是对输入的近红外图像和RGB图像进行融合。第二部分是融合后的图像超分辨率重建,用于提升第一部分输出图像的分辨率。

2.1. 基于融合的近红外图像彩色化模型

该部分是对输入的近红外图像和RGB图像进行融合,得到相比RGB图像信息更加丰富的彩色图像。该部分由编码器、融合层、解码器以及亮度增强层组成。其中解码器部分是由4个带有3 × 3滤波器的连续卷积层构成,其主要功能是对输入图像重建。其余3个组成部分将分别在2.1.1~2.1.3中详细介绍。

2.1.1. 编码器

如图1所示,近红外图像和RGB图像作为输入图像

、

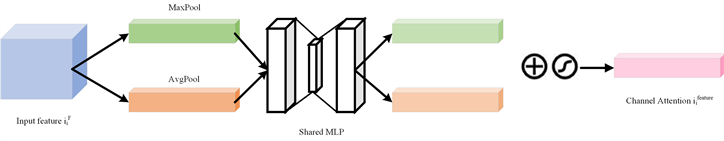

,其中RGB图像可视为由3个通道的灰度图像组成。将

、

输入到编码器中,编码器由一个包含3 × 3卷积运算的滤波器和一个密集块构成。其中滤波器用于对输入图像的信息进行粗提取,大小为3 × 3、步长为1,对输入图像尺寸无限制,也就是说任何尺寸的图像都可作为输入图像。密集块由3个卷积层构成,每个卷积层的输出作为下一个卷积层的输入,旨在尽可能地在编码网络中保留图像的深层特征。如图2所示,从密集块输出的特征图作为通道注意力机制模块的输入,先进行全局池化和平均池化,然后将得到的全局池化和平均池化结果传入到多层感知机(Multi-Layer Perceptron, MLP)中学习,最终将MLP输出的结果进行加和处理并经过Sigmoid函数进行映射处理,得到最终的通道注意力特征值,见式1:

(1)

Figure 2. Channel attention mechanism module

图2. 通道注意力机制模块

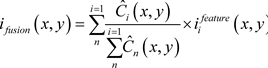

2.1.2. 融合层

融合层采用了

融合 [12] 的方法来融合编码器获得的特征图

,见式2:

(2)

(2)

其中

表示融合的特征图,

表示特征图和融合图中的对应位置,活动水平图

将基于块的平均算子和

计算,见式3:

(3)

(3)

其中

是初始活动水平图,由

的

计算得出,见式4:

(4)

2.1.3. 亮度增强层

首先将融合后的彩色图像

由RGB颜色空间转为HSV颜色空间表示,见式5-9:

(5)

(6)

(7)

(8)

(9)

然后通过式10计算整个图像的亮度平均值

。

(10)

最后,根据

对

进行归一化并线性变换,将分位值拉伸到0到255,得到亮度增强后的图像

。

2.2. 图像超分辨率重建模型

由于融合后的图像存在分辨率低和边缘模糊的问题,本文对融合后的图像进行超分辨率重建,用于提升融合后图像的分辨率。图像超分辨率重建是通过对图像特征的多层次提取和重建,逐步提升图像的分辨率。基于深度残差的超分辨率重建方法 [13] 是将融合后得到的图像

经过卷积和残差处理,在卷积网络中堆叠多个滤波器,对图像进行特征提取,然后再通过上采样处理逐步提升图像的分辨率,获得信息更加丰富的超分辨率彩色图像。但是,当特征图增加到一定数量后,在训练过程中会出现数值不稳定的问题。为解决该问题,本文在残差汇合之前对残差进行缩减。如图3所示,本文在卷积层后加入缩放激活层 [14] ,取

区间内的缩减常数,以此来减少网络输出的方差,从而增加模型的稳定性,同时也可避免模型的过拟合问题。

缩放激活层的计算,见式11:

(11)

式中

,

为融合后得到的图像,

为经过缩放激活处理后的图像。

3. 实验与结果分析

3.1. 实验配置与参数选择

本实验软硬件配置分别为:CPU处理器为Intel Core i9-9900K,内存为32 G,GPU处理卡为NVIDIA GTX 1080 Ti,操作系统为Windows 10,深度学习的网络框架为Pytorch。图像融合训练参数设置为:输入图像大小256 × 256,批次大小设置为4,迭代次数为4,学习率设置为

。图像超分辨率重建训练参数设置为:批次大小设置为16,学习率设置为

,滤波器个数为32,特征通道数量为256,上采样因子为4。

3.2. 实验数据集

本文算法在公开的KAIST [15] 数据集和IVRL RGB-NIR [16] 数据集上进行了验证。

KAIST数据集主要包括白天和夜晚的韩国校园、道路和城市街道场景。KAIST数据集中的每张图片都由一张可见光图片和与之对应的长波红外图像组成。它是由一个全局快门彩色相机(Point Grey Flea3)和一个热相机(FLIR-A35)同时拍摄。彩色相机具有640 × 480像素的空间分辨率,热相机具有320 × 256像素的空间分辨率。由于彩色相机的视野比热敏相机大,所以在预处理部分对近红外图像和RGB图像都进行剪裁,最后得到的图像大小为256 × 256像素的图像对。在试验中,训练集由50172对在全天候采集的可见光与长波红外配对图像组成。测试集由2252对可见光与长波红外配对图像组成,其中的1455对图像是在白天采集得到的,其余的797对图像在夜间采集得到。

IVRL RGB-NIR数据集是一个开源数据集,该数据集有477对在户外拍摄的红外图像和彩色图像,共9类场景组成。本文的测试集由50对图像组成,训练集由300对图像组成,验证集由90对图像组成。

3.3. 评价指标

本文使用结构相似性(Structural Similarity, SSIM)和峰值信噪比(Peak Signal to Noise Ratio, PSNR)来评估生成的RGB图像的质量。

PSNR是用来评价两幅图像相比质量的好坏,即失真情况。这两幅图像分别为原图像和经图像重建或者压缩后等图像处理方法的图像。PSNR越高,图像失真越小。PSNR [17] 的计算公式见式12:

(12)

其中MAX为图像的最大像素值。

SSIM公式是从三个方面衡量两个图像采集的RGB彩色图像x和生成的彩色图像y之间的结构相似度,分别为亮度,对比度和结构,SSIM [18] 的计算公式见式13:

(13)

其中

和

为x和y的平均值用于亮度测量,

和

为x和y的标准差作为对比度测量,

为x和y的协方差用于结构测量,C为正值常数,用于防止公式出现除0异常。

3.4. 结果与分析

本文算法分别在KAIST数据集和IVRL RGB-NIR数据集上进行实验,并与其他算法进行比较分析。同时,还在KAIST数据集上进行消融实验。

3.4.1. 基于KAIST数据集的比较和分析

基于KAIST数据集的客观对比实验结果见表1。本文算法的PSNR值达到20.617,SSIM值为0.882。DenseFuse [12] 算法的PSNR和SSIM值分别为8.688和0.470。本文算法与DenseFuse算法相比,PSNR值提升了137.91%,SSIM值提升了87.66%。这两个指标的值越大表明图像的质量越高,还原度越高。通过客观的数据对比结果可以看出,本文算法在近红外图像彩色化的结果上有很大提升。

Table 1. Comparative experimental results based on KAIST dataset

表1. 基于KAIST数据集的对比实验结果

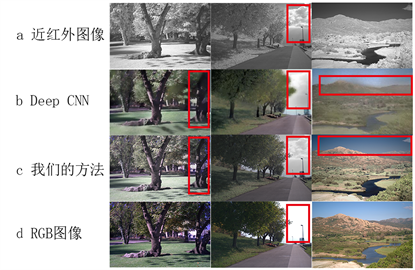

本文在KAIST数据集中随机选取了几组近红外图像和对应的RGB彩色图像,并与DenseFuse [12] 算法得到的彩色化图像和本文算法得到的彩色化图像进行了对比,如图4所示。以图中由红框标记的区域为例,与DenseFuse算法相比,本文算法能将近红外图像中的有效信息与RGB彩色图像中的颜色信息很好的融合,得到的彩色化图像很好地弥补了RGB彩色图像所缺失的细节信息,同时对图中物体的边缘刻画也更加清晰。通过主观可视化的对比可以看出,由于本文算法中加入了亮度增强模块和超分辨率重建模块,本文算法得到的彩色化图像在整体图像亮度和分辨率上都更好。

Figure 4. Partial visualization results on the KAIST dataset

图4. KAIST数据集上的部分可视化结果

3.4.2. 基于IVRL RGB-NIR数据集的比较和分析

本文引用了U-net [19] 、CNN-PL [20] 、NIR-GNN [21] 算法文中基于IVRL RGB-NIR数据集的实验结果,并与DeepCNN [22] 和本文基于该数据集进行实验得到的客观数据结果作了对比,见表2。本文算法的PSNR值和SSIM值分别为18.295和0.796,本文算法的PSNR值除低于DeepCNN算法外,皆高于其他算法。

Table 2. Comparative experimental results based on the IVRL RGB-NIR dataset

表2. 基于IVRL RGB-NIR数据集的对比实验结果

图5展示的是本文算法与DeepCNN算法基于IVRL RGB-NIR数据集的主观可视化结果,可以看出本文算法在得到的近红外图像彩色化结果能将近红外图像中的有效信息与RGB彩色图像中的颜色信息很好地融合,并拥有更高的图像质量和分辨率。

Figure 5. Partial visualization results on the IVRL RGB-NIR dataset

图5. IVRL RGB-NIR数据集上的部分可视化结果

上述实验结果表明,本文算法在KAIST数据集和IVRL RGB-NIR数据集上都有很好的表现,得到的近红外图像彩色化结果除了具有较好的彩色信息外,还拥有比常规RGB图像更丰富的细节信息。同时,在图像的层次与细节表现、边缘清楚度和锐度方面,显著优于大多数算法得到的结果。

3.4.3. 消融实验

为了验证本文算法各部分模块皆有利于近红外图像彩色化的图像质量提升,本文分别在KAIST数据集上进行了消融实验,以检验通道注意力模块的加入、亮度增强模块的加入以及超分辨率重建模块中缩放残差的加入是否有必要。

如表3所示,第1行为未加入任何模块的近红外图像彩色化融合算法,作为空白对照实验组。第2行为加入通道注意力机制后的实验结果,与空白对照组相比PSNR值提升了3.951,SSIM值提升了0.061。第3行为加入亮度增强模块后的实验结果,与空白对照组相比PSNR值提升了11.937,SSIM值提升了0.41。第4行为未在超分辨率重建模块中加入缩放残差的实验结果,与空白对照组相比PSNR值提升了5.744,SSIM值提升了0.161。第5行为在超分辨率重建模块中加入缩放残差的实验结果,与第4行未加入缩放残差的相比PSNR值提升了0.344,SSIM值提升了0.031。由此可见,本文算法中的各部分都有助于达到更好的近红外图像彩色化效果。

Table 3. Results of ablation experiment

表3. 消融实验结果

4. 结论

文中提出了一种基于无监督图像融合和超分辨率重建方法相结合的近红外图像彩色化算法。在融合网络中,通道注意力机制模块的加入使得图像的细节特征能更好地被捕捉到,亮度增强模块的加入有助于彩色化后的图像亮度提升。在图像融合后,通过图像超分辨率重建使得彩色化后的图像细节被进一步刻画,极大程度地克服了图像融合过程中对图像分辨率造成的损失。主客观实验结果表明,在KAIST数据集和IVRL RGB-NIR数据集上本文算法都能够在一定程度上提升彩色化图像的质量。同时消融实验结果表明各个模块的加入都对整体网络起到了积极作用。后续将进一步对算法进行改进,使其适用于小样本训练集的近红外图像彩色化,以减少训练所需样本的数量及时间。

基金项目

上海市高水平高职院校建设项目。

NOTES

*通讯作者。