1. 引言

作为一种主动式微波遥感侦测平台,合成孔径雷达(SAR)具有全天候、全天监测和一定的穿透能力的优点,因此在军事和民用领域被广泛使用 [1] 。与可以直接被人眼解读的光学图像不同,SAR图像包含丰富的目标信息。然而,由于SAR的独特成像机制,SAR图像解读的任务变得具有挑战性 [2] 。此外,获取和标记SAR图像很困难,需要大量人力和物力资源。因此,SAR自动目标识别(SAR ATR)近年来成为研究的焦点。由于斑点噪声的存在,SAR图像具有特定的细粒度特征,表现为大的和小的类间差异。因此,SAR图像分类的任务仍然具有挑战性。

随着深度学习理论的发展,深度神经网络已广泛应用于各个领域 [3] 。在SAR ATR领域,与基于模板匹配 [4] 和模型匹配 [5] 的方法相比,基于深度神经网络的方法具有自动特征提取的优势。其中,最具代表性的方法是基于卷积神经网络(CNN)。CNN以层次方式收集局部特征,获得强大的图像表示,并可以充分提取SAR图像的局部纹理细节。2022年,Liu等人提出了一种纯卷积神经网络,名为ConvNeXt,它已成为最具代表性的CNN,相比传统的CNN,ConvNeXt算法更简洁,参数更少 [6] 。然而,受到卷积核大小的限制,CNN捕捉图像全局特征的能力较弱。因此,难以获得SAR图像元素之间的长距离关系,导致忽略了细粒度图像部分之间的语义信息关系 [7] 。

随着transformers [8] 的出现,卷积神经网络在计算机视觉领域的垄断地位正在逐渐被打破。与CNN的架构不同,transformer架构使用自注意机制来进行全局关系建模。2020年,Dosovitskiy [9] 等人提出了用于图像分类的Vision Transformer (ViT)模型。ViT模型是首个应用于计算机视觉领域的纯Transformer模型,通过将图像分割成多个块并将其编码为序列向量,解决了Transformer在图像领域的输入问题。这种方法在图像分类领域取得了出色的性能。然而,ViT模型具有大量的参数,计算成本高,对输入图像的大小有一定限制。为解决ViT模型的缺点,Liu等人提出了一种具有滑动窗口操作和分层设计的Swin Transformer模型,具有更高的效率 [10] 。然而,由于SAR图像子类别之间的细微差异,Swin Transformer模型提取SAR图像的局部细节特征能力较弱。模型对全局语义信息的依赖限制了其表示能力,而可区分的细节特征对于SAR图像分类任务至关重要。

SAR图像具有明显的细粒度特征,因此有必要进行全局建模以获取SAR图像的长距离依赖关系。然而,SAR图像具有低分辨率和模糊的边缘纹理细节,当仅对其进行全局建模时,很难将SAR目标与背景区分开来。因此,有必要获取它们的局部特征以增强其捕捉微妙差异的能力。为了充分利用SAR图像的细节多样性,抑制斑点噪声,改善SAR图像之间的小类差异问题,本文提出了一种名为MFN的三分支多尺度特征融合网络用于SAR图像分类。MFN模型结合了CNN和Swin Transformer架构的优点。受ConvNeXt和Swin Transformer模型的启发,MFN包括三个分支:ConvNeXt-SimAM、Swin Transformer和多尺度特征融合。多尺度特征融合分支可以从不同层次全面挖掘浅层细节特征和高级语义信息,并通过特征融合单元(FFU)融合SAR图像的局部特征和全局特征,增强SAR目标分类模型的表示能力。最后,使用贝叶斯超参数优化算法来优化模型的超参数,提高模型的分类性能。

2. 方法

2.1. ConvNeXt-SimAM分支

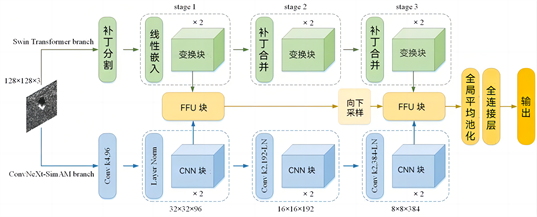

注:绿色部分代表Swin Transformer分支,蓝色部分代表CovNeXt-SimAM分支。蓝色部分代表CovNeXt-SimAM分支。黄色部分代表多尺度特征融合分支。

注:绿色部分代表Swin Transformer分支,蓝色部分代表CovNeXt-SimAM分支。蓝色部分代表CovNeXt-SimAM分支。黄色部分代表多尺度特征融合分支。

Figure 1. Structure of the multi-frequency network model

图1. 多频网络模型结构图

为了有效地获取不同尺度下合成孔径雷达车辆目标的局部细节特征和全局语义表示,我们结合了ConvNeXt和Swin Transformer模型的优点,设计了一个名为MFN的分类模型,该模型集成了不同尺度上的局部–全局特征。MFN模型的结构图如图1所示。这里提出的MFN模型包含三个分支:ConvNeXt-SimAM、Swin Transformer和多尺度特征融合。ConvNeXt-SimAM和Swin Transformer分支可以分为三个阶段,在不同层次上构建特征图。这三个阶段对应于4倍、8倍和16倍下采样。此外,特征图的高度和宽度减小,通道的数量增加,在同一阶段的特征维度保持不变。最后,不同尺度上的局部和全局特征由多尺度特征融合分支进行融合和分类。

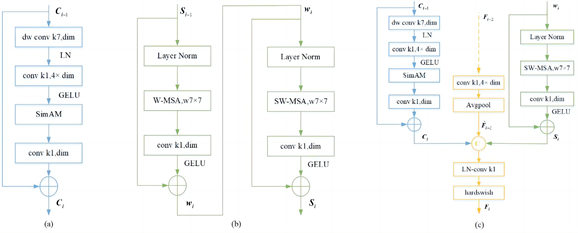

为了充分提取合成孔径雷达车辆目标的局部细节特征,我们通过堆叠CNN块和下采样操作构建了ConvNeXt-SimAM分支,并将整个分支划分为三个阶段,如图1所示。为了与Swin Transformer分支中每个阶段的特征图大小保持一致,ConvNeXt-SimAM分支中每个阶段的特征图的高度和宽度通过下采样卷积操作减小到前一阶段的一半,同时通道数增加一倍。此外,分别从第1阶段和第3阶段提取浅层局部细粒度信息和深层粗粒度信息,并将其发送到多尺度特征融合分支,该分支可以融合不同尺度的局部特征,增强模型的特征表示能力。CNN块的架构如图2(a)所示。受ConvNeXt的启发,CNN块由一系列组卷积、7 × 7卷积核大小、层归一化(LN)、1 × 1卷积、GELU激活函数、SimAM注意力模块和1 × 1卷积组成。为了引入额外的可学习参数,我们在CNN块的第二个卷积层(conv k1, 4 × dim)后插入了SimAM注意力模块,增强了CNN块的局部特征提取能力,以充分提取合成孔径雷达车辆的细节特征并抑制斑点噪声。与现有的通道注意力或空间注意力机制不同,SimAM模块可以从通道和空间维度的特征图中推导出三维注意力权重,而不添加额外的参数,这灵活而有效地增强了卷积模块的表示能力。Yang等人 [11] 基于神经学的发现为特征图上的每个神经元定义了能量函数,而输入特征是X∈RC × H × W,因此每个通道具有H × W个能量函数。通过最小化能量函数来评估每个神经元的重要性,并赋予对影响更大的神经元更高的权重,从而增强提取局部特征的能力并有效抑制噪声干扰。因此,最小化能量函数后的公式如式(1)所示:

其中,t代表X中的单通道的目标神经元,即像素值;𝜇和𝜎分别代表通道特征图上所有神经元的像素值的均值和方差;𝜆代表正则化系数。神经元t的能量越低,其重要性越高。

经过SimAM注意机制处理后,输入特征X的最终输出结果如下:

在ConvNeXt块中,首先进行组卷积𝑓𝑑7 × 7,卷积核大小为7 × 7,通道数为dim,其中组数等于通道数。使用组卷积可以减少模型的计算量。随后使用层归一化,然后使用卷积操作𝑓1 × 1,卷积核大小为1 × 1,通道数为4 × dim来升级维度。最后,使用GELU激活函数和卷积操作𝑓1 × 1,卷积核大小为1 × 1,通道数为dim进行降维。CNN块的过程如下:

其中

表示CNN块的输出特征,LN是一个层归一化层。

2.2. Swin Transformer分支

Swin Transformer分支的工作流程如图1所示。通过三个阶段,Swin Transformer分支构建了不同大小的特征图。在第一阶段,特征图首先通过补丁划分和线性嵌入层进行分割,并在通道方向上进行平铺。然后通过补丁合并层进行降采样,并增加通道维度以构建多阶层次结构。每个阶段都堆叠了N个Trans块,其结构如图2(b)所示。由于Trans块中包含W-MSA和SW-MSA两个结构,通常都是成对使用的,所以N取偶数。为了避免模型参数数量的大幅增加,N的值取为2。

注:(a) 卷积神经网络模块架构;(b) 两个连续的转换模块架构;(c) 第3阶段中的特征融合过程

注:(a) 卷积神经网络模块架构;(b) 两个连续的转换模块架构;(c) 第3阶段中的特征融合过程

Figure 2. Diagrams of different processes

图2. 不同过程的示意图

引入Swin Transformer分支可以增强ConvNeXt-SimAM分支捕捉全局语义信息的能力。如图1所示,输入图像经过第一阶段后,特征图的大小变为32 × 32 × 96。随后,通过补丁合并操作对特征图进行降采样。特征图的高度和宽度减半,通道数加倍。Trans块的结构如图2(b)所示。首先,特征图Si − 1通过层归一化层进入窗口多头自注意力(W-MSA)模块,在每个窗口中计算自注意力,大大降低计算复杂度。然后,通过卷积层(卷积核大小为1 × 1)和GELU激活函数进行处理。最后,在每个模块后应用残差连接。接下来的模块中引入了移位窗口多头自注意力(SW-MSA)模块,其它层保持不变。SW-MSA的引入可以实现不同窗口之间的交互作用。Trans块的计算过程如下所示:

其中

是W-MSA层的输出特征,

是Trans块的输出特征。

多尺度特征融合分支为提高SAR图像分类模型的识别精度,有必要融合不同尺度上的局部特征和全局特征。同时,为尽可能保留局部特征和全局特征,实现了一个多尺度特征融合分支。多尺度特征融合分支能够根据输入特征自适应地融合局部特征、不同尺度下的全局表示以及前一级融合的语义信息。多尺度特征融合分支的工作流程如图1所示。我们通过多尺度特征融合分支捕捉了第1阶段的浅层局部和全局特征以及第3阶段的深层局部和全局语义信息。最后,融合路径的特征信息逐渐填补语义差距,并通过连接全局平均池化层和全连接层得到最终输出。

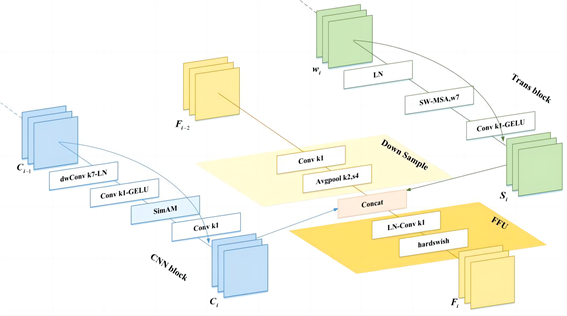

如图3所示,多尺度特征融合分支由FFU和下采样操作组成。其中,FFU包括LN层、卷积核尺寸为1 × 1的卷积层以及硬切线激活函数。第3阶段的具体过程如图2©所示。首先,通过卷积核尺寸为1 × 1和平均池化层(Avgpool),将前一阶段的FFU输出特征

向下采样,然后调整通道维度以便后续的融合操作。通过局部特征

和来自ConvNeXt-SimAM和Swin Transformer分支的全局特征

,经过LN层进行归一化后,利用卷积核尺寸为1 × 1和硬切线激活函数进行融合。最后,本阶段融合的特征

有效捕捉了SAR图像的局部特征和全局语义信息。得到的特征

随后通过全局平均池化和全连接层进行分类:

其中,O表示模型的最终输出,FC表示全连接层,glo_avg_pool表示全局平均池化。

注:绿色部分代表Trans块,蓝色部分代表CNN块结构,黄色部分是通过下采样操作从前一个FFU的输出特征到下一个FFU的过程。

注:绿色部分代表Trans块,蓝色部分代表CNN块结构,黄色部分是通过下采样操作从前一个FFU的输出特征到下一个FFU的过程。

Figure 3. Implementation details of the CNN block, Trans block, and FFU block in stage 3

图3. 第3阶段的CNN块、Trans块和FFU块的实现细节

基于贝叶斯超参数优化算法的多重因素网络(Bayes-MFN)由于深度神经网络模型的复杂性,手动参数调整可能耗时费力,而且由于该模型常被视为黑盒方法,也可能无法找到最佳超参数组合。要建立最优的神经网络模型,优化超参数尤为重要。与传统的网格搜索和随机搜索方法相比,贝叶斯优化算法的算法框架是连续的。也就是说,贝叶斯优化方法通过使用先验知识来近似未知函数的后验分布,从而调整最佳超参数组合,减少大量不必要的计算。由于贝叶斯优化方法能够在有限的函数采样值下获得复杂目标函数的最优值,因此在许多领域中备受青睐。超参数可以分为模型训练相关的参数和模型结构相关的参数两组。由于所提出模型的设计旨在以更少的可学习参数实现更好的分类性能,模型结构相关的超参数是固定的。与模型训练相关的超参数的适当选择可以使神经网络学习更快且性能更好。在训练过程中,批量大小影响模型的泛化性能,学习率(lr)决定模型的收敛状态 [12] 。此外,热身和衰减(wd)超参数与深度神经网络模型的稳定性密切相关。适当的epoch大小可以帮助避免模型的过拟合或欠拟合。因此,有必要针对这四个超参数执行贝叶斯优化,将损失函数作为目标函数。本研究采用了Python中HyperOpt包提供的贝叶斯优化算法,以更少的步骤实现超参数优化 [13] 。在本文中,选择了树状帕尔泽估计器(TPE)搜索算法 [14] 进行高效的超参数优化。优化超参数的过程如下:(1) 定义一个最小化的目标函数,(2) 定义待优化的超参数和搜索空间,以及(3) 选择搜索算法 [15] 。采用TPE算法通过最小化损失函数来找到最佳超参数组合。

3. 实验和结果

3.1. MSTAR数据集

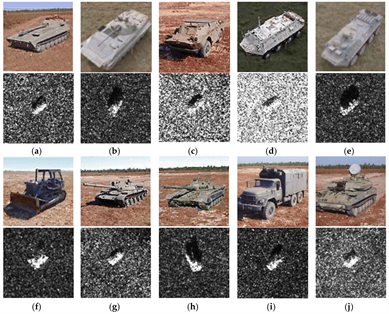

为了评估提出的模型的性能,我们使用了移动和静止目标获取与识别(MSTAR)数据集 [16] ,该数据集由美国国防高级研究计划局和空军实验室于上世纪90年代中期发布。MSTAR数据集中的合成孔径雷达(SAR)军用车辆是由分辨率为0.3米的高分辨率聚焦SAR采集的,工作在X频段和HH偏振模式下。采集条件可分为标准操作条件(SOCs)和扩展操作条件(EOCs) [17] 。SOC指的是训练集和测试集样本的低次角度和外观略有不同,但样本的序列号和目标配置相同的情况。相反,EOC指的是训练集和测试集在俯仰角度、目标定义和其他因素上有显著差异的情况,使之成为比SOC更复杂的分类任务。MSTAR数据集包含了各种尺寸的SAR图像,包括128 × 128、158 × 158和177 × 178像素。为了保持目标尺寸的一致性,原始图像在不影响目标的情况下均匀剪裁为128 × 128像素。在SOC分类中,共有10种车辆目标,包括BMP2 (步兵战斗车)、BRDM2 (装甲侦察车)、BTR60 (装甲运输车)、BTR70 (装甲运输车)、D7 (推土机)、T62 (坦克)、T72 (坦克)、ZIL131 (货车)、ZSU234 (自行式防空炮)和2S1 (自行式榴弹炮)。训练和测试样本分别是在17˚和15˚俯仰角下拍摄的图像。图4显示了MSTAR数据集中不同车辆目标的光学图像和SAR图像。从图中可以明显看出,SAR图像具有低分辨率和模糊的目标边缘信息,使得每个车辆目标在视觉上难以区分。

Figure 4. Ten class vehicle targets for optical images (top) and SAR images (bottom)

图4. 针对光学图像的十类车辆目标(上方)和SAR图像(下方)

根据EOC分类,训练集和测试集之间存在很大差异,如不同的俯仰角;然而,数据集中的目标类别比SOC更相似。因此,分类任务更复杂,模型的鲁棒性比SOC下更为重要。根据之前的研究 [18] ,本研究关注三种地面铰接式车辆目标:T72、BRDM2和ZSU234。训练和测试样本分别采集于17˚和30˚的俯仰角。

3.2. 实验设置

表1显示了SAR军车数据集上MFN模型的架构细节。分辨率为128 × 128的输入图像同时通过CovNeXt-SimAM和Swin Transformer分支进行处理。每个分支分为三个阶段,以获取不同尺度上的局部和全局特征。

Table 1. Specific parameters of MFN model

表1. MFN模型的具体参数

注:d7 × 7、96这样的表达形式是输出的简写形式,其中d代表组卷积,7 × 7代表卷积核大小,96代表通道数。Avgpool k2, s4表示采用2 × 2的池化窗口大小和步长为4进行的平均池化操作。

随后,通过多尺度特征融合分支获得包含丰富SAR特征信息的融合特征。在全局平均池化之后,SAR特征通过全连接层进行分类。

3.3. MSTAR实验结果与分析

3.3.1. 贝叶斯超参数优化结果

采用贝叶斯方法对MFN的四个超参数进行优化:epoch、学习率(lr)、预热和衰减(wd)超参数以及批量大小。SOC和EOC实验中贝叶斯优化的结果如表2所示。下一个实验将使用最优的超参数集对SAR图像进行分类。

Table 2. Optimization results of Bayesian hyperparameters in SOC and EOC experiments using the MSTAR dataset

表2. 在MSTAR数据集上使用贝叶斯超参数进行SOC和EOC实验的优化结果

3.3.2. SOC实验结果

在SOC实验中,表3展示了关于10种SAR车辆目标的详细信息。在训练集和测试集中,17˚和15˚俯仰角度下,分别有2747个和2452个SAR车辆数据样本。

Table 3. Detailed information on vehicle targets under SOC in the MSTAR dataset

表3. MSTAR数据集中SOC下车辆目标的详细信息

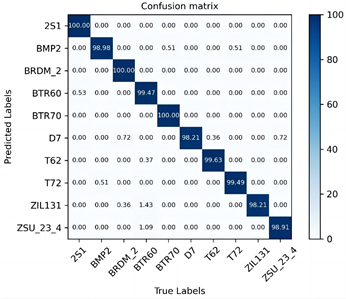

在SOC实验中,所提出模型对于10种车辆目标的识别结果的混淆矩阵如图5所示。测试集中的数据基本上集中在对角线上,表明这些目标被正确分类到它们的类别中,整体识别准确率达到了99.26%。在SOC实验中,所提出模型的平均精确度、召回率和F1分数分别达到了99.18%、99.29%和99.23%。2S1、BRDM2和BTR70三种类型的精确度达到了100%。混淆矩阵显示,ZIL131的精确度是最低的,一些ZIL131的数据被错误地识别为BRDM2和BTR60,可能是因为ZIL131、BRDM2和BTR60作为卡车具有较高的相似性。总体而言,在SOC实验中,所提出的模型展现了良好的识别性能,有效验证了其有效性。

Figure 5. Ten categories of SAR vehicle target confusion matrix under SOC

图5. SAR (合成孔径雷达)车辆目标混淆矩阵的十个类别

3.3.3. EOC实验结果

对于EOC实验,表4中展示了三种类型的SAR (合成孔径雷达)车辆关节目标的详细信息。在训练和测试数据集中,分别有17度和30度俯仰角的SAR车辆数据样本896个和384个。由于SAR数据样本较少,目标类别之间的相似性较高,俯仰角之间的差异较大,因此识别任务比SOC实验更具挑战性,需要更高的模型性能。

Table 4. Detailed information on vehicle targets under EOC in the MSTAR dataset

表4. MSTAR数据集中EOC下车辆目标的详细信息

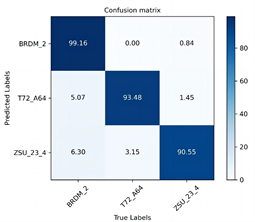

在EOC实验中,所提出模型的混淆矩阵如图6所示,用于展示三种类型车辆目标的识别结果。其识别准确率略低于10种目标的分类准确率,但仍达到94.27%。在EOC实验中,所提出模型的平均精确率、召回率和F1得分分别达到94.39%、94.40%和94.24%。结果表明,所提出的模型具有良好的泛化性和鲁棒性。

Table 5. Experimental results of MSTAR dataset ablation

表5. MSTAR数据集脱敏实验的实验结果

3.4. 脱敏实验

表5呈现了进行脱敏实验的结果,以评估每个组成部分对提出的模型在MSTAR数据集上性能的个别影响。评估过程包括从本地路径(ConvNeXt分支)开始;添加Swin Transformer分支、SimAM注意力模块和贝叶斯优化超参数;最后形成我们的模型。

ConvNeXt分支在SOC和EOC下的准确率分别为86.52%和69.01%。添加Swin Transformer分支后,准确率分别提高了8.61%和23.7%,表明仅考虑局部特征是不足够的。局部细节和全局语义特征的融合显著提高了模型的性能,验证了提出的方法。在ConvNeXt分支中增加SimAM注意力模块后,SOC和EOC下的准确率分别提高了1.08%和0.26%,表明注意力机制可以提升模型的特征提取和表达能力。

Figure 6. Three categories of SAR vehicle target confusion matrix in EOC experiments

图6. EOC实验中SAR(合成孔径雷达)车辆目标混淆矩阵的三个类别

Table 6. Comparison between Bayesian optimization hyperparameters and empirical selection

表6. 贝叶斯优化超参数和经验选择的比较

最后,使用贝叶斯优化算法来优化模型的超参数,SOC和EOC实验的准确率分别提高了3.05%和1.3%。此外,本研究比较了贝叶斯超参数优化算法和经验选择超参数对模型分类性能的影响。在SOC和EOC下,贝叶斯算法优化的超参数集和经验选择的超参数集的结果如表6所示。此外,使用经验选择的超参数集和贝叶斯超参数优化算法优化的超参数集对MFN模型进行对比的结果如表7所示。

Table 7. Comparison of model performance before and after using the Bayesian optimization algorithm in the MSTAR dataset

表7. MSTAR数据集中使用贝叶斯优化算法前后模型性能的比较

如表7结果表明,使用贝叶斯优化算法有效地提高了模型在SOC和EOC下的分类性能,涵盖了所有四个评估指标。此外,在模型优化过程中,贝叶斯超参数优化算法显著节省了时间和资源。

4. 结论

1) 在SAR自动目标识别技术中,散斑噪声会对分类模型的性能产生负面影响。为了解决这个问题,提出了一种MFN方法,通过并行化方法来保留SAR局部细节特征和全局语义信息,以增强SAR纹理细节特征,并改善散斑噪声引起的类内差异大和类间距离小等问题。

2) 采用贝叶斯超参数优化算法对MFN的超参数进行优化。实验结果表明,所提出的模型在MSTAR数据集上具有特定的泛化性和有效性。同时,与其他主流模型相比,Bayes-MFN在SOCs和EOCs下取得了出色的性能。

3) 设计了并行的局部和全局特征分支,以充分探索不同层次上的局部和全局特征。此外,还添加了SimAM注意机制到局部特征模块中,以增强网络特征的学习能力。这种增强使得网络能够更多关注有限特征信息中SAR图像的纹理细节,并有效抑制散斑噪声。构建了多尺度特征融合分支,其中包括FFU和下采样模块。该分支自适应地融合了不同尺度上的局部细节特征和全局语义信息。提出了基于贝叶斯超参数优化算法的三分支多尺度特征融合模型,充分结合了ConvNeXt和SwinTransformer的优势,在MSTAR数据集上以更少的参数和更高的识别准确性取得了出色的结果。